Googles MobileDiffusion erzeugt KI-Bilder auf Mobilgeräten in weniger als einer Sekunde

Googles MobileDiffusion ist eine effiziente Lösung für die Text-zu-Bild-Generierung und ermöglicht eine noch nie dagewesene Geschwindigkeit auf mobilen Geräten.

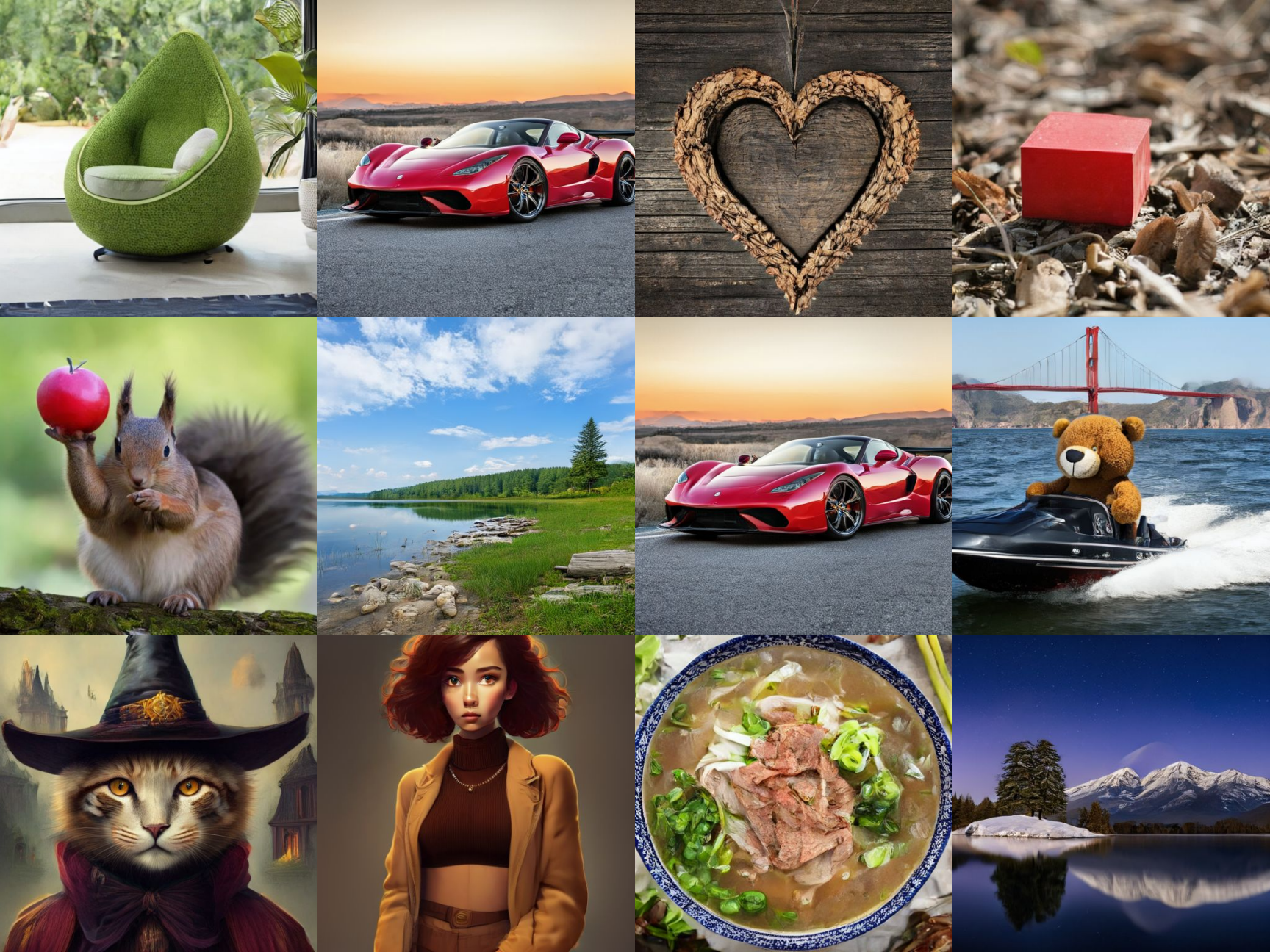

MobileDiffusion ist die neueste Entwicklung von Google im Bereich der Text-zu-Bild-Generierung. Das Diffusionsmodell wurde speziell für Smartphones entwickelt und soll aus Texteingaben in weniger als einer Sekunde qualitativ hochwertige Bilder erzeugen.

Mit einer Modellgröße von nur 520 Millionen Parametern ist es deutlich kleiner als Modelle mit Milliarden von Parametern wie Stable Diffusion und SDXL und damit besser an die Leistungsfähigkeit mobiler Geräte angepasst.

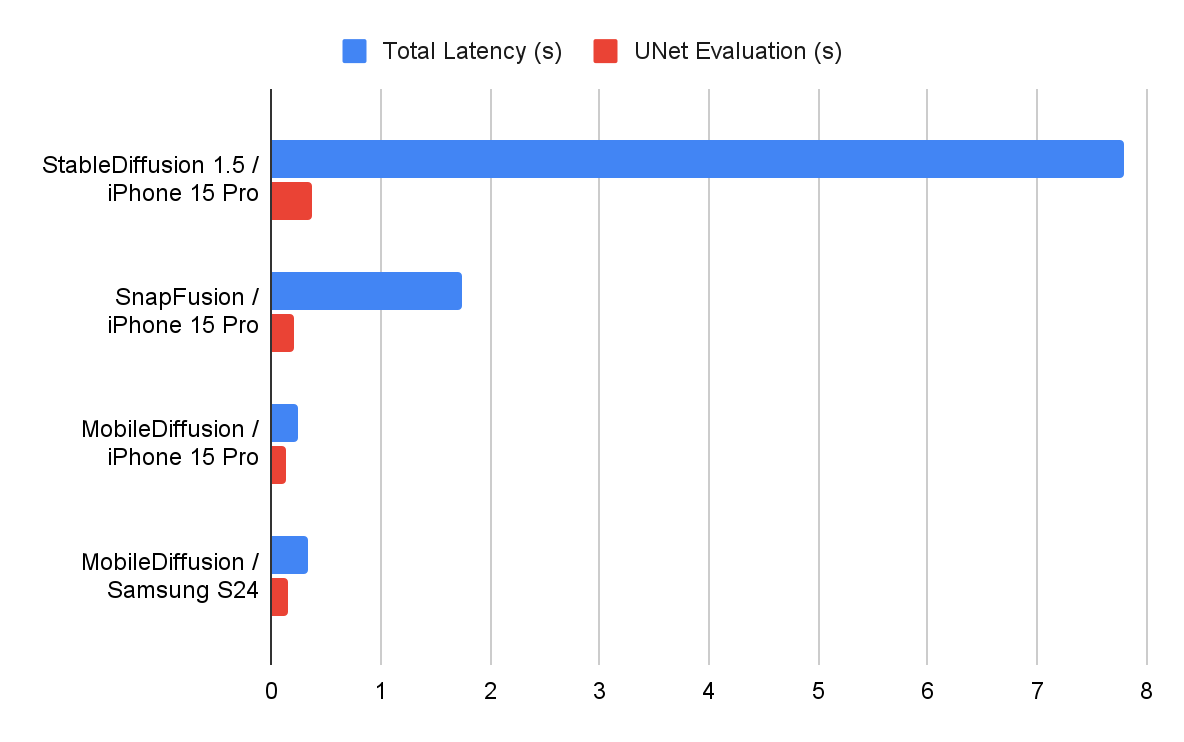

Tests der Forschenden zeigen, dass MobileDiffusion sowohl auf Android-Smartphones als auch auf iPhones Bilder mit einer Auflösung von 512 x 512 Pixeln in rund einer halben Sekunde liefern kann. Dabei wird das Ergebnis bereits während der Eingabe laufend aktualisiert, wie Demovideos von Google zeigen.

Video: Google

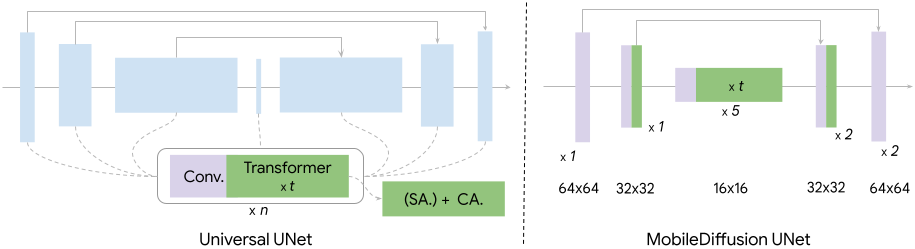

MobileDiffusion besteht aus drei Hauptkomponenten: einem Textencoder, einem Diffusions-UNet und einem Bilddecoder.

Das UNet enthält eine Self-Attention-Schicht, eine Cross-Attention-Schicht sowie eine Feed-Forward-Schicht, die entscheidend für das Textverständnis in Diffusionsmodellen sind.

Diese Schichtenarchitektur ist jedoch rechnerisch aufwendig. Google verfolgt hier die sogenannte UViT-Architektur, bei der mehr Transformer-Blöcke in einem Bereich niedriger Dimensionalität des UNet platziert werden, um den Ressourcenbedarf zu reduzieren.

Hinzu kommen der Einsatz von Destillation und ein Hybrid mit einem Generative Adversarial Network (GAN) für ein- bis achtstufiges Sampling.

Google hat das Modell bislang nicht frei zugänglich gemacht und auch keine Pläne dahin gehend geäußert. Vielmehr sei die Forschung als Schritt hin zum "Ziel der Demokratisierung der Text-zu-Bild-Erzeugung auf Mobilgerät" zu verstehen.

Mit der Pixel-Serie betreibt Google seine eigene Smartphone-Familie, in der bei Hard- und Software das Thema generative KI einen immer größeren Fokus einnimmt.

Bildgenerierung wird immer schneller

Zuletzt hatte vor allem Qualcomm auf Basis von Stable Diffusion gezeigt, wie schnell sich Bilder auf einem Smartphone generieren lassen. Durch Optimierungen mit dem AI-Stack von Qualcomm konnte der US-Chiphersteller den Bildgenerator auf einem aktuellen Android-Smartphone ausführen, was zu dem Zeitpunkt im Februar 2023 einen bemerkenswerten technologischen Fortschritt darstellte.

Allerdings dauerte die Erstellung eines Bildes mit 512 x 512 Pixeln und 20 Inferenzschritten damals mit rund 15 Sekunden noch deutlich länger.

Der Vorteil von Googles MobileDiffusion-Ansatz ist zudem, dass er systemunabhängig auch auf dem aktuellen iPhone 15 Pro schnelle Ergebnisse liefert, die sogar besser sind als auf Samsungs neuestem Flaggschiff Galaxy S24, das mit Googles Android läuft.

Seitdem haben auch SDXL Turbo oder PixArt-δ deutliche Fortschritte im Bereich der Quasi-Echtzeit-Bildgenerierung gemacht, allerdings auf leistungsfähigeren Systemen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.