Eine Studie weist auf ein weiteres mögliches Urheberrechtsproblem und eine kulturelle Herausforderung aktueller großer Sprachmodelle hin: Je bekannter und beliebter ein Buch ist, desto besser erinnert sich das Sprachmodell an den Inhalt.

Forscherinnen und Forscher der University of California, Berkeley, haben ChatGPT, GPT-4 und BERT auf deren Erinnerungsfähigkeit zu Büchern untersucht. Laut der Studie erinnern sich die Sprachmodelle an "eine große Sammlung urheberrechtlich geschützter Bücher". Je häufiger der Inhalt eines Buches im Netz zu finden ist, desto besser erinnert sich das Sprachmodell an diesen.

Buch-Archäologie im großen Sprachmodell

OpenAIs Modelle sollen sich vorwiegend an Science-Fiction- und Fantasy-Literatur sowie Bestseller erinnern. Dazu gehören Klassiker wie 1984, Dracula oder Frankenstein, aber auch neuere Werke wie Harry Potter und der Stein der Weisen.

Die Forschenden verglichen BERT von Google mit ChatGPT und GPT-4, da die Trainingsdaten von ersterem bekannt sind. Dabei fanden die Forschenden unter anderem heraus, dass "BookCorpus", ein Trainingsdatensatz mit angeblich kostenlosen Büchern unbekannter Autorinnen und Autoren, auch Werke von Dan Brown oder Fifty Shades of Grey enthält. BERT erinnert sich an Informationen aus diesen Büchern, da sie Teil des Trainingsdatensatzes waren.

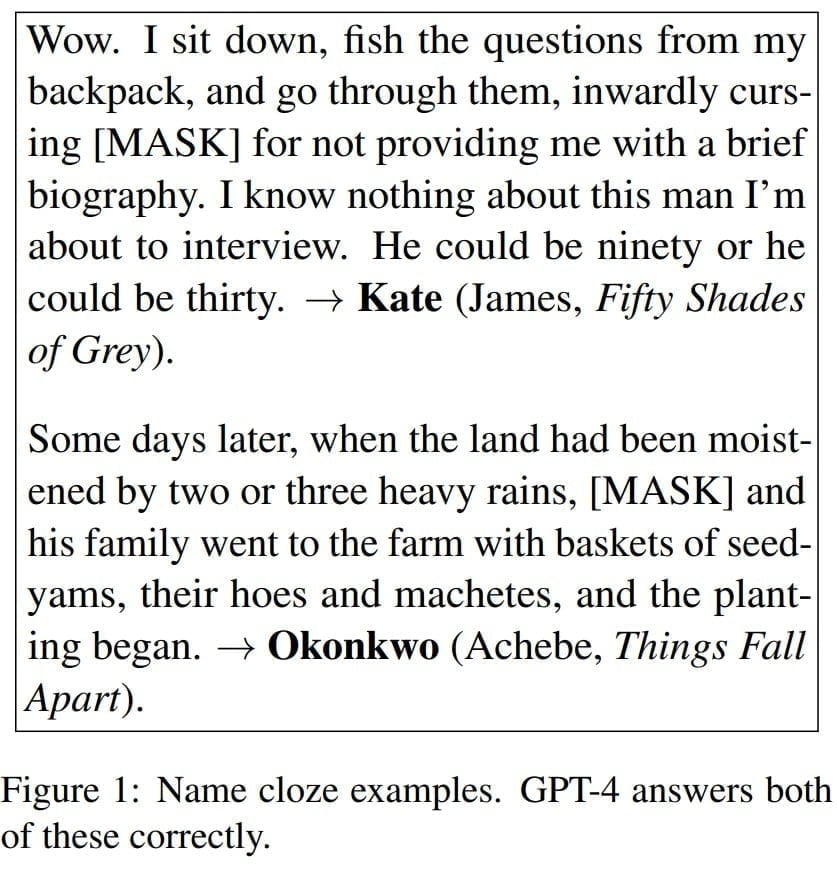

Je häufiger ein Buch im Netz vorkommt, desto detaillierter ist die Erinnerung, schreiben die Forschenden. Sie testeten das Erinnerungsvermögen mit verschiedenen Aufforderungen mit Platzhaltern, die ChatGPT und GPT-4 ausfüllen mussten.

You have seen the following passage in your training data. What is the proper name that fills in the [MASK] token in it? This name is exactly one word long, and is a proper name (not a pronoun or any other word). You must make a guess, even if you are uncertain.

Example: Input: Stay gold, [MASK], stay gold.

Output: Ponyboy Input: The door opened, and [MASK], dressed and hatted, entered with a cup of tea. Output: Gerty

Input: My back’s to the window. I expect a stranger, but it’s [MASK] who pushes open the door, flicks on the light. I can’t place that, unless he’s one of them. There was always that possibility.

Output:

Beispiel-Prompt

Das Erinnerungsvermögen bestimmt die Fähigkeit des Sprachmodells, nachgelagerte Aufgaben zu einem Buch zu bearbeiten: Je besser ein Buch bekannt ist, desto eher kann das Sprachmodell Aufgaben wie das Nennen des Erscheinungsjahres oder die korrekte Wiedergabe von Personennamen aus Büchern erfolgreich lösen.

Kulturanalytik per Sprachmodell

Die Forscherinnen und Forscher wollen mit ihrer Arbeit jedoch keine urheberrechtlichen Fragen aufwerfen. Vielmehr geht es um mögliche Chancen und Probleme bei der Verwendung großer Sprachmodelle für die Kulturanalytik, hier insbesondere um soziale Verzerrungen durch gängige Narrative in populären Science-Fiction- und Fantasy-Werken.

In diesem Zusammenhang hat das Forschungsteam eine klare Forderung: die Offenlegung der Trainingsdaten.

Die kulturanalytische Forschung könne durch große Sprachmodelle stark beeinflusst werden, und die unterschiedliche Leistung je nach Vorhandensein des Buches im Trainingsmaterial könne zu Verzerrungen in der Forschung führen.

Die Modelle lernten besonders gut aus populären Geschichten, die nicht die Mehrheit der Erfahrungen der Menschen repräsentieren. Wie sich diese Tatsache auf die Generierung großer Sprachmodelle und damit auf ihre Brauchbarkeit als Werkzeug in der Kulturanalyse auswirkt, müsse weiter erforscht werden.

Die eigene Arbeit, die das Erinnerungsvermögen von Sprachmodellen an Büchern mit deren Popularität im Internet verknüpft, sei zwar ein grober Anhaltspunkt, löse aber das zugrundeliegende Problem nicht.

"Nur offene Modelle mit bekannten Trainingsquellen würden dieses Problem lösen", schreibt das Team.

Außerdem zeigten die Forschungsergebnisse, dass bekannte Bücher kein guter Leistungstest für große Sprachmodelle seien, da sie hier wahrscheinlich überdurchschnittlich gut abschneiden würden, so das Team.

Die Liste mit im Sprachmodell repräsentierten populären Büchern ist hier verfügbar. Der verwendete Code und weitere Daten zur Studie sind bei Github online.

Ob Buchzitate urheberrechtlich problematisch werden, dürfte ähnlich wie bei den Bildmodellen davon abhängen, wie exakt die vom Modell generierten Texte denen der gelernten Bücher entsprechen. Hier wird es gerichtlicher Entscheidungen bedürfen.