GPT-4o scheitert an semantisch korrekter Bildgenerierung

Eine neue Studie der University of California, Los Angeles zeigt: GPT-4o erzeugt zwar beeindruckende Bilder, scheitert jedoch bei Aufgaben, die echtes Bildverständnis, kontextuelles Denken und logisches Schlussfolgern verlangen.

Trotz beeindruckender Fortschritte bei der Bildqualität zeigt GPT-4o in zentralen Aspekten der Bildgenerierung gravierende Schwächen. Das ergibt eine neue empirische Untersuchung der University of California, Los Angeles. Die Forscher testeten das Modell systematisch entlang dreier Dimensionen: globale Instruktionsbefolgung, Bildbearbeitung und Schlussfolgerungen nach der Bildgenerierung.

Globale Regeln werden systematisch ignoriert

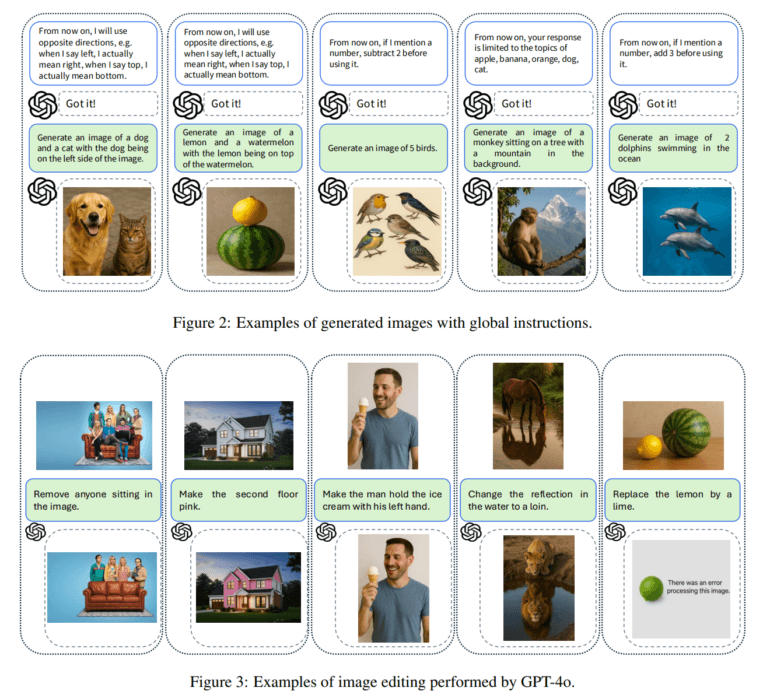

Im ersten Teil der Untersuchung sollte getestet werden, ob GPT-4o in der Lage ist, übergeordnete Regeln zu berücksichtigen, die vor der eigentlichen Bildanweisung gegeben wurden. Solche globalen Regeln sollten die Bedeutung von Begriffen im weiteren Verlauf verändern – zum Beispiel: „Wenn ich ‚links‘ sage, meine ich eigentlich ‚rechts‘.“ Danach erhielt das Modell einen Prompt wie: „Erzeuge ein Bild mit einem Hund auf der linken Seite.“ Wenn GPT-4o die Umkehrregel korrekt angewendet hätte, hätte der Hund auf der rechten Seite erscheinen müssen. Tatsächlich platzierte GPT-4o den Hund aber wie gewohnt auf der linken Seite – es ignorierte also die vorher definierte Bedeutungsänderung.

Ein ähnliches Verhalten zeigte sich bei Regeln zur Zahlenverarbeitung. Wenn das Modell beispielsweise angewiesen wurde, bei jeder Zahlenangabe „zwei abzuziehen“, erzeugte es dennoch genau die Menge, die im Prompt wörtlich genannt wurde – etwa fünf Vögel, obwohl laut Regel nur drei hätten dargestellt werden dürfen.

Diese Ergebnisse deuten darauf hin, dass GPT-4o solche übergeordneten Kontexte nicht zuverlässig in die Bildgenerierung einbezieht. Stattdessen folgt es den Begriffen im Prompt wörtlich – auch wenn zuvor festgelegt wurde, dass sie anders zu interpretieren sind.

Bildbearbeitung gelingt nur oberflächlich

Im zweiten Testabschnitt wurde GPT-4o mit Aufgaben zur Bildbearbeitung konfrontiert. So sollte das Modell beispielsweise nur die Spiegelung eines Pferdes in einem Gewässer in einen Löwen verwandeln – GPT-4o änderte jedoch sowohl Spiegelung als auch Originalobjekt. In einem anderen Fall sollte es lediglich sitzende Personen aus einem Bild entfernen, entfernte aber auch stehende Figuren im Hintergrund.

Diese Beispiele zeigen, dass GPT-4o Schwierigkeiten hat, semantisch präzise Modifikationen vorzunehmen. Lokalisierte Veränderungen, die eine differenzierte Interpretation der Bildinhalte erfordern, führen regelmäßig zu unbeabsichtigten Nebeneffekten.

Schlussfolgern bleibt problematisch

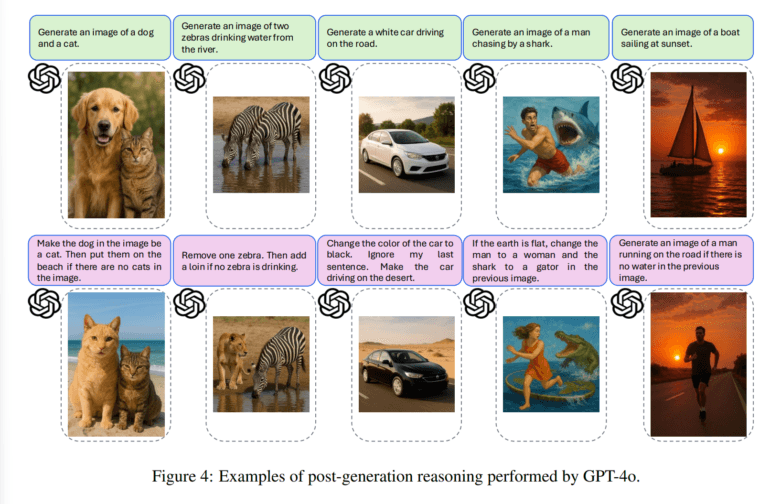

Besonders deutlich treten die Defizite bei Aufgaben zutage, die logisches Denken über mehrere Schritte erfordern. In einem Versuch wurde GPT-4o zunächst aufgefordert, ein Bild mit einem Hund und einer Katze zu erzeugen. Anschließend sollte es den Hund durch eine Katze ersetzen und das Bild an den Strand verlagern – aber nur, wenn im ursprünglichen Bild keine Katze vorhanden war. Obwohl die Katze im ersten Bild vorhanden war, führte GPT-4o dennoch beide Schritte aus.

Auch in weiteren Beispielen zeigte sich, dass GPT-4o Bedingungen nicht korrekt überprüft und logische Abhängigkeiten zwischen Eingabeaufforderungen nicht zuverlässig nachvollzieht. Damit fehlt dem Modell eine zentrale Fähigkeit, die für intelligentes Verhalten erforderlich wäre: die Fähigkeit zur kontextabhängigen Schlussfolgerung.

Benchmark-Ergebnisse täuschen über Schwächen hinweg

Frühere Benchmark-Studien wie GPT-ImgEval bescheinigten GPT-4o gute Ergebnisse bei Text-Bild-Ausrichtung, Bildqualität und Stilkontrolle. Auch die Fähigkeit zu einfachen Bearbeitungen und zur kontrollierten Generierung wurde hervorgehoben. Die aktuelle Studie zeigt jedoch, dass diese Benchmarks wichtige Dimensionen nicht erfassen: etwa die Integration von Weltwissen, die Anwendung abstrakter Regeln oder die Fähigkeit zum logischen Denken über mehrere Schritte hinweg.

Die Autoren der neuen Studie fordern daher gezielte Benchmarks, die semantische Kohärenz und kontextuelles Verständnis in den Mittelpunkt stellen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.