GR00T-Dreams: Nvidias KI-Videosystem lässt Roboter von neuen Fähigkeiten träumen

Nvidia stellt eine neue GR00T-Generation und ein KI-basiertes Videosystem für Robotertraining vor.

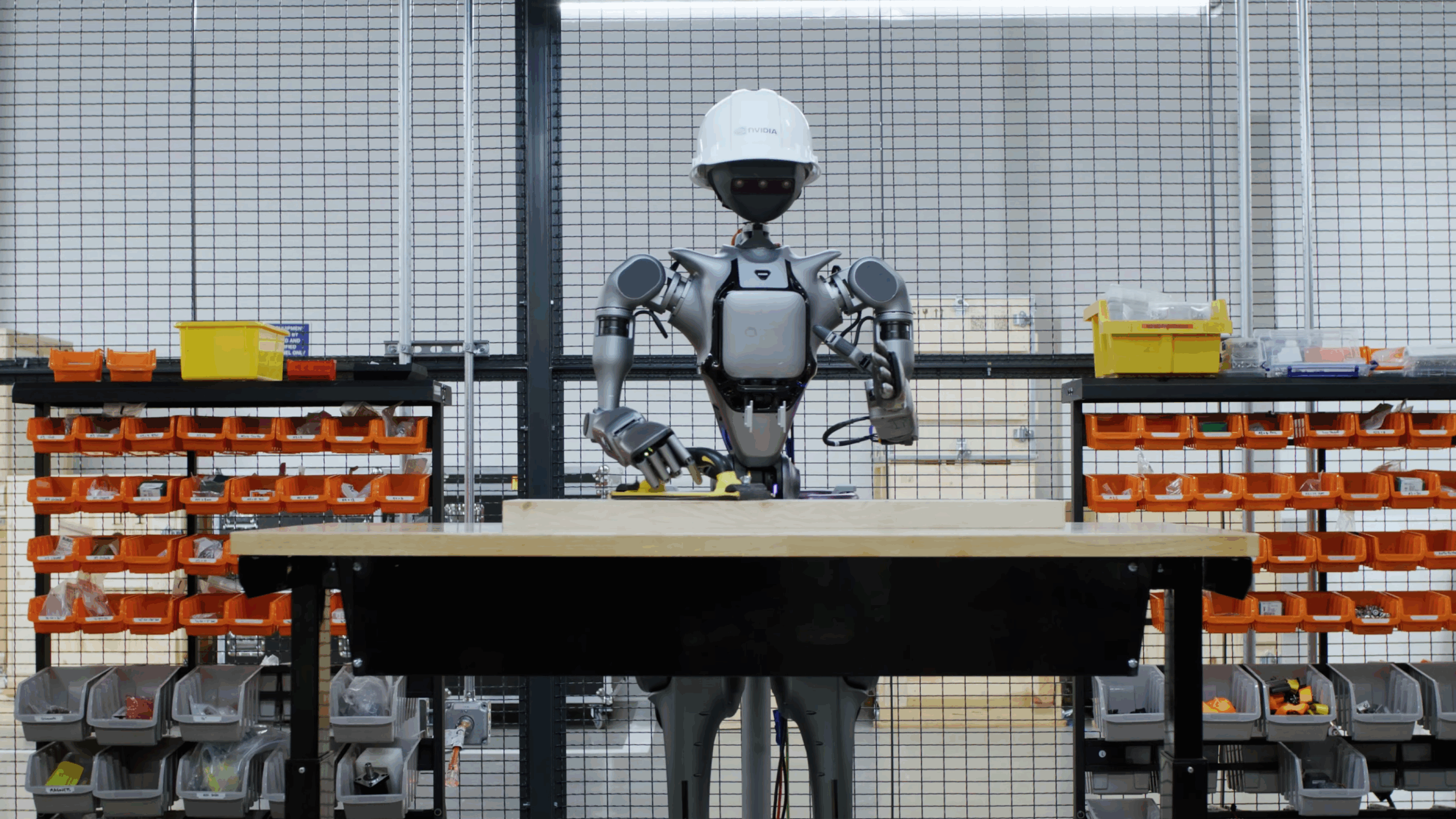

Nvidia stellte auf der Computex 2025 die aktualisierte Version seines Foundation-Modells GRooT für humanoide Roboter vor. GR00T N1.5 ist eine Weiterentwicklung des im März vorgestellten GR00T N1 und kann unter anderem auf neue Umgebungen reagieren sowie Aufgaben in der Materialhandhabung erkennen und ausführen.

Das Modell basiert auf einer Dual-System-Architektur: System 2 übernimmt kognitive Prozesse wie Planung, System 1 steuert die motorische Ausführung in Echtzeit. Ziel ist es, generalisierte Denk- und Handlungskompetenzen in humanoiden Robotern zu verankern – ähnlich wie es große Sprachmodelle im Bereich Sprache leisten.

GR00T N1.5 konnte laut Nvidia innerhalb von nur 36 Stunden mithilfe synthetischer Daten trainiert werden – herkömmliche Methoden würden dafür rund drei Monate benötigen.

Erste Anwender sind laut Nvidia AeiRobot, Foxlink, Lightwheel und NEURA Robotics. AeiRobot nutzt das Modell beispielsweise, um industrielle Pick-and-Place-Workflows mit natürlicher Sprache zu steuern. Foxlink will damit die Flexibilität von Industrierobotern verbessern, Lightwheel validiert mit dem Modell synthetische Trainingsdaten für humanoide Roboter in der Fertigung.

GR00T-Dreams erzeugt Trainingsdaten aus KI-generierten Videos

Mit GR00T-Dreams stellt Nvidia zudem einen neuen Blueprint vor, der bildgesteuerte KI-Videomodelle zur Erzeugung synthetischer Bewegungsdaten nutzt. Entwickelt wurde das System unter der Leitung von Jim Fan, der bei Nvidia die Forschungsgruppe für verkörperte generative KI führt.

Der Ablauf: Entwickler trainieren zunächst ein Weltmodell mit Cosmos Predict. Anschließend erzeugt GR00T-Dreams aus einem einzelnen Bild ein Video, das zeigt, wie ein Roboter eine neue Aufgabe in einer neuen Umgebung ausführt. Daraus extrahiert das System sogenannte Aktions-Tokens – komprimierte Datenfragmente, die dem Roboter neue Verhaltensweisen beibringen sollen.

Während reale Roboter nur begrenzt Daten pro Tag liefern können, lassen sich mit GR00T-Dreams Daten in beliebiger Menge erzeugen. Die Videos stammen aus dem KI-Videogenerator Cosmos, der zuvor mit Robotervideos aus Nvidias Lab feinjustiert wurde. Die synthetischen Daten werden dann in die Trainingspipeline eingespeist.

Neue Simulationssysteme sollen die Sim2Real-Lücke weiter verkleinern

Um die Trainings- und Testprozesse weiter zu beschleunigen, stellt Nvidia auch Updates für mehrere offene Simulations- und Datenframeworks vor. Dazu gehören Isaac Sim 5.0 und Isaac Lab 2.2, die beide auf GitHub verfügbar sind. Isaac Lab enthält neue Testumgebungen für GR00T N-Modelle. Außerdem veröffentlicht Nvidia ein Open-Source-Datenset mit 24.000 hochwertigen Bewegungssequenzen für humanoide Roboter.

Mit Cosmos Reason steht ein neues Weltmodell zur Verfügung, das per "Chain of Thought"-Technik qualitativ hochwertige synthetische Trainingsdaten kuratieren soll. Cosmos Predict 2, das in GR00T-Dreams verwendet wird, soll bald auf Hugging Face erscheinen.

Das bereits im März vorgestellte GR00T-Mimic-Blueprint ergänzt das Setup: Es erzeugt mit wenigen menschlichen Demonstrationen große Mengen synthetischer Bewegungsdaten für Manipulationsaufgaben. Foxconn und Foxlink nutzen es bereits, um ihre Trainingspipelines zu beschleunigen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.