Ilya Sutskever sieht KI-Entwicklung am Wendepunkt und schweigt über seine Lösung

Kurz & Knapp

- Ilya Sutskever, ehemaliger OpenAI-Chefwissenschaftler, erklärt die Ära der Skalierung für beendet. Pre-Training-Daten seien begrenzt, mehr Rechenleistung allein bringe keine Fortschritte mehr. Die KI-Branche müsse zurück zur fundamentalen Forschung.

- Heutige Modelle zeigen "Jaggedness": Sie lösen komplexe Aufgaben, versagen aber bei Basics. Sutskever sieht menschliche Emotionen als Schlüssel für effizientes Lernen – Menschen lernen mit einem Bruchteil der Daten, die KI benötigt.

- Mit seinem Startup SSI will Sutskever eine Superintelligenz entwickeln, die wie ein "begabter 15-Jähriger" erst im praktischen Einsatz lernt. Statt schneller Produkte stehe reine Forschung im Fokus.

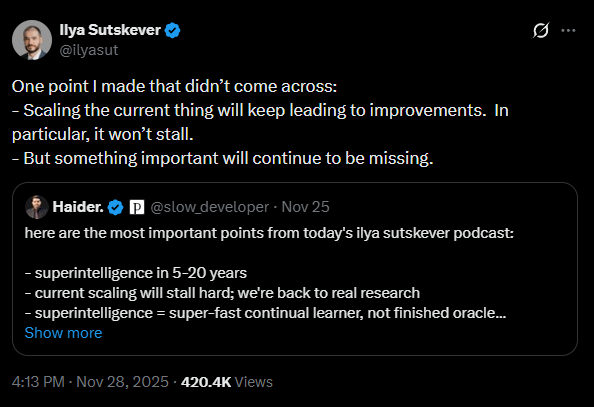

Update vom 28. November 2025:

Auf X relativiert Sutskever seine Aussagen zum Ende der Skalierung. Er stellt klar, dass die aktuelle Skalierungstechnologie weiterhin zu Verbesserungen führen werde und dieser Fortschritt nicht zum Stillstand komme. Dennoch würde dabei „etwas Wichtiges“ fehlen.

Ursprünglicher Artikel vom 26. November 2025:

Der SSI-Gründer und ehemalige OpenAI-Chefwissenschaftler sieht die KI-Entwicklung an einem Wendepunkt. Anstelle immer größerer Modelle sei nun wieder fundamentale Forschung gefragt. Modelle müssten ähnlich wie Menschen effizienter lernen. Ideen, wie das möglich sei, habe er, doch lebe man nun in einer Welt, in der man nicht mehr frei darüber reden könne.

In einem ausführlichen Interview mit Dwarkesh Patel beschreibt Ilya Sutskever, Mitgründer von Safe Superintelligence Inc. (SSI), einen fundamentalen Wandel in der KI-Entwicklung. Während die Jahre 2020 bis 2025 das "Zeitalter der Skalierung" gewesen seien, in dem Fortschritte primär durch mehr Rechenleistung und Daten erzielt wurden, kehre die Branche nun in eine "Ära der Forschung" zurück.

"Skalierung hat die ganze Luft aus dem Raum gesogen", erklärt Sutskever. Da das Rezept – mehr Daten und Rechenleistung in ein neuronales Netz zu geben – so verlässlich funktionierte, hätten alle Unternehmen dasselbe getan. Doch Pre-Training-Daten seien endlich. Zwar werde immer noch skaliert, insbesondere im Bereich Reinforcement Learning (RL), doch die bloße Vergrößerung der Ressourcen garantiere keine qualitativen Sprünge mehr.

Laut Sutskever stehen wir wieder an einem Punkt, der der Zeit vor 2020 ähnelt: Es brauche neue Ideen und Paradigmen, nicht nur größere Cluster.

KI-Modelle leiden unter "Jaggedness"

Ein zentrales Problem aktueller Modelle ist laut Sutskever ihre Uneinheitlichkeit ("Jaggedness"). Modelle würden zwar in schwierigen Benchmarks hervorragend abschneiden, scheiterten aber oft an grundlegenden Aufgaben. Als Beispiel nennt er das "Vibe Coding": Ein Modell erkenne einen Fehler, baue beim Beheben aber einen neuen ein, nur um beim nächsten Korrekturversuch den alten Fehler wiederherzustellen.

Sutskever vermutet, dass das Training mit Bestärkendem Lernen (Reinforcement Learning, RL) die Modelle "zu engstirnig" mache. Im Gegensatz zum Pre-Training, bei dem einfach "alle Daten" verwendet wurden, müsse man beim RL selektieren. Dies führe dazu, dass Forscher die Modelle – oft unabsichtlich – auf bestimmte Benchmarks hin optimieren ("Reward Hacking"), was die Generalisierungsfähigkeit in der realen Welt beeinträchtige.

Menschliche Emotionen als biologische "Value Function"

Um die nächste Stufe der Intelligenz zu erreichen, müssten KI-Systeme lernen, so effizient zu generalisieren wie Menschen. Ein Teenager lerne das Autofahren in nur etwa 10 Stunden, ein Bruchteil der Datenmenge, die eine KI benötigt.

Sutskever theoretisiert, dass menschliche Emotionen hierbei eine entscheidende Rolle spielen, indem sie als eine Art robuste "Value Function" (Bewertungsfunktion) dienen. Diese biologisch verankerten Bewertungen würden Menschen helfen, Entscheidungen zu treffen und aus Erfahrungen zu lernen, lange bevor ein externes Ergebnis (wie im klassischen RL) vorliegt.

"Vielleicht deutet das darauf hin, dass die Bewertungsfunktion des Menschen durch Emotionen auf eine wichtige Weise moduliert wird, die durch die Evolution fest verdrahtet ist", so Sutskever.

AGI ist das falsche Ziel – Superintelligenz entsteht erst im Job

Sutskever stellt zudem den etablierten Begriff der AGI grundsätzlich infrage. Durch den Erfolg des Pre-Trainings sei die falsche Erwartung entstanden, eine KI müsse sofort alles können ("General AI"). Dies schieße jedoch über das Ziel hinaus: "Ein Mensch ist keine AGI", so Sutskever. Menschen fehle es an enormem Vorwissen, dafür verließen sie sich auf kontinuierliches Lernen.

Seine Vision einer Superintelligenz gleicht daher eher einem extrem begabten Studenten als einer allwissenden Datenbank. "Ich produziere einen superintelligenten 15-Jährigen, der sehr eifrig ist", erklärt Sutskever. Dieses System wisse anfangs noch wenig, sei aber fähig, jeden Beruf zu erlernen. Die eigentliche Kompetenz entstehe demnach erst nach der Veröffentlichung: Das Modell müsse durch eine Phase von "Trial-and-Error" im echten Einsatz gehen, um seine Fähigkeiten voll zu entfalten, anstatt als fertiges Produkt aus dem Trainings-Cluster zu kommen.

Sutskever will nicht frei über seine Ideen sprechen

Auf die Frage, wie man das Training konzeptionell ändern müsse, um diese menschliche Lerneffizienz zu erreichen, gibt sich Sutskever jedoch verschlossen. Er habe dazu zwar "eine Menge Meinungen", doch die Zeiten des offenen Austauschs seien vorbei.

"Unglücklicherweise leben wir in einer Welt, in der nicht alle Machine-Learning-Ideen frei diskutiert werden, und dies ist eine davon", erklärt Sutskever.

Die bloße Existenz des Menschen sei für ihn der Beweis, dass es einen Weg geben müsse. Er schränkt jedoch ein, dass es ein potenzielles Hindernis geben könnte: Es bestehe die Möglichkeit, dass menschliche Neuronen "mehr Rechenleistung erbringen, als wir denken". Falls dies eine wichtige Rolle spiele, könnte die Umsetzung schwieriger werden.

Ungeachtet dessen deutet Sutskever an, dass dies auf die Existenz eines bestimmten "Machine-Learning-Prinzips" hinweise, zu dem er Theorien habe. Doch "die Umstände machen es schwer, dies im Detail zu diskutieren."

SSI will sich dem kommerziellen Wettlauf entziehen

Mit seinem neuen Unternehmen SSI verfolgt Sutskever einen Ansatz, der sich bewusst vom aktuellen Marktgeschehen abgrenzen soll. Das Unternehmen, das 3 Milliarden US-Dollar eingesammelt hat, plant keinen schnellen Produkt-Release.

Sutskever argumentiert, dass SSI zwar über weniger Rechenleistung verfügt als die großen Tech-Giganten, diese aber effizienter für reine Forschung nutzen könne, da keine Ressourcen für den Betrieb kommerzieller Produkte oder riesige Inference-Cluster gebunden seien.

Der Plan sei ein "Straight Shot" zur Superintelligenz. Man wolle sich nicht in den "Rat Race" begeben, Produkte auf den Markt zu werfen, sondern im Verborgenen forschen, bis das System sicher und ausgereift sei. Allerdings räumt er ein, dass eine schrittweise Veröffentlichung notwendig sein könnte, um der Gesellschaft die Macht der KI zu demonstrieren - und so Regulierungsprozesse anzustoßen.

Ausrichtung auf empfindungsfähiges Leben

In Bezug auf die Sicherheit (Alignment) einer zukünftigen Superintelligenz schlägt Sutskever ein neues Ziel vor: Die KI solle so ausgerichtet werden, dass sie sich um "sentient life" (empfindungsfähiges Leben) sorgt. Da die KI selbst empfindungsfähig sein werde, sei es naheliegender, eine Empathie für andere fühlende Wesen zu verankern, als abstrakte menschliche Werte zu programmieren.

Sutskever prognostiziert zudem, dass sich die Sicherheitsstrategien der großen KI-Labore annähern werden, sobald die KI-Systeme spürbar mächtiger werden. Die derzeitige Konkurrenz werde einer pragmatischen Zusammenarbeit weichen, da die Risiken greifbarer würden. Ein erstes Anzeichen hierfür sei die beginnende Kooperation zwischen Konkurrenten wie OpenAI und Anthropic.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren