Im Auge des Betrachters: KI rekonstruiert 3D-Szenen aus Augenreflexionen

Im Projekt "Seeing the World through Your Eyes" (Die Welt durch deine Augen sehen) zeigen Forscher der University of Maryland, College Park, dass die Reflexionen des menschlichen Auges zur Rekonstruktion von 3D-Szenen genutzt werden können. Dies sei eine bisher "unterschätzte Informationsquelle darüber, wie die Welt um uns herum aussieht".

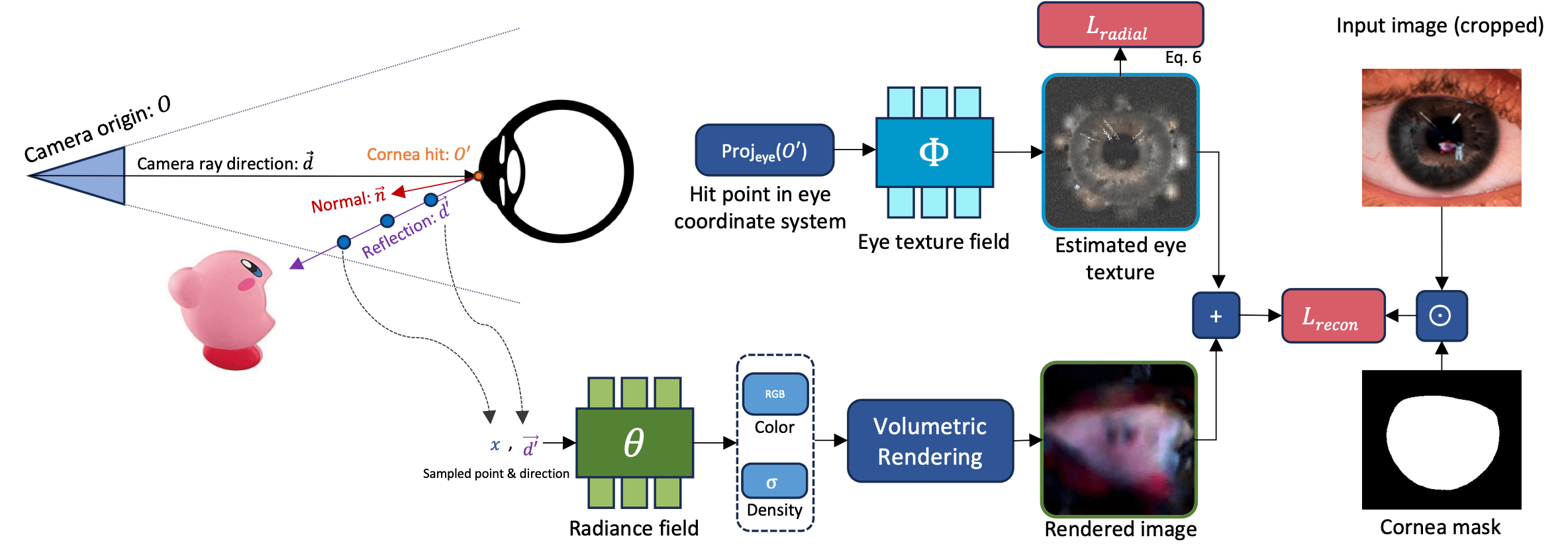

Die Arbeit nutzt eine NeRF-basierte Methode, um aus einer Reflexion im Auge eine 3D-Szene zu rekonstruieren. Das klinge einfach, sei aber in Wirklichkeit ein komplizierter Prozess, der durch mehrere Faktoren erschwert werde, darunter die genaue Bestimmung der Blickrichtung und die Unterscheidung der Reflexionen von den Mustern der Iris, so die Forscher.

Die Hornhaut als Basis für die Berechnung der Außenwelt

Um die Außenwelt zu berechnen, nutzt das Team die Geometrie der Hornhaut, die bei gesunden Erwachsenen ziemlich einheitlich ist. Anhand der Größe der Hornhaut in einem Bild können sie die Position und Ausrichtung des Auges abschätzen.

Ein wichtiger Aspekt ist die Optimierung der Erkennung der Hornhautposition, mit der die anfängliche Positionsschätzung für jedes Bild verfeinert wird. Diese Technik hat sich als entscheidend für die Robustheit des Verfahrens erwiesen.

Um die Reflexion der Außenwelt vom Irismuster zu trennen, verwendet das Team ein modifiziertes Trainings-Framework von Nerfstudio. Sie ließen NeRF sowohl die reflektierte 3D-Szene als auch das Irismuster lernen und trainierten das System gleichzeitig, die beiden Elemente voneinander zu trennen.

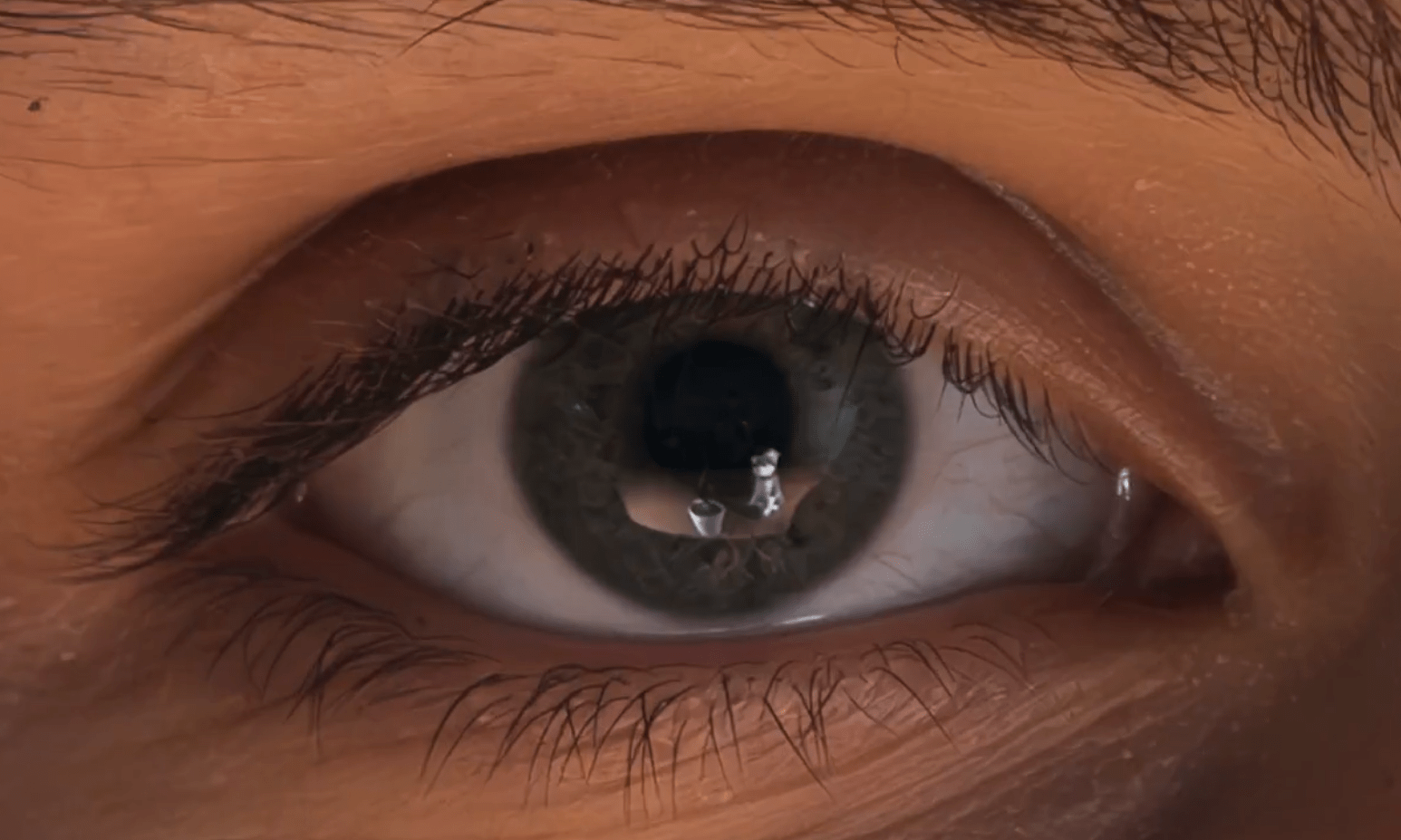

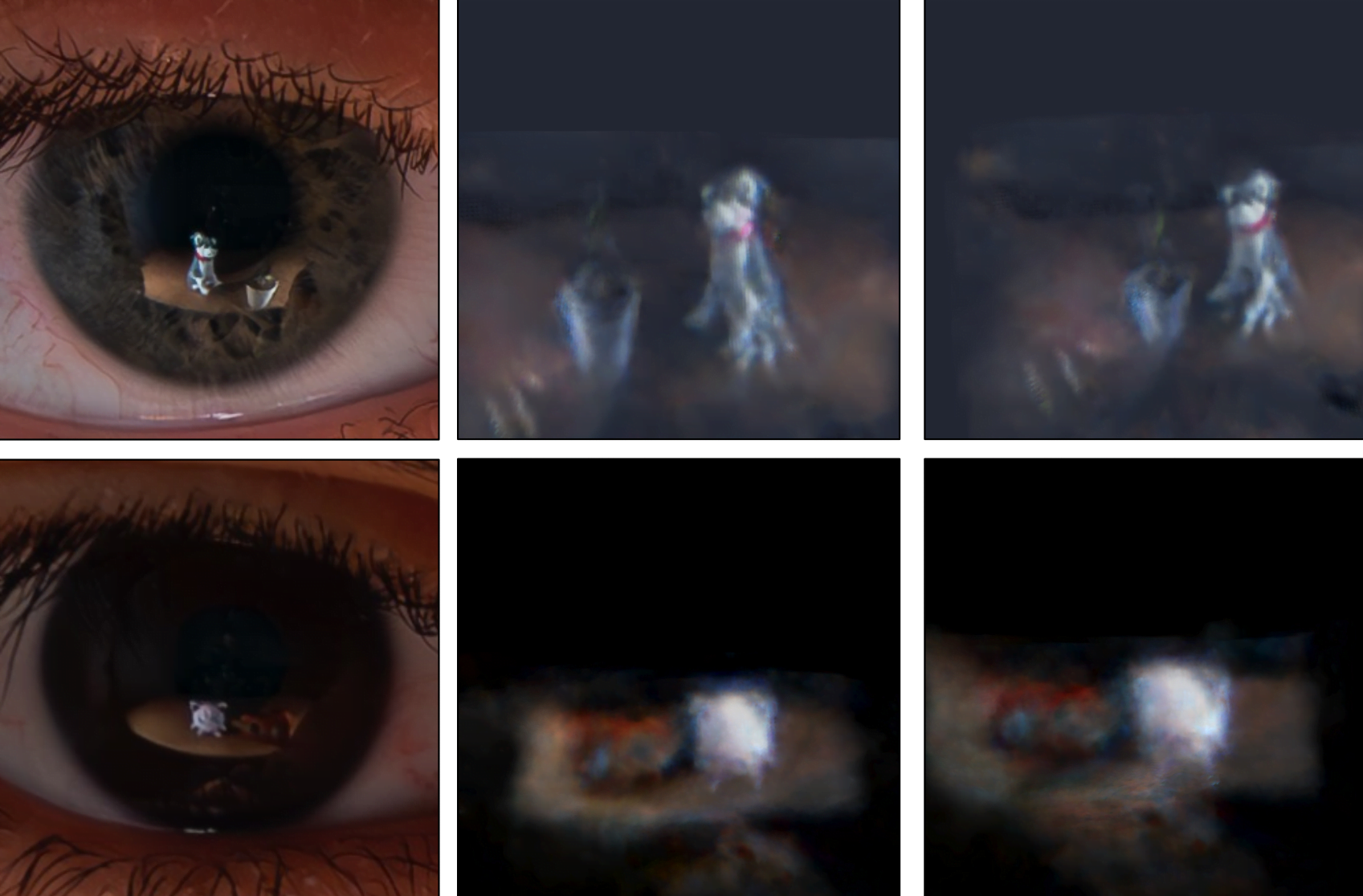

Rekonstruktion einer 3D-Szene aus der Spiegelung im Auge eines Porträtfotos. | Video: Alzayer, Zhang et al.

Für die Erkennung der Iris wurde dem System die allgemeine radialsymmetrische Form als Vorgabe gegeben und die Annahme, dass sich die Reflexion aus verschiedenen Perspektiven ändert, die Textur der Iris aber gleich bleibt.

Rekonstruktion einer 3D-Szene aus der Spiegelung im Auge eines Porträtfotos. | Video: Alzayer, Zhang et al.

Nur eine Kamera für ein 3D-Nerf

Während typische NeRF-Rekonstruktionen mehrere Kameraperspektiven auf das zu rekonstruierende Objekt erfordern, bewegten die Forscher die Person einfach durch das Sichtfeld der Kamera. Die Reflexionen im Auge, die sich bereits bei minimalen Bewegungen verändern, lieferten die für die 3D-Szenenrekonstruktion notwendigen unterschiedlichen Perspektiven, obwohl die Person selbst nur von einer Kamera gesehen wurde.

Zur Validierung ihrer Methode verwendete das Team synthetische Augenbilder, die mit Blender gerendert wurden, und reale Fotos einer Person, die sich im Sichtfeld der Kamera bewegte. Trotz Herausforderungen wie Ungenauigkeiten bei der Lokalisierung der Hornhaut und der Schätzung ihrer Geometrie sowie der inhärent niedrigen Auflösung der Bilder erwies sich ihre Methode als vielversprechend. Bei Tests mit synthetischen Augenmodellen konnte das Team vollständige Szenenrekonstruktionen nur anhand von Augenreflexionen durchführen.

Sehr detaillierte Rekonstruktion einer 3D-Szene mit Hilfe eines synthetischen Augenmodells unter optimalen Bedingungen. | Video: Alzayer, Zhang et al.

Allerdings wurden die Tests nur unter Laborbedingungen durchgeführt, in der Realität spielten viele andere Faktoren eine Rolle, und die in der Arbeit gemachten Annahmen, z.B. über die Beschaffenheit der Iris, waren möglicherweise zu einfach. Hellere Iristexturen oder Situationen mit starker Augenrotation könnten zusätzliche Herausforderungen darstellen.

Das Team hofft, dass die Arbeit weitere Forschung anregt, wie unerwartete, zufällige visuelle Signale genutzt werden können, um Informationen über die umgebende Welt zu enthüllen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.