ByteDance: InfiniteYou erzeugt endlos konsistente Portraitvarianten

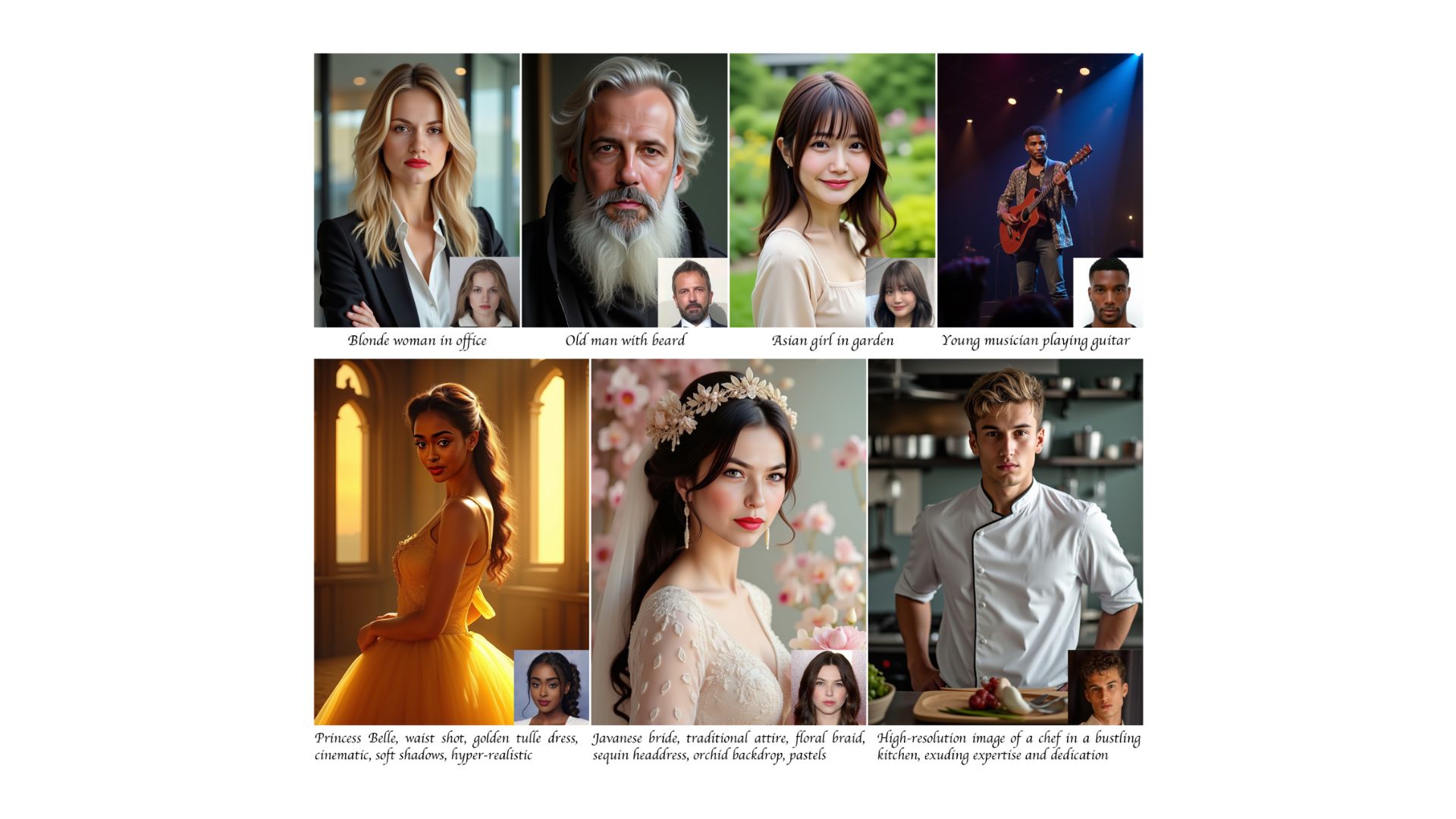

Der TikTok-Konzern ByteDance präsentiert mit InfiniteYou ein KI-System, das bestehende Schwächen bei der Generierung von Porträtfotos adressieren soll.

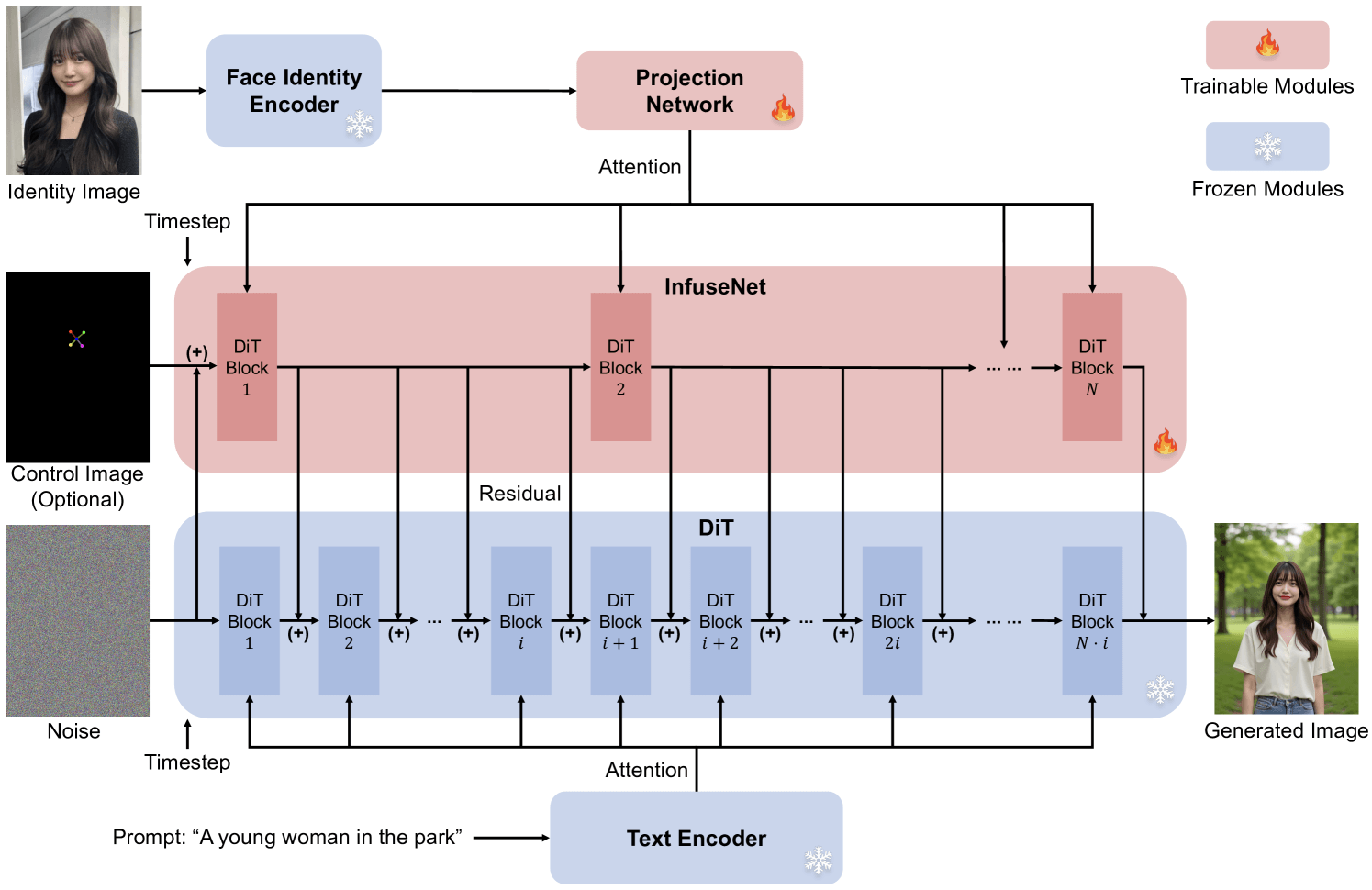

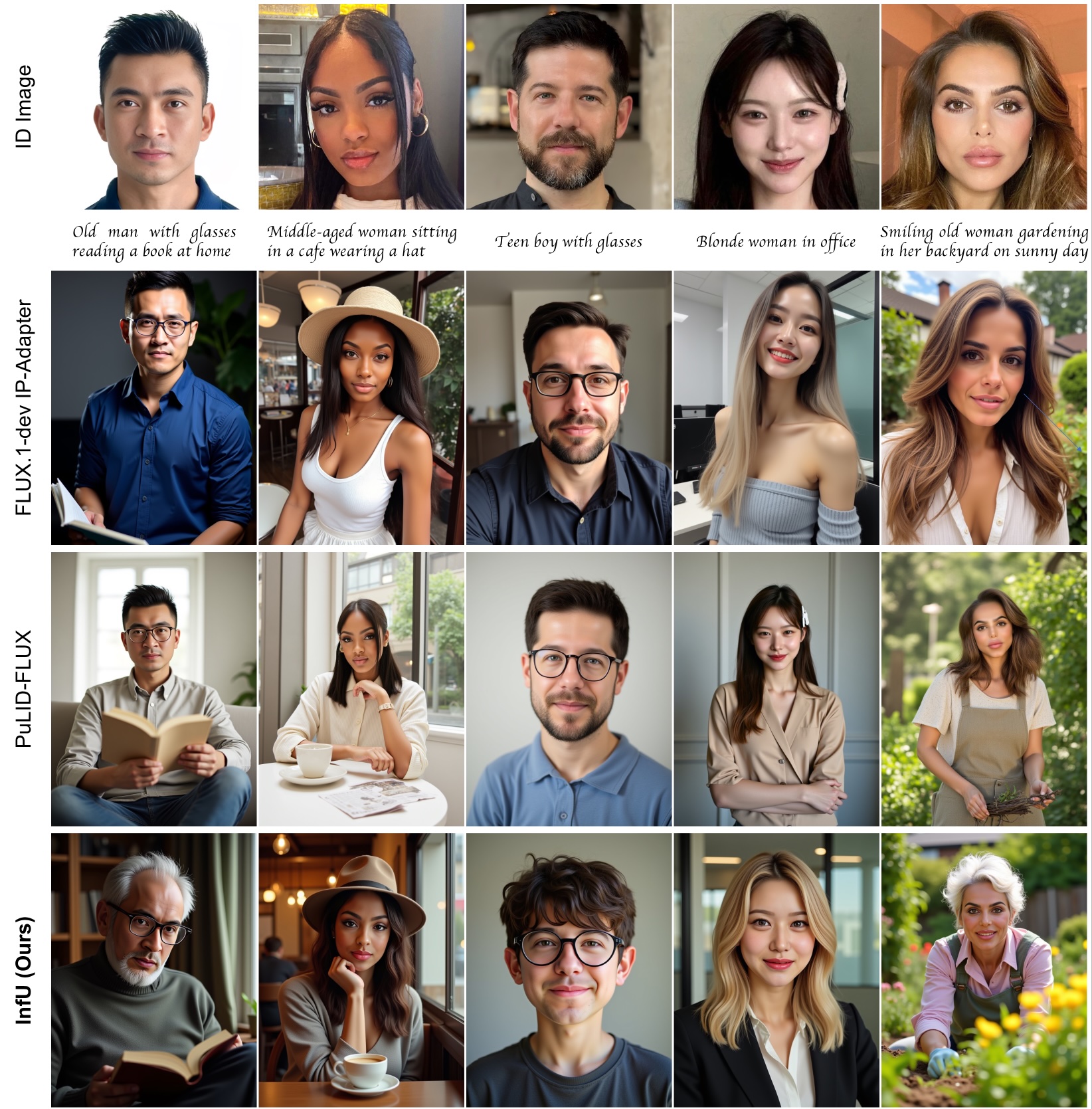

Das System nutzt einen anderen technischen Ansatz als bisherige Lösungen: Während Systeme wie PuLID-FLUX direkt die Aufmerksamkeitsmechanismen des KI-Modells manipulieren, um Gesichtsmerkmale zu verarbeiten, setzt ByteDance auf eine separate Komponente namens InfuseNet. Diese analysiert das Eingabebild und extrahiert daraus die charakteristischen Merkmale des Gesichts.

Diese Merkmale werden dann nicht direkt in das Hauptmodell – ByteDance setzt auf Flux.1-dev – eingespeist, sondern als zusätzliche Informationsebene parallel verarbeitet. So könnten die Gesichtsmerkmale die Bildgenerierung beeinflussen, ohne dabei die grundlegenden Fähigkeiten des KI-Modells zu beeinträchtigen.

Nach Angaben der Entwickler:innen führt dieser vorsichtigere Umgang mit dem KI-Modell zu deutlich besseren Ergebnissen: Die generierten Bilder behielten nicht nur die Ähnlichkeit zur Originalperson bei, sondern setzten auch die Textanweisungen präziser um. Zudem vermeide das System häufige Probleme wie das simple Kopieren von Gesichtern oder eine verschlechterte Bildqualität, die bei bisherigen Ansätzen oft aufträten.

Training mit echten und synthetischen Daten

ByteDance trainiert das System zunächst mit echten Einzelporträts und anschließend mit künstlich erzeugten Bildern. Diese werden vom System selbst unter Verwendung zusätzlicher Optimierungsmodule erstellt.

In einer Nutzerstudie mit 16 Teilnehmenden bevorzugten 72,8 Prozent die Ergebnisse von InfiniteYou gegenüber dem Vergleichssystem PuLID-FLUX mit 27,2 Prozent. Die Studie bewertete dabei die Ähnlichkeit zum Originalgesicht, die Umsetzung der Textanweisungen, die Bildqualität und ästhetische Aspekte.

Kombination mit anderen KI-Werkzeugen möglich

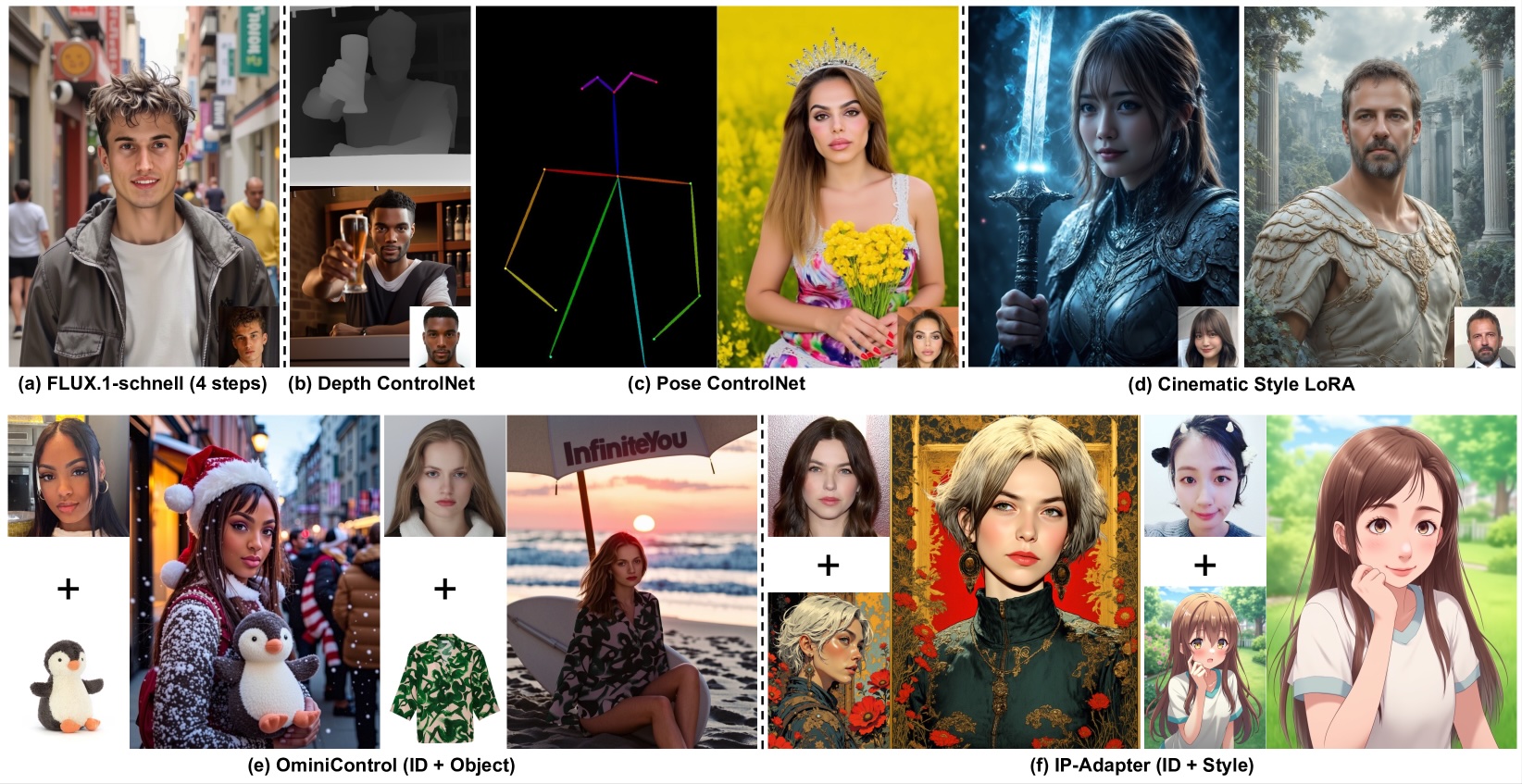

Das System lässt sich mit verschiedenen KI-Werkzeugen wie ControlNet oder LoRA kombinieren. Es kann Bilder in nur vier Verarbeitungsschritten erzeugen und ermögliche, sowohl Personen als auch Objekte im Bild anzupassen.

Die Entwickler:innen weisen darauf hin, dass es bei der Ähnlichkeit zum Originalgesicht und der Bildqualität trotz der Fortschritte noch Verbesserungsbedarf gibt. Auch die mögliche missbräuchliche Nutzung zur Erstellung von gefälschten Fotos sehen sie als Problem. Deshalb appelliert ByteDance daran, Systeme zu entwickeln, die KI-generierte Bilder erkennen können.

Der Code für InfiniteYou ist jetzt Open Source auf GitHub verfügbar. Die Modellgewichte können von Hugging Face heruntergeladen werden. Eine experimentelle Demo soll es auch geben, ist zum Zeitpunkt aber noch nicht verfügbar.

ByteDance ist unter anderem Mitglied der Content Authenticity Initiative, einem Branchenverbund von Kameraherstellern und Medienanbietern, die ihre Werke durch die C2PA-Metadaten als echtes Foto oder KI-generiert kennzeichnen. Ob und wie dieses Verfahren bei InfiniteYou zum Einsatz kommt, verrät ByteDance im Paper nicht.

Bereits seit Anfang des Jahres hat ByteDance diverse weitere Forschungsprojekte in ähnlicher Richtung präsentiert. OmniHuman-1 etwa erstellt aus Bild- und Ton-Eingaben fotorealistische Animationen. Die Modelle der Goku-Reihe können indes überzeugende Videoclips generieren, die verblüffend menschlich anmutende KI-Avatare bei der Interaktion mit Produkten zeigen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.