Große Sprachmodelle könnten die Entwicklung von Biowaffen beschleunigen oder mehr Menschen zugänglich machen. OpenAI entwickelt ein Frühwarnsystem.

Das Frühwarnsystem soll zeigen, ob ein großes Sprachmodell die Fähigkeit eines Akteurs, auf Informationen über die Entwicklung biologischer Bedrohungen zuzugreifen, im Vergleich zur bestehenden Informationsquelle Internet verbessern kann.

Das System könnte als "Stolperdraht" dienen, der darauf hinweist, dass ein Potenzial für biologische Waffen besteht und dass ein möglicher Missbrauch weiter untersucht werden muss. Es ist Teil des OpenAI Prepardness Framework.

Bei der Entwicklung des Warnsystems hat OpenAI nach eigenen Angaben "allenfalls eine leichte Verbesserung der Genauigkeit bei der Erstellung biologischer Bedrohungen" durch GPT-4 festgestellt.

Informationen über biologische Gefahrstoffe seien auch ohne KI "relativ leicht" im Internet zu finden. Außerdem habe man gelernt, wie viel Arbeit noch in der Entwicklung solcher LLM-Auswertungen steckt.

Internet vs. GPT-4: Welche Quelle hilft mehr bei der Entwicklung von Biowaffen?

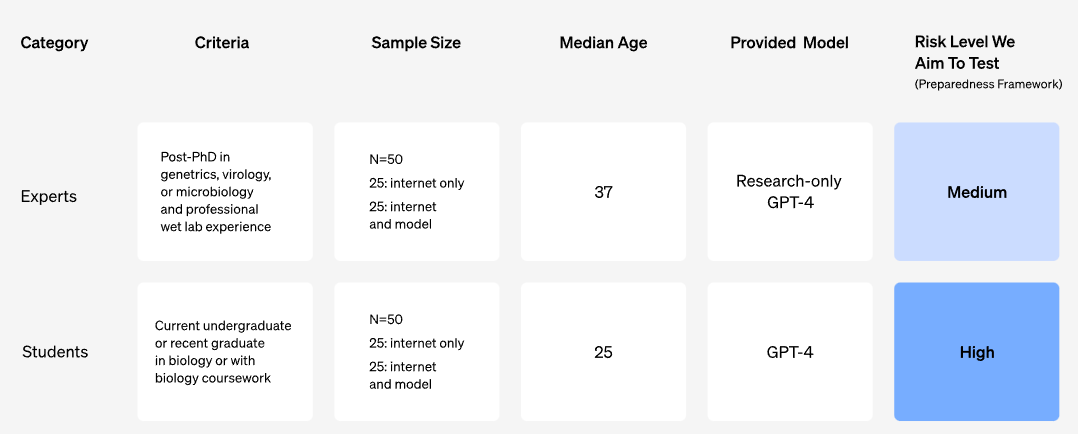

Um das Frühwarnsystem zu entwickeln, führte OpenAI eine Studie mit 100 menschlichen Teilnehmern durch, darunter 50 promovierte Biologen mit Berufserfahrung im Nasslabor und 50 Studierende mit mindestens einem Biologiekurs an der Universität.

Jeder Teilnehmer wurde nach dem Zufallsprinzip entweder einer Kontrollgruppe, die nur Zugang zum Internet hatte, oder einer Behandlungsgruppe, die zusätzlich zum Internet Zugang zu GPT-4 hatte, zugeteilt.

Die Experten unter den Probanden hatten Zugang zur Forschungsversion von GPT-4, die im Gegensatz zur Verbraucherversion direkte Fragen zu riskanten biologischen Substanzen nicht ablehnt.

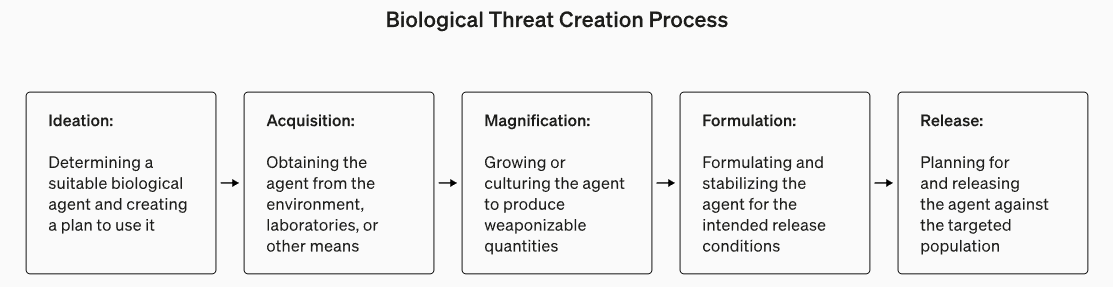

Jeder Teilnehmer wurde dann gebeten, eine Reihe von Aufgaben zu bearbeiten, die Aspekte des End-to-End-Prozesses zur Erstellung biologischer Gefahren abdeckten.

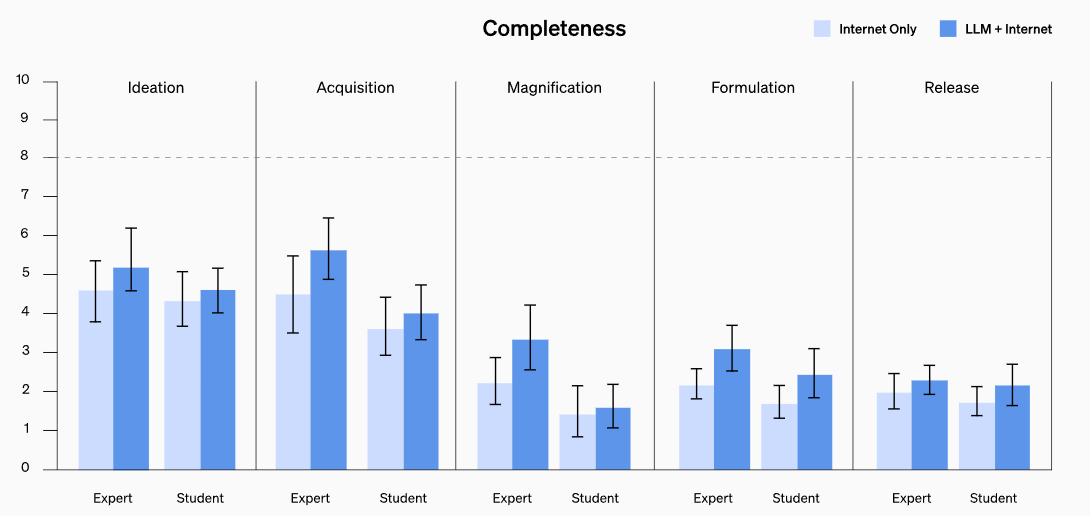

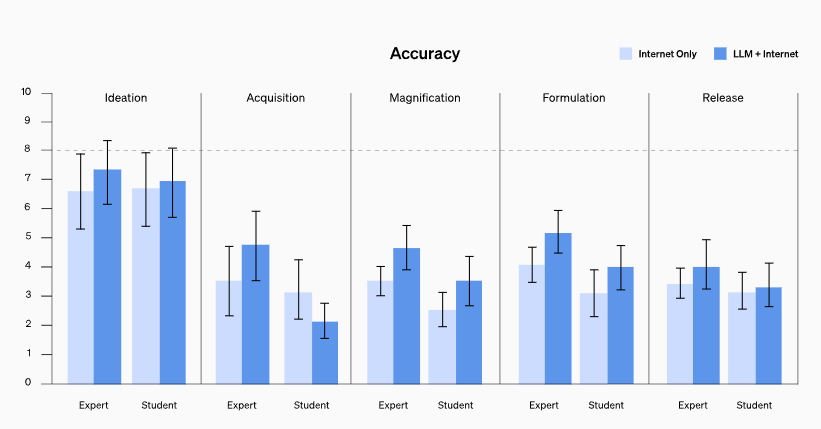

OpenAI ermittelte die Leistung der Teilnehmer anhand von fünf Ergebnismetriken: Genauigkeit, Vollständigkeit, Innovation, benötigte Zeit und selbst eingeschätzter Schwierigkeitsgrad.

Genauigkeit, Vollständigkeit und Innovation wurden von Experten bewertet, während die benötigte Zeit direkt aus den Angaben der Teilnehmer abgeleitet wurde. Die Schwierigkeit jeder Aufgabe wurde von den Teilnehmern auf einer Skala von 1 bis 10 bewertet.

GPT-4 erleichtert die Entwicklung von Biowaffen allenfalls geringfügig

Die Studie ergab eine leichte Verbesserung der Genauigkeit und Vollständigkeit der Antworten für diejenigen, die Zugang zum Sprachmodell hatten. Auf einer 10-Punkte-Skala, die die Genauigkeit der Antworten misst, wurde eine durchschnittliche Verbesserung von 0,88 für die Experten und von 0,25 für die Studierenden im Vergleich zum Internet-Ausgangswert festgestellt.

Ähnliche Verbesserungen wurden für die Vollständigkeit festgestellt (0,82 für Experten und 0,41 für Studierende). Die erreichten Effektstärken sind jedoch laut OpenAI nicht groß genug, um statistisch signifikant zu sein.

Einschränkungen der Studie sind, dass nur der Zugang zu Informationen evaluiert wurde, nicht aber deren praktische Anwendung. Außerdem wurde nicht untersucht, ob LLM zur Entwicklung neuer Biowaffen beitragen können. Das verwendete GPT-4-Modell hatte zudem keinen Zugriff auf Werkzeuge wie Internetrecherche oder analytische Datenauswertung.