KI-Methode REPA beschleunigt das Training von Bildgenerierungsmodellen um den Faktor 17,5

Forscher haben eine Technik namens REPA entwickelt, die das Training von KI-Bildgenerierungsmodellen erheblich beschleunigt und verbessert. Die Methode nutzt Erkenntnisse aus der selbstüberwachten Bildverarbeitung.

Wissenschaftler haben eine neue Methode vorgestellt, die die Entwicklung von KI-Bildgenerierungsmodellen stark beschleunigt. Die als REPA (REPresentation Alignment) bezeichnete Technik verspricht, die Trainingszeit dieser Modelle drastisch zu verkürzen und gleichzeitig die Qualität der erzeugten Bilder zu verbessern.

Diffusionsmodelle generieren normalerweise Rauschbilder, die schrittweise in saubere Bilder umgewandelt werden. Dieser Prozess lernt auch interne Repräsentationen. Allerdings sind diese Repräsentationen oft nicht so gut wie die von Modellen wie DINOv2, die speziell darauf ausgelegt sind, hochwertige visuelle Repräsentationen für die Bildverarbeitung zu lernen.

"Wir argumentieren, dass eines der Hauptprobleme beim Training großer Diffusionsmodelle darin besteht, effektiv bedeutungsvolle Repräsentationen zu lernen", erklären die Forscher in ihrer Studie. "Das Training kann erleichtert werden, indem hochwertige externe visuelle Repräsentationen einbezogen werden, anstatt sich ausschließlich darauf zu verlassen, dass die Diffusionsmodelle diese unabhängig lernen."

REPA fügt daher eine Regularisierung hinzu, die die während des Denoising-Prozesses erzeugten Repräsentationen explizit mit denen von DINOv2 vergleicht und eine Projektion der verborgenen Zustände des Diffusionsmodells auf die Repräsentationen von DINOv2 durchführt. Dadurch wird sichergestellt, dass das Diffusionsmodell lernt, auch aus verrauschten Trainingsdaten semantisch sinnvolle Merkmale zu extrahieren. Die interne Repräsentation nähert sich dann deutlich der von DINOv2 an, auch ohne das sonst notwendige aufwendige Training mit sehr vielen Bildern.

Die Wissenschaftler testeten REPA mit verschiedenen Diffusionsmodell-Architekturen, darunter die populären "Diffusion Transformers" (DiTs) und "Scalable Interpolant Transformers" (SiTs). Die Ergebnisse sind beeindruckend: Bei einigen Modellen konnte die Trainingszeit um das 17,5-fache verkürzt werden, ohne dass die Qualität der generierten Bilder darunter litt.

REPA erreicht Spitzenleistung in Rekordzeit

Ein konkretes Beispiel verdeutlicht das Potenzial von REPA: Ein mit der neuen Methode trainiertes SiT-XL-Modell erreichte nach nur 400.000 Trainingsschritten eine Leistung, für die das herkömmliche Modell 7 Millionen Schritte benötigte. Dies könnte die Entwicklung neuer Bildgenerierungsmodelle erheblich beschleunigen und den Energieverbrauch beim Training reduzieren.

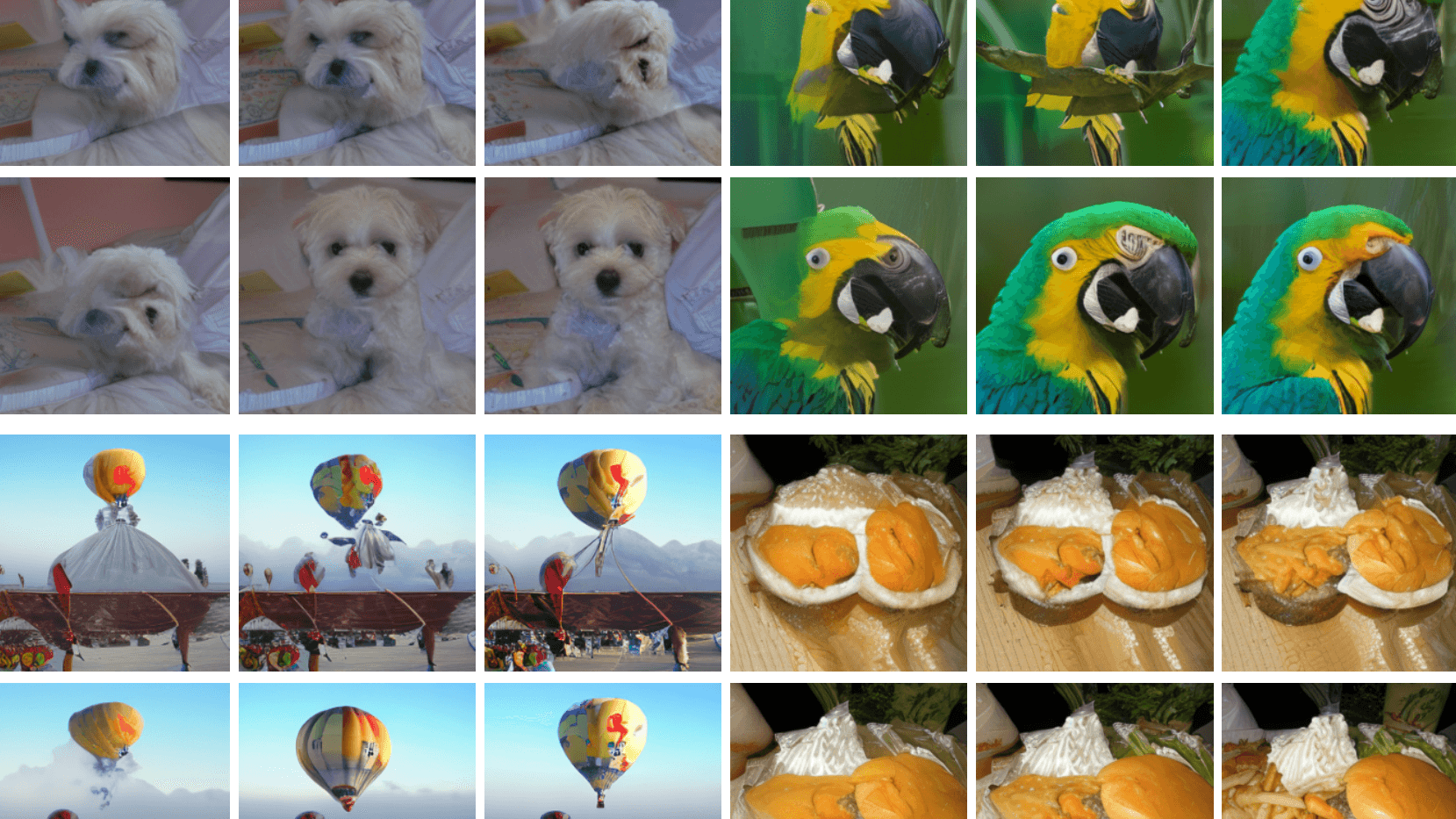

Die Forscher betonen, dass ihre Methode nicht nur die Trainingseffizienz verbessert, sondern auch die Qualität der erzeugten Bilder steigert. In standardisierten Tests zur Bewertung von KI-generierten Bildern, wie dem Frechet Inception Distance (FID) Score, schnitten die mit REPA trainierten Modelle besser ab als herkömmliche Diffusionsmodelle.

"Unsere einfache Strategie führt zu signifikanten Verbesserungen sowohl bei der Trainingseffizienz als auch bei der Generierungsqualität", fassen die Wissenschaftler zusammen. Sie sehen in ihrer Arbeit einen wichtigen Schritt zur Entwicklung effizienterer und leistungsfähigerer KI-Systeme für die Bildgenerierung.

Mehr Infos und den Code gibt es auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.