Ist Mensch drin, wo Mensch draufsteht? Eine Studie kommt zu einem anderen Ergebnis. Fast die Hälfte der vermeintlich menschlichen Textzusammenfassungen stammten von einer KI.

Eine aktuelle Studie der École Polytechnique Fédérale de Lausanne (EPFL) hat die Rolle von KI-Tools wie ChatGPT, die auf großen Sprachmodellen basieren, bei scheinbar von Menschen ausgeführten Arbeiten untersucht.

Die Studie konzentrierte sich dabei auf Amazons Crowdsourcing-Plattform Mechanical Turk (MTurk), auf der Nutzer:innen Aufgaben wie Textzusammenfassungen anbieten und ausführen können.

Fast die Hälfte der Zusammenfassungen von KI

Die Forscher fanden heraus, dass zwischen 33 und 46 Prozent der im Rahmen der Studie 46 eingereichten Zusammenfassungen mithilfe von KI-Sprachmodellen erstellt wurden. Aufgabe der Crowdworker:innen war es, insgesamt medizinische Texte mit rund 400 Wörtern zusammenzufassen. Die Anweisungen der Forschenden lesen sich tatsächlich wie ein Prompt für eine Text-KI:

Sie erhalten einen kurzen Text (ca. 400 Wörter) mit Informationen zum Thema Medizin. Ihre Aufgabe ist es:

- Lesen Sie den Text aufmerksam.

- Schreiben Sie eine Zusammenfassung des Textes.

- Ihre Zusammenfassung sollte:

- die wichtigsten Informationen des Textes wiedergeben, so als ob Sie versuchen würden, eine andere Person über das zu informieren

über das, was Sie gerade gelesen haben.- mindestens 100 Wörter enthalten.

Wir erwarten qualitativ hochwertige Zusammenfassungen und werden einige von ihnen manuell überprüfen.

Die Ergebnisse der Studie werfen ernsthafte Fragen über die Authentizität menschlicher Daten auf. Die Forscher:innen verwendeten eine Kombination aus Tastatureingabe-Erkennung und synthetischer Textklassifikation, um die Verwendung von KI-Sprachmodellen zu erkennen.

Eigenes Erkennungsmodell mit hoher Genauigkeit trainiert

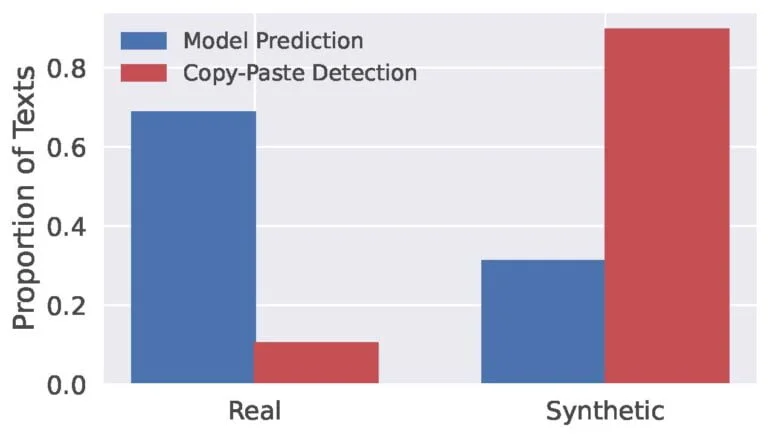

KI-Textdetektoren wie GPTZero lieferten keine zuverlässigen Ergebnisse. Von zehn KI-generierten Zusammenfassungen erkannte GPTZero nur sechs als solche. Stattdessen trainierten die Forschenden mithilfe von menschlich verfassten und KI-generierten Zusammenfassungen ein eigenes Modell. Dieses erreichte nach eigenen Angaben eine Genauigkeit von bis zu 99 Prozent bei der korrekten Erkennung von KI-Texten.

"Diese hohen Werte deuten darauf hin, dass es - zumindest für die vorliegende Aufgabe - einen identifizierbaren ChatGPT-Fingerabdruck in abstrakten Zusammenfassungsaufgaben gibt, der es ermöglicht, universelle Merkmale zu lernen, um zwischen echten und synthetischen Texten zu unterscheiden", heißt es im Paper.

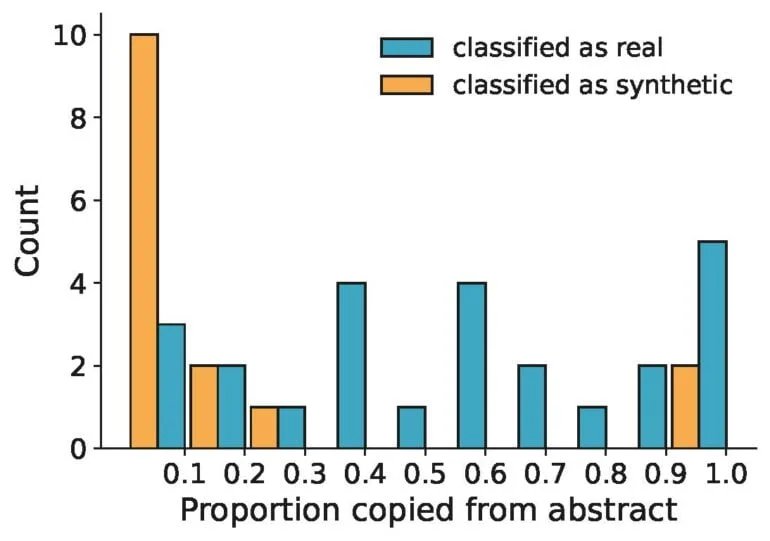

Die von der KI generierten Texte wiesen oft wenig Ähnlichkeit mit den ursprünglichen Abstracts auf, was darauf hindeutet, dass die KI-Modelle neue Texte generierten, anstatt Teile der ursprünglichen Abstracts zu kopieren und einzufügen.

Wie viel ist menschliche Arbeit noch wert?

Laut den Schweizer Forscher:innen haben diese Ergebnisse weitreichende Implikationen. Sie unterstreichen den zunehmenden Trend, dass die menschliche Beteiligung an der Texterstellung abnimmt und durch KI ersetzt wird. Dies könnte die Qualität und Vielfalt der auf Crowdsourcing-Plattformen verfügbaren Daten negativ beeinträchtigen, denn menschliche Daten gelten als Goldstandard.

"Wir glauben nicht, dass dies das Ende von Crowdwork bedeutet, aber es könnte zu einer radikalen Veränderung des Mehrwerts führen, den Crowdworker:innen liefern", so die Forschenden. Stattdessen könnten Crowdworker:innen als wichtiger menschlicher Filter dienen, um zu erkennen, wann diese Modelle erfolgreich sind und wann sie versagen. Auch wenn KI menschliche Arbeit teilweise zu ersetzen scheint, bleibt sie ein wichtiger Bestandteil des Trainings von Sprachmodellen.

Framework für verlässliche KI-Texterkennung

Neben den Erkenntnissen über die Verbreitung von KI für diese Aufgaben haben die Forschenden ein offenbar robustes Framework entwickelt, um KI-Texte in speziellen Anwendungsfällen zuverlässig zu erkennen. Allerdings merken sie auch an, dass die (unangekündigte) Überwachung von Tastatureingaben bei dieser Methode ethisch nicht ganz unkritisch und daher in größerem Umfang eher nicht anwendbar wäre.

Außerdem könnte auch die Verwendung von KI durch Crowdworker:innen an sich datenschutzrechtliche Fragen aufwerfen. So müssten etwa bei der Verwendung von ChatGPT die Nutzer:innen die Verwendung des Inputs für weiteres Trainingsmaterial explizit untersagen, denn OpenAIs Richtlinien untersagen die Nutzung von Modellausgaben für das Training von Konkurrenzprodukten. Wird KI von den Crowdworker:innen ohne Wissen der Auftraggeber:innen eingesetzt, könnte es also rechtliche Konsequenzen haben.