Kimi-VL: Sparsames Open-Source-Modell mit guter Bildverarbeitung

Das Open-Source-Modell Kimi-VL vom chinesischen Start-up Moonshot AI verarbeitet Bilder, Texte und Videos effizienter als viele größere Konkurrenten. Besonders gut schlägt es sich bei langen Dokumenten, komplexen Aufgaben und Bedienoberflächen.

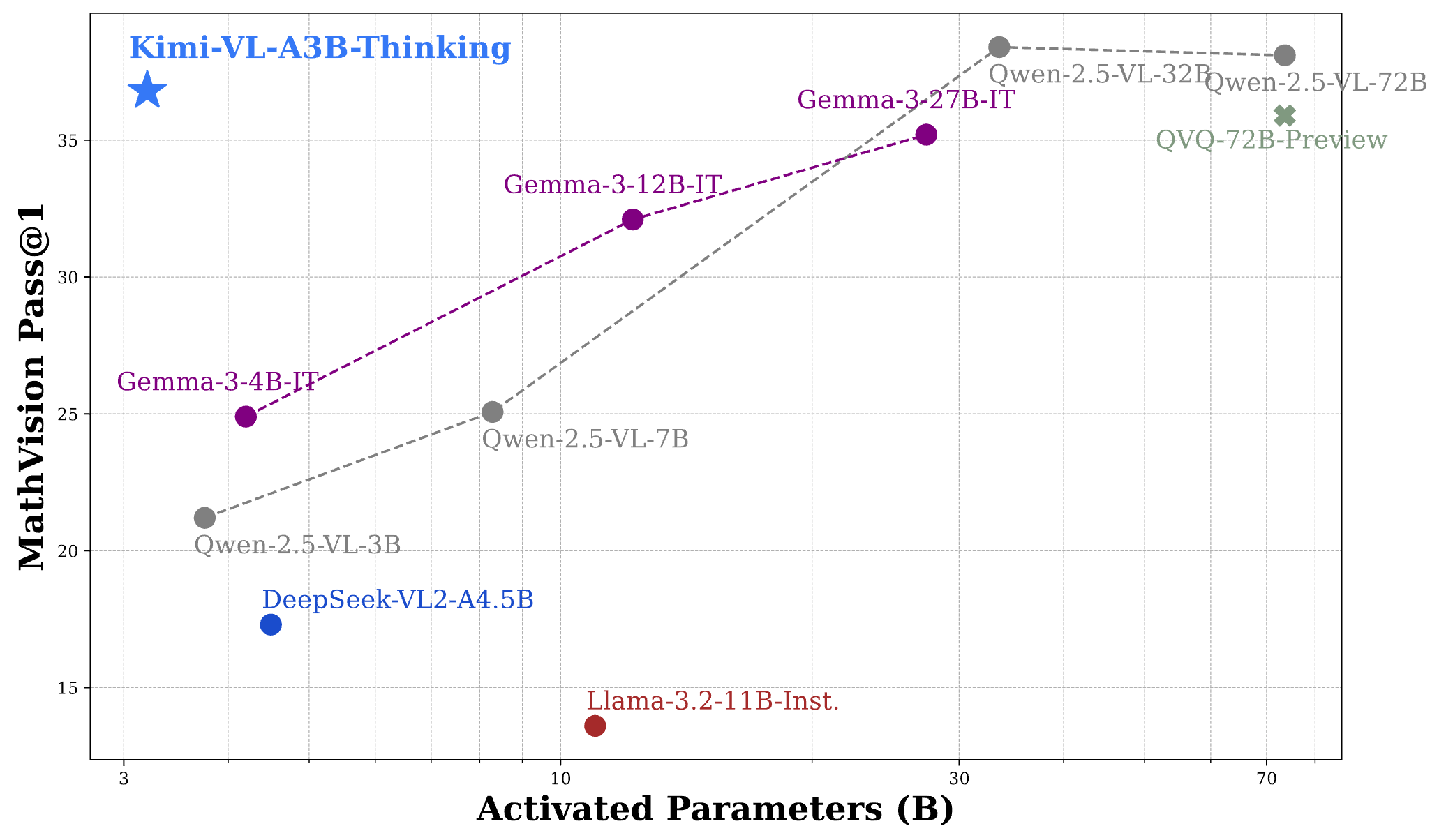

Möglich wird das durch eine sogenannte Mixture-of-Experts-Architektur, bei der jeweils nur ein Teil des Modells aktiv ist. Trotz seiner vergleichsweise kleinen aktiven Sprachkomponente mit 2,8 Milliarden Parametern erzielt Kimi-VL in zahlreichen Tests Ergebnisse, die sich mit deutlich größeren Modellen messen lassen.

Geeignet für lange Dokumente und hochauflösende Bilder

Kimi-VL kann besonders umfangreiche Eingaben verarbeiten. Das maximale Kontextfenster umfasst 128.000 Token, was etwa dem Umfang eines ganzen Buchs oder eines langen Videos entspricht. In Benchmarks wie LongVideoBench oder MMLongBench-Doc erzielt das Modell damit sehr gute Werte.

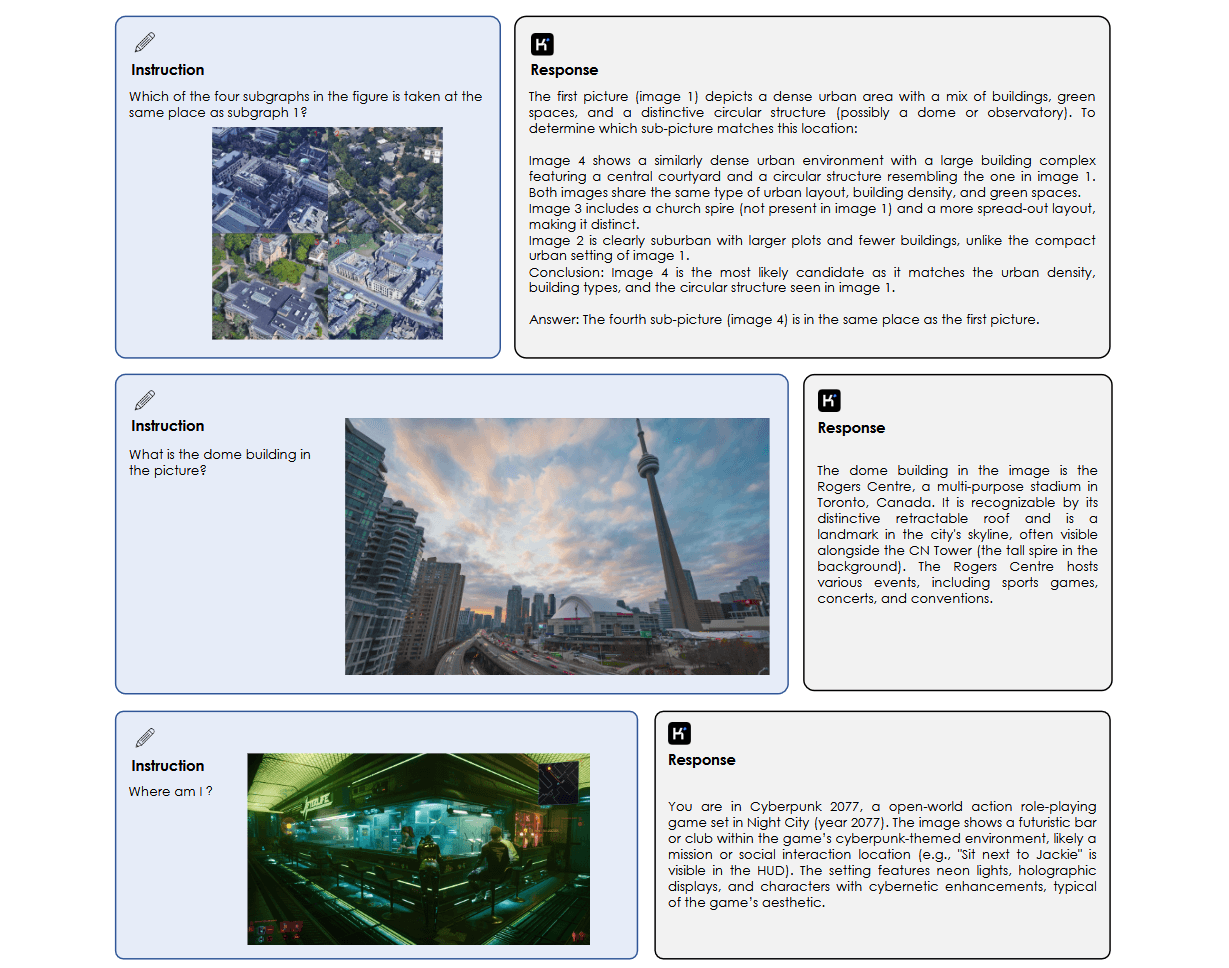

Ein weiterer Vorteil liegt in der Verarbeitung von hochauflösenden Bildern. Kimi-VL benötigt keine vorherige Aufteilung in kleinere Bildausschnitte, sondern kann komplette Screenshots oder komplexe Grafiken direkt analysieren.

Das Modell kann auch mathematische Bildaufgaben lösen oder handschriftliche Notizen erkennen. In einem Test analysierte es beispielsweise ein handgeschriebenes Manuskript und erkannte darin Bezüge zu Albert Einstein und konnte diese inhaltlich begründen.

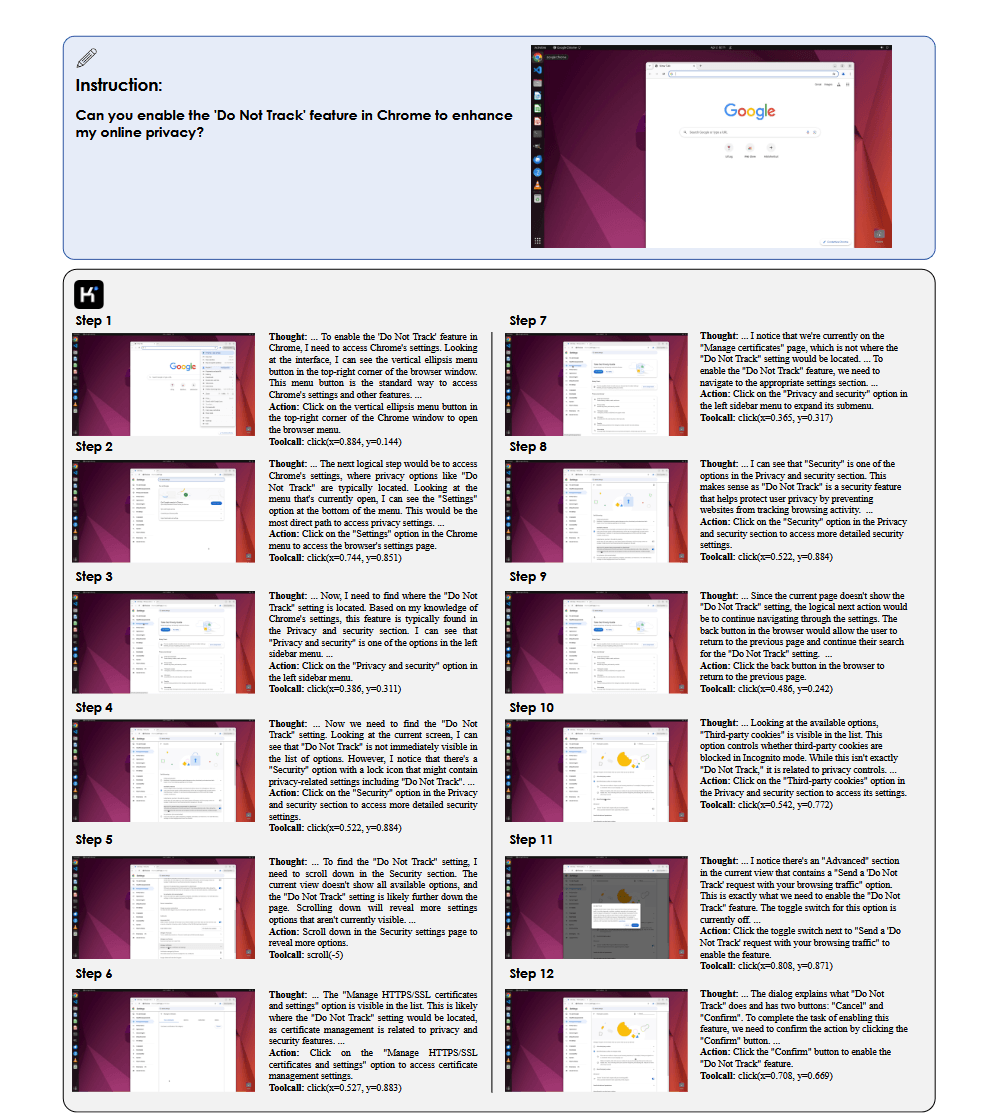

Zudem eignet sich Kimi-VL für den Einsatz als Software-Assistent. Es kann grafische Benutzeroberflächen interpretieren und dabei helfen, digitale Aufgaben zu automatisieren. In Tests, bei denen das Modell etwa durch ein Browser-Menü navigieren oder Einstellungen ändern soll, schneidet es besser ab als viele vergleichbare Systeme, sogar besser als GPT-4o.

Kompakte Architektur mit starker Leistung

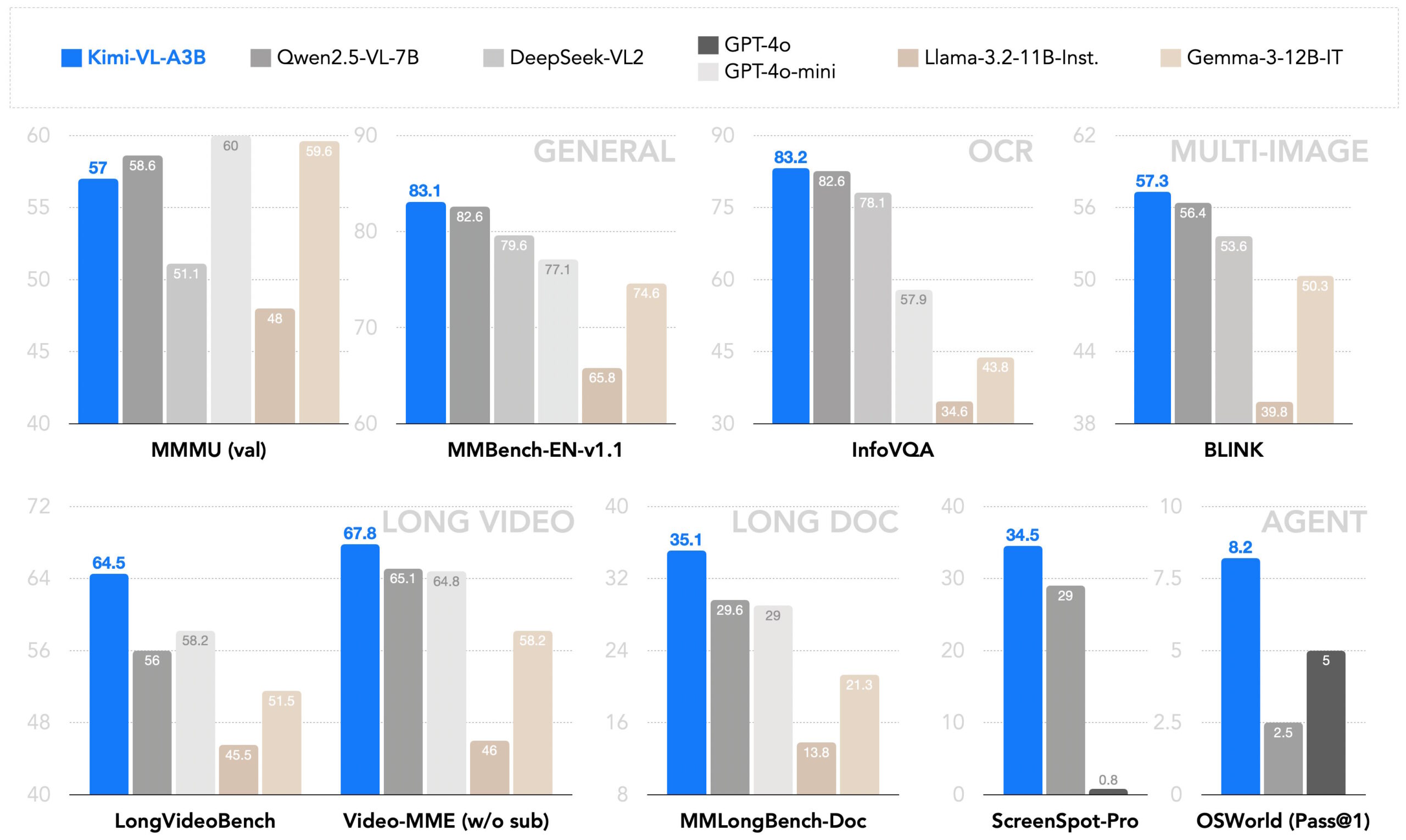

Im Vergleich zu anderen Open-Source-Modellen wie Qwen2.5-VL-7B oder Gemma-3-12B-IT überzeugt Kimi-VL mit seiner Effizienz. In 19 von 24 Benchmarks liegt es vorn – obwohl es deutlich weniger aktive Parameter nutzt. In den Tests MMBench-EN und AI2D erreicht es Werte, die sonst nur größere und kommerzielle Modelle erzielen.

Ein wichtiger Baustein dieser Leistung ist das Trainingsverfahren. Neben klassischem Supervised Fine-Tuning kommt auch Verstärkungslernen zum Einsatz. Eine spezielle Variante des Modells, Kimi-VL-Thinking, wurde zusätzlich darauf trainiert, längere Denkschritte zu durchlaufen. Dadurch verbessert sich die Leistung primär bei komplexen Aufgaben wie mathematischen Schlussfolgerungen.

Trotz der guten Ergebnisse bleibt das Modell in einigen Bereichen begrenzt. Für sehr sprachintensive oder stark spezialisierte Aufgaben reicht die vorhandene Modellgröße bisher nicht aus. Auch bei besonders langen Kontexten stößt es trotz des erweiterten Kontextfensters an technische Grenzen.

Moonshot AI plant, Kimi-VL weiterzuentwickeln. Geplant sind größere Versionen, zusätzliche Trainingsdaten und ein verbessertes Feintuning. Langfristig soll daraus ein leistungsfähiges und dennoch ressourcenschonendes System entstehen, das sich für praktische Anwendungen in Forschung und Industrie eignet.

Anfang des Jahres veröffentlichte Moonshot AI mit Kimi k1.5 ein multimodales Modell für komplexes Schlussfolgern, das in Benchmarks bereits mit GPT-4o mithalten konnte. Es ist über die Weboberfläche kimi.ai verfügbar. Eine Demo des VL-Modells gibt es bei Hugging Face.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.