Worte zu verstehen ist eine Sache, sie mit Emotionen zu verknüpfen eine andere. Facebook arbeitet an einer Künstlichen Intelligenz, die Gesichter lesen lernen soll.

Worte sind nicht gleich Worte: Der gleiche Satz einmal unterlegt mit einem grimmigen Blick, einem süffisanten Lächeln oder einem Tränchen auf der Wange kann eine völlig andere Bedeutung haben. Menschen verstehen das intuitiv und reagieren anders. Aktuelle KI-Assistenten geben immer die gleiche Antwort.

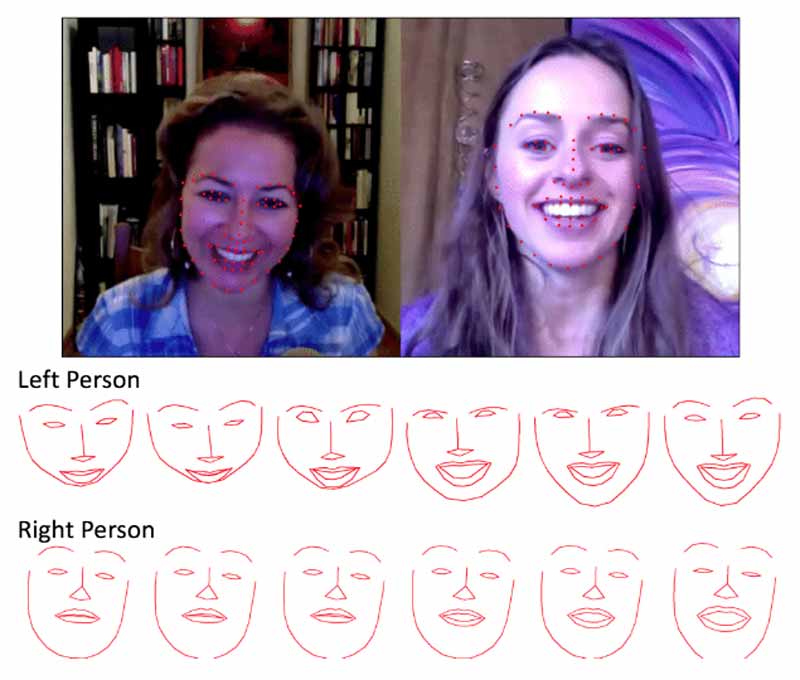

Mit hunderten YouTube-Videos von Menschen, die sich über Skype unterhalten, trainierten Facebook-Wissenschaftler eine künstliche Intelligenz, Gesichtsausdrücke besser zu erkennen. Ein Bereich, der laut den Forschern im Vergleich zur reinen Spracherkennung stark vernachlässigt ist.

Bot soll Mimik kontinuierlich in der Interaktion berücksichtigen

Bei ihrem Verfahren lassen die Forscher die KI nur ausgewählte Teile des Gesichts beobachten, die entscheidend sind für den Gesichtsausdruck, zum Beispiel die Position der Augenbrauen oder der Mundwinkel.

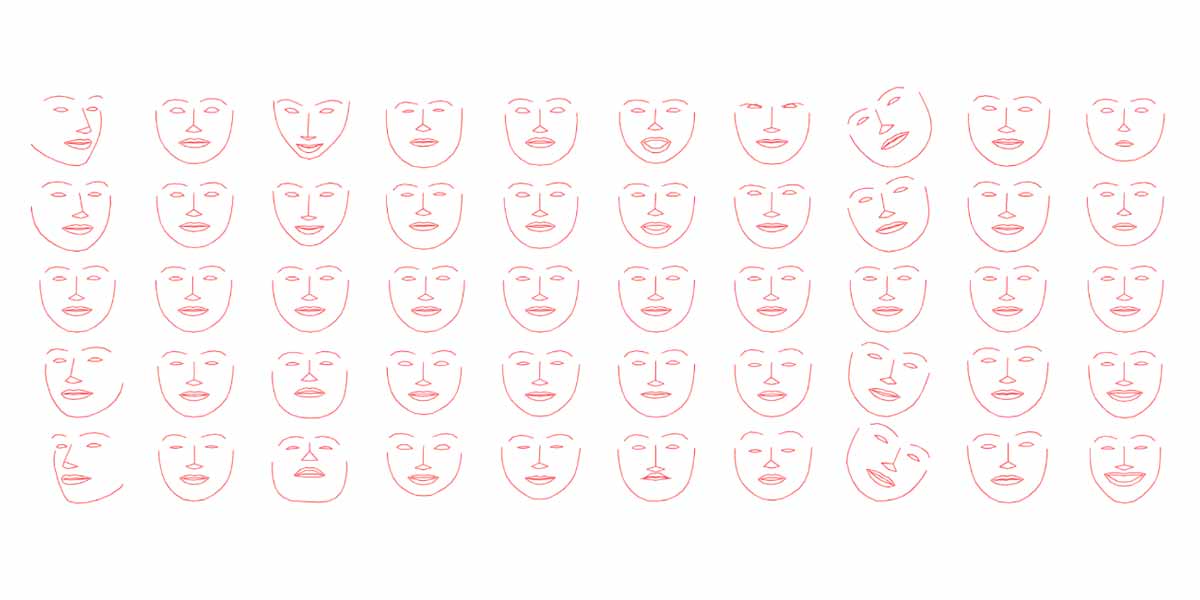

Neu dabei ist, dass die KI nicht nur vorgegebene Emotionen wie "traurig" oder "fröhlich" erkennt, sondern sogenannte Mikromimik liest. Diese leichten Veränderungen im Gesicht (siehe Titelbild) sind bei jedem Menschen ähnlich, obwohl die Gesichtszüge vollkommen unterschiedlich sind.

Der KI-Agent soll diese Mikromimik kontinuierlich in einer Konversation berücksichtigen und so den Stimmungsverlauf einer Unterhaltung lesen, anstatt nur unmittelbar auf eine einzelne, ausgewählte Emotion - zum Beispiel ein Lachen - zu reagieren.

Die Ergebnisse dieser Forschung könnte Facebook für Virtual Reality anwenden, beispielsweise um Avatare in der Social-VR-App Spaces glaubhafter zu animieren. Voraussetzung dafür wäre allerdings zusätzliche Gerätschaft, die die menschliche Mimik in der VR-Brille in Echtzeit erfasst. Möglich wäre das beispielsweise mit Elektroden auf der Gesichtspolsterung oder einer externen Kamera.

Integriert in eine Augmented-Reality-Brille, könnte ein solches KI-System Menschen helfen, die im Alltag Probleme damit haben, Gesichter und Emotionen zu lesen. Die vollständige Publikation ist hier einsehbar.