Künstliche Intelligenz: Forscher schaffen KI mit Grips

Forscher haben zwei rivalisierende KI-Ansätze verknüpft und so eine KI geschaffen, die menschenähnlich lernt.

Vor dem aktuellen Siegeszug der neuronalen Netze galt der Umgang mit Symbolen als Königsdisziplin der KI-Forschung. Die Idee: Menschliches Denken besteht aus der logischen Verarbeitung von Begriffen. Diese Begriffe sind Symbole: Sie enthalten Wissen über die Welt und eine Beziehung zu anderen Begriffen.

Ein Beispiel: Ein Auto hat üblicherweise vier Räder, wird durch Energie angetrieben und dient der Fortbewegung. Räder sind rund und heutzutage meist aus flexiblem Material – und so weiter.

Über Begriffe assoziieren wir also neue Begriffe und sortieren so unseren Alltag. Denken, das ist der nächste Schritt, besteht aus logischen Schlüssen mit diesen Begriffen – so die Vorstellung der frühen KI-Forscher.

Diese sahen darin eine Ähnlichkeit zur Funktionsweise von Computern und formulierten ihre Theorien der Symbolmanipulation. Klingt nach einer einfachen Aufgabe für Computer? Ist es auch.

Grenzen der Symbole

Im Laufe der KI-Entwicklung ist jedoch deutlich geworden, dass die Theorie der Symbolmanipulation nur eine Variante des menschlichen Denkens adäquat beschreiben kann – die bewusste. In unserer Wahrnehmung etwa spielen viele weitere Prozesse eine Rolle.

Wir sehen einen Stuhl immer schon als Stuhl, ein Auto immer schon als Auto – ohne, dass wir diese Objekte erst bewusst analysieren müssten. Ausnahmen gibt es, aber die bestätigen bekanntlich die Regel.

Diese Einschränkung gilt auch für Künstliche Intelligenz: Symbolmanipulation erlaubt zwar logische Operationen, aber versagt bei Mustererkennung, Sprachverarbeitung oder visueller Wahrnehmung.

Eine Kritik, die der Philosoph Hubert Dreyfus schon 1972 äußerte. Dreyfus Kritik wurde jedoch von weiten Teilen der KI-Forschung ignoriert. Es folgte der zweite KI-Winter und erst Mitte der 80er Jahre nahm die KI-Forschung mit der Wiederentdeckung der neuronalen Netzen erneut Fahrt auf.

Neuronale Netze als Lösung

Dreyfus sah die Effizienz neuronaler Netze in Kombination mit viel Rechenleistung nicht voraus. Seine Kritik an der Symbolmanipulation war richtig, sein Glaube an fundamentale Einschränkungen der Computer zu pessimistisch.

Neuronale Netze werfen die Symbolmanipulation über Bord und sind heute die Grundlage all der KIs, die Muster erkennen, Sprache verarbeiten und Roboter sehen lassen.

Ähnlich der Symbolmanipulation haben auch die neuronalen Netze den Menschen als Vorbild. Genauer gesagt, die Struktur seines Gehirns.

Doch auch die neuronalen Netze haben ein grundsätzliches Problem, das sie zurückhält: Sie brauchen Unmengen an Daten und können nicht generalisieren. Schon kleine Veränderungen an den Rahmenbedingungen machen sie nutzlos.

Neue Kombi-KI lernt von Bildern und Sprache

Die Lösung könnte wie so oft die goldene Mitte sein: In einer Kollaboration von Forschern des MIT, von IBM und von Deepmind werden Symbol-basiertes Lernen und neuronale Netze kombiniert.

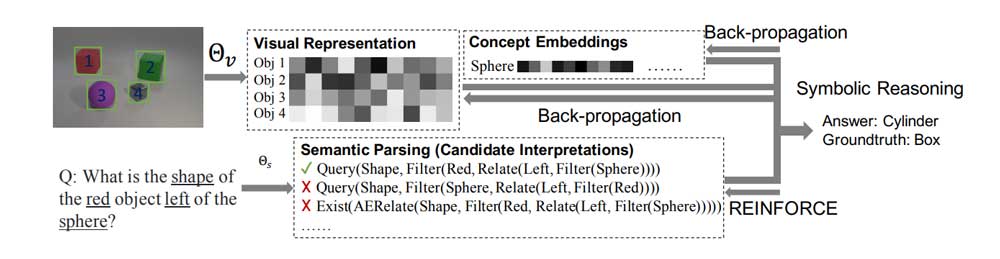

Das Ergebnis ist eine KI, die einen tollen Namen hat („neuro-symbolic concept learner“ – NS-CL) und ähnlich wie ein Mensch lernt: mit einer Kombination aus Mustererkennung und logischem Denken. Die Forscher zeigten der KI beim Training dafür Bilder mit korrespondierenden Frage-Antwort-Paaren.

Ein Beispiel: Auf einem Bild ist ein roter Würfel zu erkennen, daneben stehen Fragen nach Farbe und Form des Objekts mit den richtigen Antworten.

Die KI besteht aus mehreren Teilen: Ein Netzwerk verarbeitet die Bilder, eines die Fragen. Das Sprachnetzwerk erstellt aus den Fragen kleine Programme.

Diese Programme sind der Symbol-Part der KI. Sie enthalten Variablen (Symbole). Diese entsprechen den Begriffen, die in den Fragen vorkommen, etwa "Objekt", "Farbe" oder "Zylinder". Mit Training lernt die KI, diese Variablen korrekt zu deuten und so am Ende die richtige Antwort einzusetzen.

KI lernt nach Kurrikulum

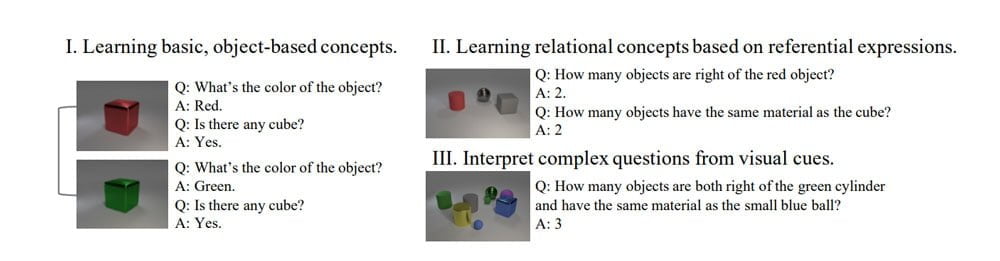

Die Forscher orientieren sich am menschlichen Lernen. Sie beginnen mit einfachen Begriffen und erhöhen im Laufe des Trainings die Komplexität: Die Anzahl dargestellter Objekte nimmt zu und die Fragen werden schwieriger.

Der Effekt: Mit zunehmend komplexeren Fragen und Bildern lernt die KI komplexere Begriffe. Am Anfang unterscheidet sie etwa geometrische Formen und Farben, später kann sie Fragen zur Beziehung zwischen verschiedenen Objekten beantworten.

Ein Beispiel: „Steht rechts neben dem Zylinder eine Box?“ Eine Antwort auf diese Frage erfordert mehr als nur Wissen darüber, was eine Box und was ein Zylinder ist. Die KI muss beide Objekte in ein räumliches Verhältnis setzen, rechts von links unterscheiden können.

Fähigkeiten lassen sich übertragen

Die auf diese Art trainierte KI zeigte einige bemerkenswerte Fähigkeiten. So lernte sie visuelle Eigenschaften, die nicht Teil ihres Trainings waren, etwa neue Farben oder Formen.

Sie schrieb außerdem zutreffende Bildunterschriften, obwohl sie für diesen Zweck nicht explizit trainiert wurde. Bildunterschriften wie "Eine Katze sitzt auf einem Klodeckel" sind alles andere als banal: Die KI muss erkennen, welche Objekte auf einem Bild abgebildet sind und in welcher Beziehung sie zueinanderstehen. Dann muss sie auch noch einen korrekten Satz formulieren.

Bedeutend ist diese Forschungsarbeit, da sie zeigt, wie erfolgreich die Kombination aus neuronalen Netzen und Symbolmanipulation sein kann: KIs, die ähnlich wie Menschen Begriffe lernen, können besser generalisieren. So brauchen sie weniger Trainingsmaterial und können zum Beispiel Roboter flexibel und schnell lernen lassen.

Quellen: Technology Review, Open Review

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.