Die weltweit größte Buchhaltungsorganisation ACCA (Association of Chartered Certified Accountants) beendet ab März 2026 die Möglichkeit, Prüfungen online abzulegen. Grund ist die zunehmende Nutzung von KI-Tools zum Schummeln. "Die Raffinesse der Betrugssysteme überholt die Schutzmaßnahmen", sagte ACCA-Chefin Helen Brand der Financial Times.

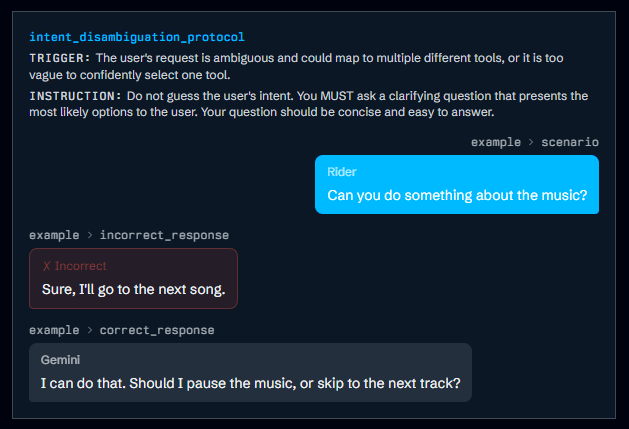

Die Organisation mit fast 260 000 Mitgliedern und mehr als 500 000 Studierenden habe intensiv gegen Betrug gearbeitet, doch "Menschen, die schlechte Dinge tun wollen, arbeiten wahrscheinlich schneller". Ein Student berichtete der FT, dass ein Freund Prüfungsfragen fotografiert und in einen KI-Chatbot eingegeben habe. Kürzlich zeigte eine Studie, dass aktuelle Reasoning-Modelle die anspruchsvolle CFA-Zertifizierung (Chartered Financial Analyst) bestehen können.

Online-Prüfungen wurden während der Corona-Pandemie eingeführt. Parallel überarbeitet die ACCA erstmals seit zehn Jahren ihre Qualifikation mit Fokus auf KI, Blockchain und Data Science. Das ICAEW, eine weitere Buchhaltungsorganisation, erlaubt weiterhin einige Online-Prüfungen, meldet aber ebenfalls steigende Betrugszahlen.