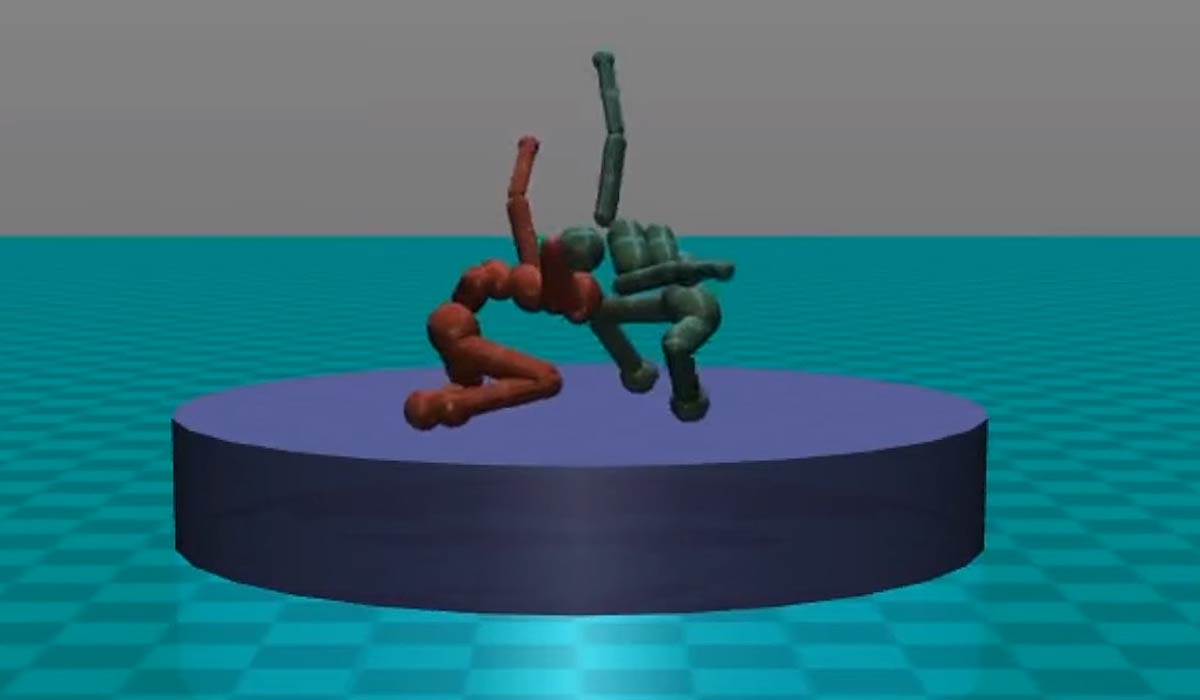

Forscher von OpenAI lassen zwei KI-Systeme beim Sumoringen gegeneinander antreten. Das visuelle Ergebnis hat eine ganz eigene Ästhetik.

Viele KI-Projekte erinnern an ein Kleinkind bei der Weltenentdeckung: Irgendwie ungelenk und im gleichen Moment faszinierend.

Diese Beobachtung trifft auch auf das neueste Forschungsexperiment von OpenAI zu. Die Non-Profit-Organisation will eine KI entwickeln, die gesellschaftlichen Nutzen stiftet und Risiken ausschließt. Sie wird unter anderem vom Tech-Milliardär Elon Musk unterstützt.

Im neuesten Experiment lassen OpenAI-Wissenschaftler zwei KI-Systeme als humanoide Figuren beim Sumoringen und Elfmeterschießen gegeneinander antreten. Ziel des Experiments ist es, dass Algorithmen physische Fähigkeiten entdecken, sich dabei wie Menschen gegenseitig trainieren und gezielt Schwächen finden und auszunutzen.

Laut den Wissenschaftlern zeigten die Künstlichen Intelligenzen in dem Experiment ähnliche Verhaltensweisen wie Menschen in der gleichen Situation. Die Positionen und Bewegungen der KI-Ringer erinnerten an einen realen Ringkampf. Beispielsweise duckten sich die KI-Sumoringer für mehr Stabilität oder kämpften an der Ringkante, um dem Gegner auszuweichen und über die Ringgrenze laufen zu lassen.

Lernen mit Belohnungen

Basis des Experiments sind Verfahren aus dem bestärkenden Lernen: Ähnlich wie Menschen können KI-Systeme mit Belohnungen zum Lernen motiviert werden. Beim Sumo-Experiment bekam die siegreiche KI 1.000 Punkte. Für eine Niederlage oder ein Unentschieden wurden 1.000 Punkte abgezogen.

Über diese Belohnungen kann der Lernfokus des KI-Systems gesteuert werden. Beim Elfmeterschießen mussten die Digitalathleten zuerst lernen, zu gehen und zu laufen. Als das nach vielen Wiederholungen gelang, wurden die Belohnungen neu dem Tore schießen oder verhindern zugeordnet.

"Das Verhalten scheint zu dem zu passen, was Menschen in der gleichen Situation tun würden, inklusive Ablenkungsstrategien", sagt Idor Mordatch, Leiter des Forschungsprojekts.

Es sei schwierig, den Lernprozess im Detail nachzuvollziehen, da er über tausende Iterationen hinweg stattfinde. Die Forscher können daher nicht mit Sicherheit bestimmen, welches Verhalten wirklich gelernt und wann es nur ein reines Zufallsprodukt ist.

Das Paper ist hier einsehbar, der dazugehörige Code steht hier.

https://www.youtube.com/watch?v=YyQlgLA9KUs

https://www.youtube.com/watch?v=h_ogRpDsGks