Laions neuer Datensatz zeigt, wie KI beim KI-Training helfen kann

Ein neuer Datensatz von Laion zeigt, wie KI beim KI-Training helfen und zukünftige Bild-KIs noch besser machen kann.

Gängige Bild-KI-Systeme wie DALL-E 2, Stable Diffusion oder Midjourney können anhand von Texten Bilder generieren. Diese Fähigkeit erlangen sie durch das Training mit Text-Bild-Paaren aus dem Web.

Viele Bilder im Web sind jedoch unpassend, unvollständig oder gar nicht beschriftet. Wären diese Bilder detaillierter und korrekt beschriftet, können zukünftige Bild-KI-Systeme Motive besser verstehen und Bilder generieren, die besser zum Text passen.

LAION-COCO: KI hilft bei der Bildbeschreibung

An dieser Stelle kommt der neue LAION-COCO-Datensatz der Forschungsorganisation Laion ins Spiel. Laion ist auf die Zusammenstellung von großen Datensätzen für das KI-Training spezialisiert.

Bekannt ist etwa der Laion5B-Datensatz, der unter anderem für das Training von Stable Diffusion verwendet wird. An dem Datensatz wird teils Kritik geübt, da in den mehr als fünf Milliarden verlinkten Bildern auch solche enthalten sind, die nicht für das KI-Training vorgesehen sind.

Für LAION-COCO generierte Laion für 600 Millionen der in Laion5B verlinkten Bilder ergänzende Bildbeschriftungen. Für die Textgenerierung verwendete Laion eine Kombination aus BLIP L/14 und 2 CLIP-Versionen (L/14 und RN50x64). BLIP L/14 generierte 40 Beschriftungen, CLIP Open AI L/14 wählte unter diesen die Top 5, unter denen das RN50x64-Modell dann die beste Beschriftung bestimmte.

Der Datensatz solle bei der Erforschung helfen, ob synthetisch generierte Bildunterschriften von Menschen geschriebene ergänzen können, schreibt Laion. Mit dem Datensatz trainierte Modelle könnten den Wert generierter Beschriftungen zeigen.

Maschinelle Beschriftungen auf Mensch-Niveau - meistens

Bei einer ersten Evaluation ließ Laion 200 Bilder, 100 von Menschen untertitelt und 100 maschinell, von menschlichen Tester:innen bewerten.

In 47,5 Prozent aller Fälle waren die Tester:innen der Meinung, dass eigentlich maschinell geschriebene Beschriftungen von Menschen geschrieben wurden. "Das macht uns zuversichtlich, dass unsere Untertitel im Durchschnitt ziemlich gut sind", schreibt Laion.

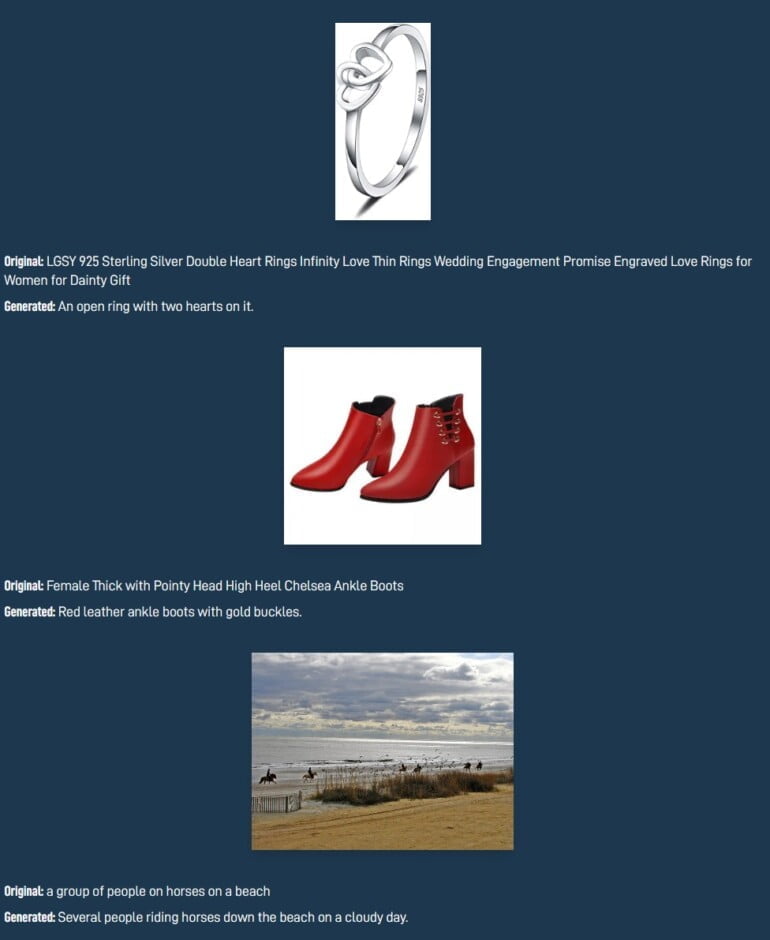

Im Gespräch nach der Evaluation gaben Tester:innen an, dass es abseits von offensichtlichen Fehlern sehr schwierig gewesen sei, menschliche und maschinelle Beschriftungen auseinanderzuhalten. Diese offensichtlichen Fehler (siehe Bilder unten) führt Laion auf fehlende Konzepte für das, was im Bild passiert, und ein "nicht ausreichend ausgefeiltes Weltmodell" zurück.

Den kostenlosen Download von LAION-COCO gibt es bei Huggingface. Der Datensatz besteht aus Parquet-Dateien. Die Spalten enthalten die ursprüngliche Beschriftung, die URL zum Bild, die oberste Beschriftung und eine Liste alternativer Beschriftungen mit niedrigeren CLIP-Bewertungen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.