Lightricks macht KI-Videomodell LTX-2 offen und fordert Sora und Veo heraus

Kurz & Knapp

- Lightricks hat LTX-2 als Open Source veröffentlicht – ein 19-Milliarden-Parameter-Modell, das bis zu 20 Sekunden Video mit synchronisiertem Audio aus Textbeschreibungen erzeugt.

- Auf einer Nvidia H100 ist LTX-2 laut Herstellerangaben 18-mal schneller als vergleichbare Modelle und übertrifft bei der Videolänge auch Googles Veo 3 und OpenAIs Sora 2.

- Die Open-Source-Entscheidung begründet Lightricks mit dem Wunsch, KI auf eigener Hardware zu betreiben und ethische Fragen mit der Community zu klären.

Das israelische Unternehmen Lightricks hat sein 19-Milliarden-Parameter-Modell LTX-2 als Open Source veröffentlicht. Das System generiert synchronisierte Audio-Video-Inhalte aus Textbeschreibungen und soll schneller sein als die Konkurrenz.

Das Modell generiert laut dem technischen Bericht bis zu 20 Sekunden Video mit synchronisiertem Stereo-Audio aus einer einzigen Textbeschreibung. Dabei entstehen Sprache mit Lippensynchronisation, Hintergrundgeräusche, Foley-Sounds und Musik, die zur jeweiligen Szene passen sollen. In der vollständigen Version erreicht LTX-2 laut Lightricks 4K-Auflösung bei bis zu 50 Bildern pro Sekunde.

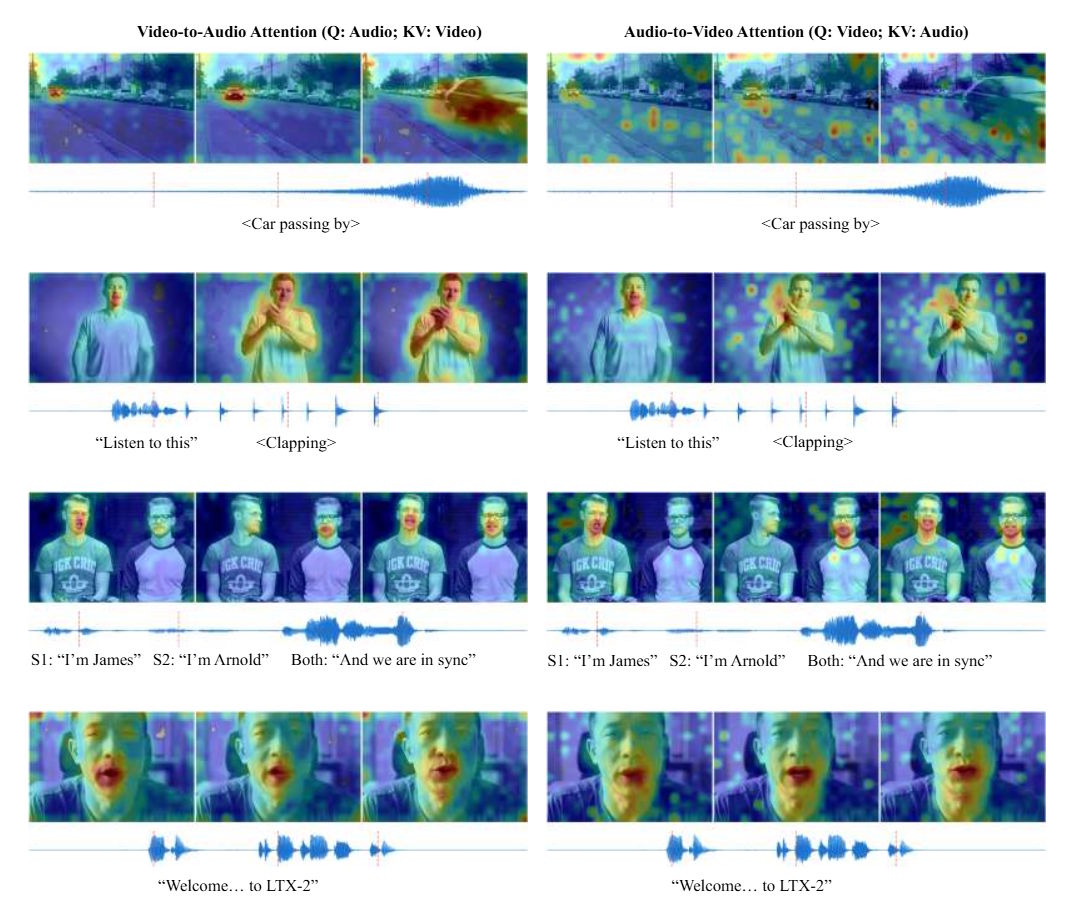

Die Forscher argumentieren, dass bisherige Ansätze zur audiovisuellen Generierung grundsätzlich suboptimal seien. Viele Systeme arbeiten sequenziell: Erst wird Video erzeugt, dann Audio hinzugefügt, oder umgekehrt. Solche entkoppelten Pipelines könnten die tatsächliche gemeinsame Verteilung beider Modalitäten nicht erfassen. Während etwa Lippensynchronisation primär vom Audio abhänge, werde die akustische Umgebung vom visuellen Kontext bestimmt. Nur ein einheitliches Modell könne diese bidirektionalen Abhängigkeiten abbilden.

Asymmetrische Architektur verteilt Rechenleistung gezielt

LTX-2 basiert auf einem asymmetrischen Dual-Stream-Transformer mit insgesamt 19 Milliarden Parametern. Der Video-Stream erhält mit 14 Milliarden Parametern deutlich mehr Kapazität als der Audio-Stream mit 5 Milliarden. Diese Aufteilung spiegelt laut den Forschern die unterschiedliche Informationsdichte beider Modalitäten wider.

Beide Streams nutzen separate Variational Autoencoder für ihre jeweilige Modalität. Diese Entkopplung ermöglicht modalitätsspezifische Positionskodierungen: 3D-Rotary-Position-Embeddings (RoPE) für die räumlich-zeitliche Struktur des Videos, eindimensionale Embeddings für die rein zeitliche Dimension des Audios. Die Verbindung zwischen beiden Streams erfolgt über bidirektionale Cross-Attention-Schichten, die visuelle Ereignisse wie den Aufprall eines Objekts mit den entsprechenden Geräuschen zeitlich präzise verknüpfen sollen.

Für das Textverständnis setzt LTX-2 auf Gemma3-12B als multilingualen Encoder. Statt nur die letzte Schicht des Sprachmodells abzufragen, zapft das System alle Decoder-Schichten an und kombiniert deren Informationen. Zusätzlich nutzt das Modell sogenannte "Thinking Tokens", zusätzliche Platzhalter in der Eingabesequenz, die dem Modell mehr Raum geben, um komplexe Prompts zu verarbeiten, bevor die eigentliche Generierung beginnt.

18-mal schneller als vergleichbare Modelle

Bei der Inferenzgeschwindigkeit zeigt LTX-2 laut den Benchmarks deutliche Vorteile. Auf einer Nvidia H100-GPU benötigt das Modell 1,22 Sekunden pro Schritt für 121 Frames bei 720p Auflösung. Das vergleichbare Wan2.2-14B, das nur Video ohne Audio generiert, benötigt dafür 22,30 Sekunden. LTX-2 ist damit nach Herstellerangaben 18-mal schneller.

Die maximale Videolänge von 20 Sekunden übertrifft ebenfalls die Konkurrenz: Googles Veo 3 schafft 12 Sekunden, OpenAIs Sora 2 erreicht 16 Sekunden, das Open-Source-Modell Ovi von Character.AI kommt auf 10 Sekunden. In menschlichen Präferenzstudien soll LTX-2 Open-Source-Alternativen wie Ovi "signifikant übertreffen" und Ergebnisse erzielen, die mit proprietären Modellen wie Veo 3 und Sora 2 vergleichbar seien.

Die Forscher räumen aber auch mehrere Limitationen ein. Die Qualität variiere je nach Sprache: Bei unterrepräsentierten Sprachen oder Dialekten könne die Sprachsynthese weniger präzise ausfallen. In Szenen mit mehreren Sprechern weise das Modell gesprochene Inhalte gelegentlich den falschen Charakteren zu. Bei Sequenzen über 20 Sekunden könne es zu zeitlichem Drift und verschlechterter Synchronisation kommen.

Lightricks setzt auf offene Kontrolle statt geschlossener APIs

Die Entscheidung zur Open-Source-Veröffentlichung begründet Lightricks mit grundsätzlicher Kritik am aktuellen Marktgeschehen. "Ich sehe einfach nicht, wie man das mit geschlossenen APIs erreichen kann", sagt Lightricks-Gründer Zeev Farbman im Ankündigungsvideo über die Versprechen aktueller Videogenerierungsmodelle. Man befinde sich in einer Lücke: Einerseits könne man beeindruckende Ergebnisse erzeugen, andererseits sei man weit entfernt von dem Kontrollniveau, das Profis benötigen.

Das Unternehmen formuliert auch eine explizit ethische Position: "Künstliche Intelligenz kann menschliche Kreativität und Intelligenz erweitern. Was mich besorgt, ist, dass jemand anderes meine Erweiterung besitzen wird", so Farbman weiter. Man wolle KI auf eigener Hardware und zu eigenen Bedingungen laufen lassen und ethische Überlegungen mit einer breiten Community von Kreativen treffen, statt sie an eine ausgewählte Gruppe mit eigenen Interessen auszulagern.

Neben den Modellgewichten umfasst die Veröffentlichung auch eine destillierte Version, mehrere LoRA-Adapter sowie ein modulares Training-Framework mit Multi-GPU-Unterstützung. Das Modell wurde für Nvidias RTX-Ökosystem optimiert und soll auf Consumer-GPUs wie der RTX 5090 ebenso laufen wie auf Enterprise-Systemen. Die Modellgewichte und der Code sind auf GitHub und Hugging Face verfügbar und es gibt nach kostenloser Registrierung eine Demo auf einer eigenen Content-Plattform.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren