LLMs liefern absurde Lösungen für einfaches Flussüberquerungs-Rätsel

Was braucht es noch, um die logische Unfähigkeit großer Sprachmodelle zu beweisen? Einfache Planungsrätsel sind en vogue.

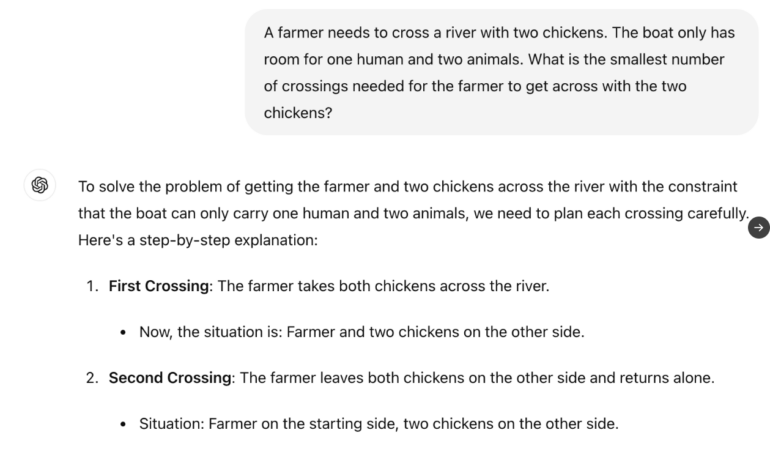

Aktuelle Sprachmodelle sind nicht in der Lage, verlässlich eine stark vereinfachte Version des Wolf-Ziege-Kohl-Problems zuverlässig zu lösen, bei dem es für das LLM unter anderem darum geht, eine logische Verbindung zwischen "Bauer" als Rolle des Menschen und "Schaf" als Tierart herzustellen und die optimale Anzahl von Flussüberquerungen zu planen. Mitunter liefern die Modlle absurde Lösungen mit fünf statt einer Überquerung.

"Ein Bauer will mit zwei Hühnern einen Fluss überqueren. Sein Boot hat nur Platz für eine Person und zwei Tiere. Wie viele Überquerungen braucht der Bauer mindestens, um mit seinen Hühnern auf die andere Seite zu gelangen?"

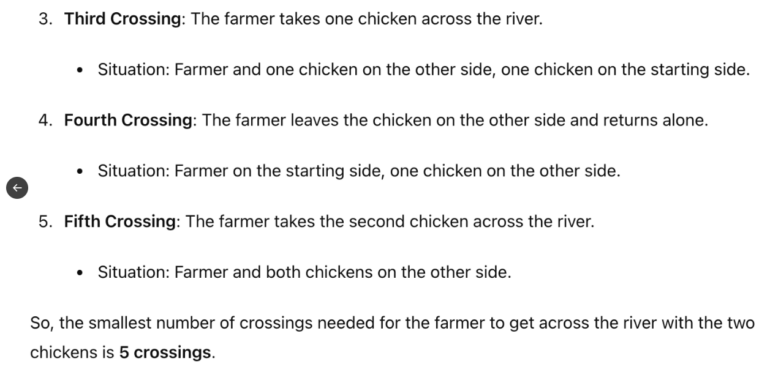

Bei X zeigen die Nutzerinnen und Nutzer zahlreiche Variationen des Rätsels, die teilweise zu absurden Ergebnissen führen und demonstrieren, dass das Sprachmodell zum Teil nicht einmal die eigentliche Aufgabe richtig berücksichtigt.

So heißt es im folgenden Aufgabenbeispiel, der Bauer müsse den Fluss gar nicht überqueren. Dennoch schlägt das LLM insgesamt neun Überquerungen vor, bei denen die im Rätsel erwähnten Wölfe garantiert alle Hühner gefressen hätten, da der Bauer seine Hühner ständig mit den Wölfen allein gelassen hätte. Eine Bedingung war jedoch, dass der Bauer die Hühner nie allein ließ, was möglich gewesen wäre, da er laut Rätsel den Fluss gar nicht überqueren wollte.

Mit alternativen Prompts können die Modelle auch korrekte Ergebnisse liefern, aber letztlich unterstreicht das nur die Tatsache, dass LLMs "keinen gesunden Menschenverstand, kein Weltverständnis und keine Fähigkeit zu planen (und zu denken)" haben. Auch aktuelle Forschungen bestätigen, dass Sprachmodelle nicht in der Lage sind, selbst einfachste Rätsel mit minimalem logischem Aufwand zuverlässig zu lösen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.