Meta erleichtert den Einstieg in die Llama-Entwicklung mit "Llama-Stack"

Meta hat mit Llama Stack 0.1.0 eine neue Entwicklungsplattform vorgestellt, die Unternehmen den Einstieg in die KI-Entwicklung mit Llama-Modellen erleichtern soll. Die Plattform standardisiert Bausteine für KI-Anwendungen und bietet flexible Deployment-Optionen.

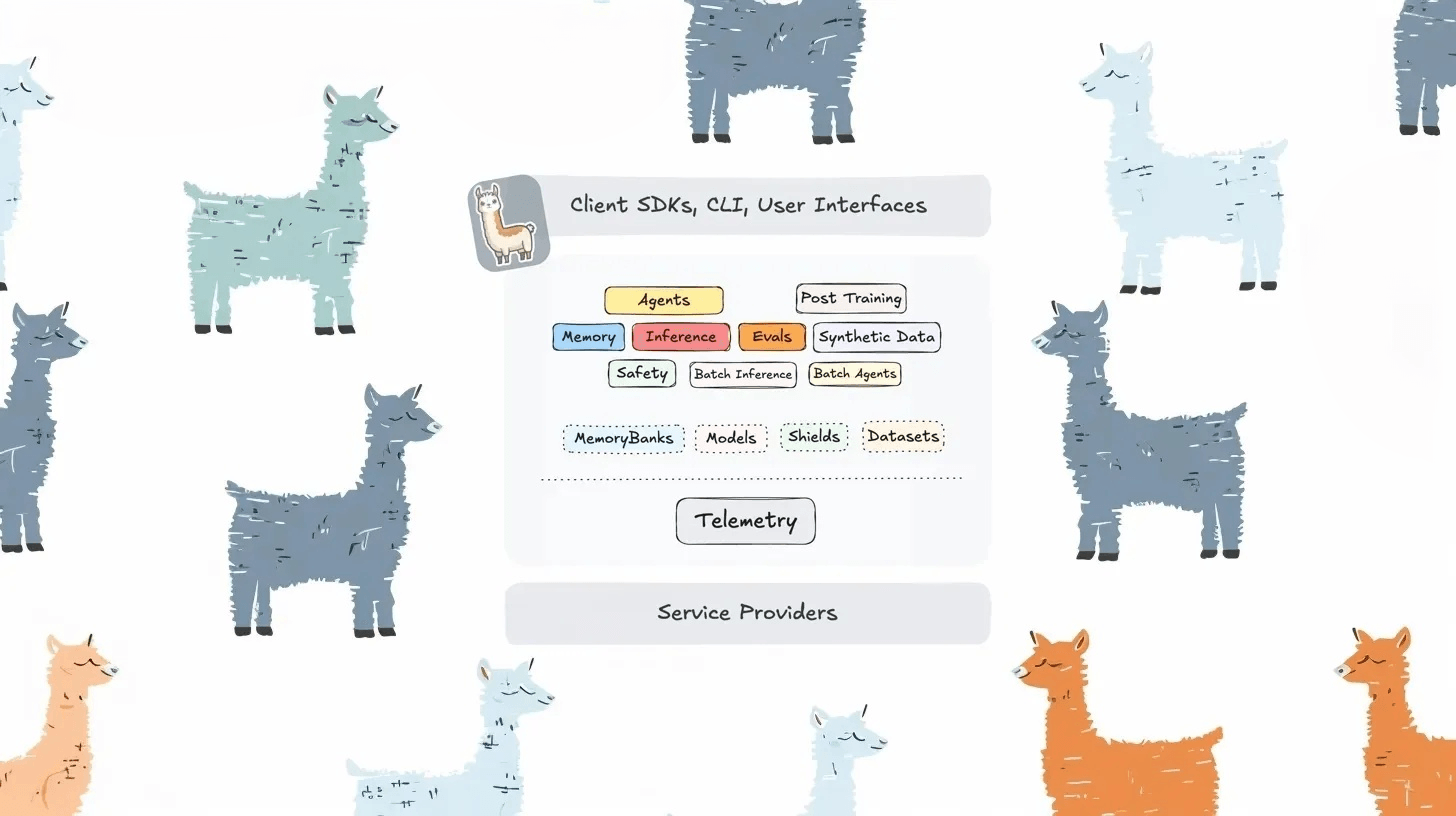

Llama Stack definiert sich als universelle Entwicklungsplattform für KI-Anwendungen mit einem besonderen Fokus auf Metas Llama-Modelle. Die Plattform bietet laut Meta eine einheitliche API-Schicht für zentrale KI-Funktionen wie Inferenz, RAG (Retrieval Augmented Generation), Agenten, Tools, Sicherheit, Evaluierung und Telemetrie.

Ein Kernmerkmal ist die Plugin-Architektur, die verschiedene API-Provider unterstützt. Entwickler können zwischen Remote-Providern wie Fireworks oder AWS Bedrock und lokalen Implementierungen wählen. Meta betont, dass für jede API mindestens ein lokaler Provider zur Verfügung steht, um die Entwicklung ohne externe Abhängigkeiten zu ermöglichen.

Für die Entwicklung stehen CLI-Tools und SDKs für Python, Node, iOS und Android zur Verfügung. Weitere APIs für Batch-Verarbeitung, Finetuning und synthetische Datengenerierung sind in Entwicklung. Einige Standalone-Beispiel-Anwendungen gibt es hier.

Flexible Distributionen für verschiedene Einsatzszenarien

Meta bietet verschiedene vorkonfigurierte Distributionen von Llama Stack an: Remote-gehostete Versionen ermöglichen einen schnellen Start per API-Key, während lokal gehostete Distributionen mehr Kontrolle bieten. Für Edge-Geräte sind spezielle On-Device-Distributionen für iOS und Android (in Kürze) verfügbar.

Die Plattform unterstützt auch die föderierte Nutzung von Ressourcen über verschiedene Provider hinweg. So können beispielsweise einige Llama-Modelle von Fireworks und andere von AWS Bedrock bereitgestellt werden, während sie über die einheitliche Inferenz-API von Llama Stack nahtlos zusammenarbeiten.

Mit Llama Stack adressiert Meta laut eigenen Angaben die Herausforderung, dass GenAI-Entwickler mehr als nur ein Sprachmodell benötigen. Sie müssen Tools integrieren, Datenquellen anbinden, Leitplanken etablieren und LLM-Antworten effektiv erden. Bisher mussten Entwickler verschiedene Tools und APIs zusammenfügen, was den Entwicklungszyklus verkomplizierte und die Kosten erhöhte.

Die Philosophie Llama Stack basiert auf einem serviceorientierten Ansatz mit REST-APIs, die saubere Schnittstellen und nahtlose Übergänge zwischen verschiedenen Umgebungen ermöglichen. Meta bezeichnet die Plattform als "turnkey solution" für populäre Deployment-Szenarien.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.