Meta stellt KI-Modelle für menschenzentrierte Bildanalyse vor

Meta hat eine neue Familie von KI-Modellen namens "Sapiens" vorgestellt, die sich auf die Analyse von Bildern mit Menschen spezialisieren.

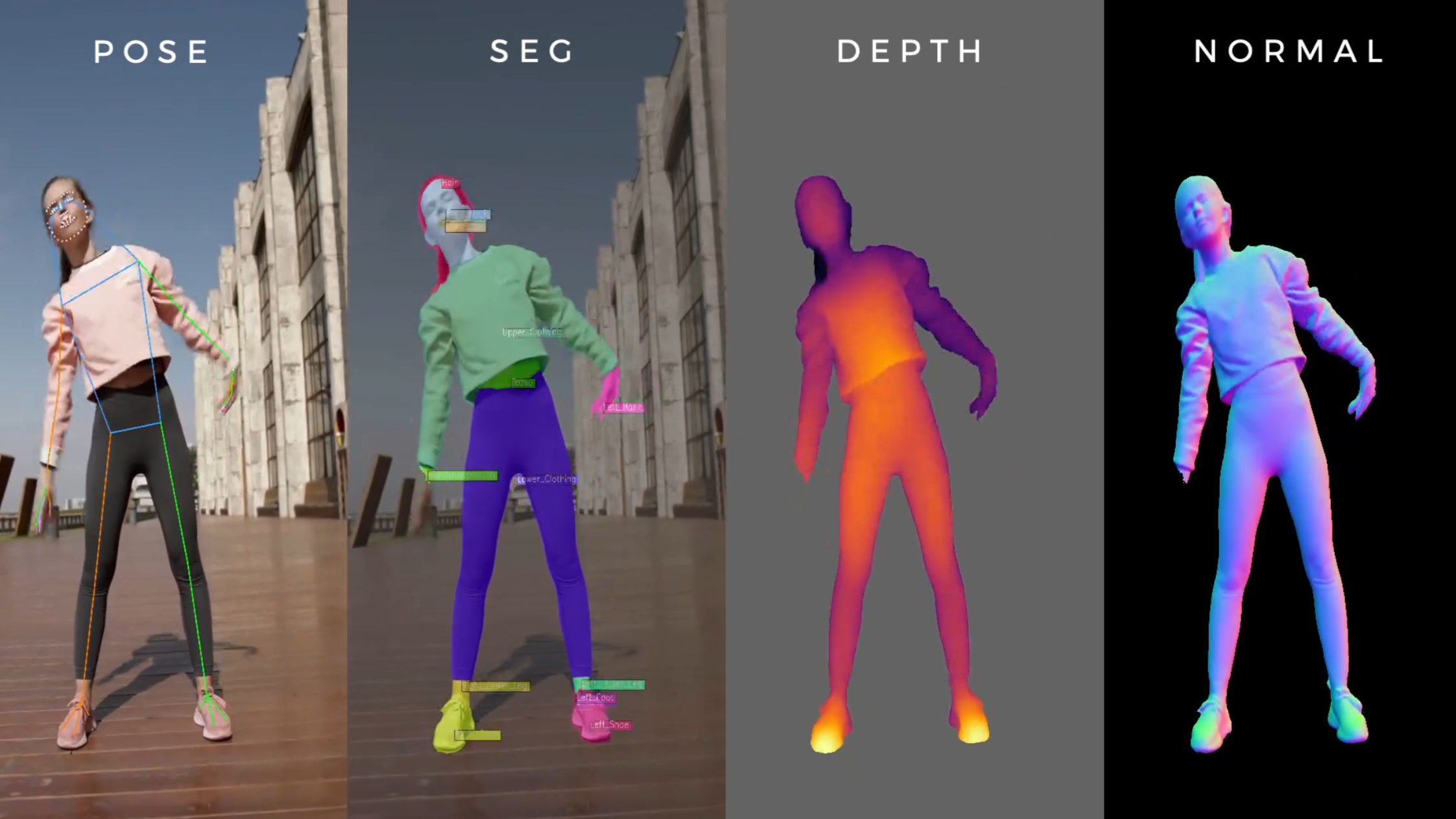

Die Modelle wurden mit einem Datensatz von 300 Millionen menschlichen Bildern vortrainiert und können verschiedene Aufgaben wie 2D-Posenschätzung, Körpersegmentierung, Tiefenschätzung und Oberflächennormalschätzung ausführen. Bei letzterer wird für jeden Punkt eines Bildes die Orientierung der Oberfläche im dreidimensionalen Raum bestimmt. Diese Information ist wichtig für das Verständnis der 3D-Struktur von Objekten und Personen im Bild und spielt eine wichtige Rolle für die realistische Beleuchtung in 3D-Rekonstruktionen.

Laut Meta übertreffen die Sapiens-Modelle bestehende Ansätze bei diesen Aufgaben deutlich. Bei der Körpersegmentierung, bei der einzelne Körperteile in Bildern identifiziert werden, erzielt das Sapiens-2B-Modell etwa eine Verbesserung von mehr als 17 Prozentpunkten gegenüber früheren Methoden.

Video: Meta

Die Forscher betonen, dass die Leistung der Modelle mit ihrer Größe zunimmt: Das größte Modell, Sapiens-2B, verfügt über 2 Milliarden Parameter und wurde nativ mit einer Bildauflösung von 1024 mal 1024 Pixeln trainiert. Dies ermöglicht laut Meta eine detailliertere Analyse als bei herkömmlichen Modellen mit niedrigerer Auflösung.

Sapiens-Modelle könnten bessere Datensätze ermöglichen

Als Schlüsselfaktor für die Leistung der Sapiens-Modelle sehen die Forscher das Vortraining auf dem großen, kuratierten Datensatz von Menschenbildern. Diese führe zu einer besseren Generalisierung auf reale Szenarien als ein Training auf allgemeinen Bilddaten, wie es sonst üblich ist. Ein Beispiel für ein solches System ist Metas Segment Anything 2.

Trotz der besseren Leistung gibt es laut dem Team aber immer noch Probleme bei komplexen Posen, Menschenmengen und starken Verdeckungen. Die Sapiens-Modelle könnten auch als Werkzeug dienen, um große Mengen realer Daten zu annotieren und so die nächste Generation menschenzentrierter Bildanalysesysteme zu entwickeln.

Meta stellt die Sapiens-Modelle der Forschungsgemeinschaft auf GitHub zur Verfügung.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.