Metas AITemplate kann Code des KI-Frameworks PyTorch bis zu zwölfmal schneller ausführen. Unter anderem profitieren Bild-KI-Systeme wie Stable Diffusion deutlich.

Metas AITemplate (AIT) ist ein einheitliches Inferenzsystem mit separaten Beschleunigungs-Backends für AMD- und Nvidia-GPUs. Es kann leistungsfähige Inferenzen auf der Hardware beider GPU-Anbieter durchführen - ohne die sonst bei einem Anbieterwechsel notwendige komplett neue Implementierung des KI-Modells.

Meta stellt AITemplate als Open-Source zur Verfügung und verspricht eine annähernd Hardware-native Tensor-Core (Nvidia) und Matrix-Core (AMD) Leistung für eine Vielzahl verbreiteter KI-Modelle wie CNNs, Transformer und Diffusion-Modelle.

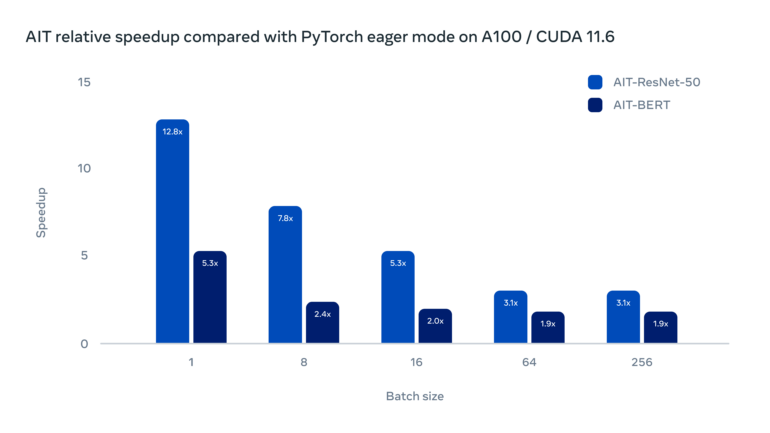

AITemplate ist laut Meta bis zu 12-mal schneller

AITemplate wandelt als Python-Framework KI-Modelle in leistungsstarken C++-GPU-Template-Code um und beschleunigt so die Inferenz. Laut Meta lassen sich mit AITemplate KI-Inferenzen im Vergleich mit dem Eager-Modus in PyTorch um bis zu 12-fach auf Nvidia-GPUs und bis zu 4-fach auf AMD-GPUs beschleunigen. Im Eager-Modus werden API-Aufrufe erst ausgeführt, wenn sie aufgerufen werden. PyTorch ist standardmäßig auf den "Eager Execution Mode" eingestellt.

Das Framework bietet laut Meta zahlreiche Leistungsinnovationen, darunter fortschrittliche Kernel-Fusion, eine Optimierungsmethode, die mehrere Kernel zu einem einzigen Kernel zusammenfasst, um sie effizienter auszuführen, sowie fortschrittliche Optimierungen für Transformer-Blöcke.

Metas Open-Source-Framework kann Stable Diffusion beschleunigen

Meta liefert mit AITemplate zudem häufig genutzte Modelle, die sofort einsatzbereit sind, darunter Vision Transformer, BERT, Stable Diffusion, ResNet und MaskRCNN. Das generative KI-System Stable Diffusion (SD) läuft etwa 2,4-mal schneller mit AIT auf einer Nvidia-GPU und kann so in einem Test auf einer RTX 3080 auch mit hohen SD-Einstellungen einen Out-of-Memory-Fehler umgehen.

In der Praxis kann Metas AIT so die Bildgenerierung und -bearbeitung mit Stable Diffusion beschleunigen oder etwa höhere Auflösungen ermöglichen. Die Implementation von AIT in verbreitete Lösungen wie Stable-Diffusion-WebUI ist wohl nur eine Frage der Zeit.

Laut Meta ist die Veröffentlichung von AITemplate zudem erst der Beginn einer langen Reihe von geplanten Releases auf dem Weg zum Aufbau einer leistungsstarken KI-Inferenzengine. Weitere Optimierungen sowie die Ausweitung auf andere Hardware-Systeme wie Apple-GPUs der M-Serie und CPUs anderer Technologieanbieter sind geplant.

Metas AITemplate gibt es auf GitHub.