Mit CICERO stellt Meta ein neues KI-System vor, das in natürlicher Sprache mit Menschen verhandeln, sie von Strategien überzeugen und mit ihnen kooperieren kann. Als Testumgebung diente das Strategie-Brettspiel "Diplomacy".

Laut Meta ist CICERO die erste Sprach-KI, die im Brettspiel "Diplomacy" auf menschlichem Niveau mitspielen kann. In Diplomacy verhandeln die Spielenden die europäischen Machtverhältnisse vor dem ersten Weltkrieg aus.

Als Vertreter von Österreich-Ungarn, England, Frankreich, Deutschland, Italien, Russland und der Türkei schließen sie strategische Bündnisse und brechen sie, wenn es zu ihrem Vorteil ist. Alle Spielzüge werden geplant und dann gleichzeitig ausgeführt. Geschickte Verhandlungsführung ist daher der Kern des Spiels.

Verhandelnde Künstliche Intelligenz

CICERO wurde für Diplomacy optimiert und das Spiel dient zugleich als Leistungsnachweis für die Sprachfähigkeiten des Modells: In 40 Online-Spielen über 72 Spielstunden bei "webDiplomacy.net" erreichte CICERO laut Meta mehr als das Doppelte der durchschnittlichen Punktzahl menschlicher Spieler:innen und gehörte zu den besten zehn Prozent.

CICERO ist laut Meta so konzipiert, dass die KI mit Menschen verhandeln und Bündnisse schließen kann. Die KI soll Überzeugungen und Absichten der Spieler:innen aus Gesprächen ableiten können - eine Aufgabe, die laut Metas Forschungsteam in der KI-Entwicklung "seit Jahrzehnten als fast unmöglich große Herausforderung" gesehen wird.

Laut Meta ist CICERO so erfolgreich in Diplomacy, dass menschliche Spielende bevorzugt Bündnisse mit der KI schließen. In den Online-Spielen begegnete CICERO 82 verschiedenen menschlichen Spieler:innen und ging laut Meta dabei als menschlicher Spieler durch. Nur ein Spieler soll im Chat nach einem Spiel einen Bot-Verdacht geäußert haben, der aber ohne Folgen blieb.

Im Paper beschreiben die Forschenden einen Fall, bei dem das Sprachmodell einen menschlichen Spieler von einem geplanten Zug abbringen und von einem neuen Zug überzeugen konnte, der für beide Seiten vorteilhaft war.

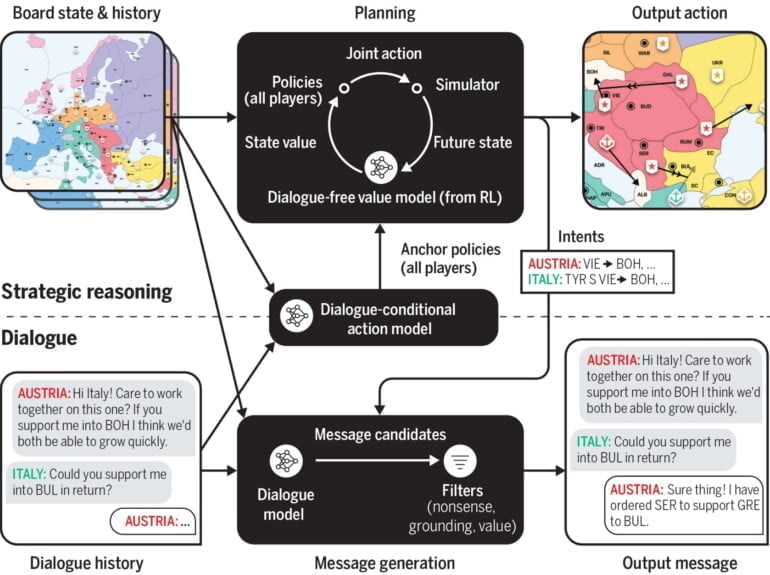

Erst planen, dann sprechen

Im Kern arbeitet CICERO mit zwei Systemen: Eines plant die Spielzüge für sich und Partner, das zweite setzt diese Spielzüge dann in natürliche Sprache um und erklärt sie den Spielenden, versucht sie, von der eigenen Strategie zu überzeugen.

Das Sprachmodell von CICERO basiert auf einem mit Internetdaten vortrainierten Transformer-Sprachmodell (BART) mit 2,7 Milliarden Parametern, das mit mehr als 40000 Diplomacy-Spielen feingetunt wurde. In den anonymisierten Spieldaten waren mehr als zwölf Millionen Nachrichten zwischen menschlichen Spielenden enthalten, die CICERO beim Training verarbeitete.

Laut Meta würde der für Spiele-KIs klassische überwachte Trainingsansatz mit menschlichen Spieldaten, bei dem das Verhalten menschlicher Spieler geklont würde, in Diplomacy zu einem leichtgläubigen Agenten führen, der einfach manipulierbar sei, etwa durch eine Formulierung wie: "Ich bin froh, dass wir uns darauf geeinigt haben, dass Sie Ihre Einheit aus Paris verlegen werden!" Zudem könne ein rein überwacht trainiertes Model falsche Korrelationen zwischen Dialogen und Handlungen lernen.

Die Forschenden verwenden daher den iterativen Planungsalgorithmus "piKL" (policy-regularized), der seine initiale Strategie anhand der Strategieprognosen für die anderen Spielenden optimiert, aber gleichzeitig versucht, nahe an seiner ursprünglichen Vorhersage zu bleiben. "Wir haben festgestellt, dass piKL das menschliche Spiel besser modelliert und zu besseren Strategien für den Agenten führt als das überwachte Lernen allein", schreibt Meta.

CICERO verwendet ein Modul für strategisches Denken, um auf intelligente Weise Absichten und Aktionen auszuwählen. Dieses Modul führt einen Planungsalgorithmus aus, der die Strategien aller anderen Spieler auf der Grundlage des Spielzustands und des bisherigen Dialogs vorhersagt und dabei sowohl die Stärke der verschiedenen Aktionen als auch ihre Wahrscheinlichkeit in menschlichen Spielen berücksichtigt, und wählt auf der Grundlage dieser Vorhersagen eine optimale Aktion für CICERO.

Die Planung stützt sich auf eine Wert- und Politikfunktion, die durch self-play-RL trainiert wurde und den Agenten für zu große Abweichungen vom menschlichen Verhalten bestraft, um eine menschenkompatible Politik beizubehalten. Während jeder Verhandlungsperiode werden die Absichten jedes Mal neu berechnet, wenn CICERO eine Nachricht sendet oder empfängt. Am Ende jeder Runde spielt CICERO seine zuletzt berechnete Absicht aus.

Aus dem Paper

Ein mögliches Einsatzszenario für Systeme im Stil von CICERO sind laut Meta fortschrittliche digitale Assistenten, die längere, zusammenhängende Gespräche mit Menschen führen und ihnen in diesen Gesprächen neues Wissen oder Fähigkeiten vermitteln. CICERO selbst kann nur Diplomacy spielen.

Das System mache zudem Fehler, sende etwa gelegentlich Nachrichten mit unlogischen Begründungen, widerspreche den eigenen Plänen oder sei "anderweitig strategisch unzureichend". Die Forschenden versuchten, diese Fehler mit einer Reihe an Filtern möglichst gut zu verdecken. Dass CICERO trotz der Fehler nicht als Bot enttarnt wurde, führen sie auf den Zeitdruck im Spiel zurück und darauf, dass Menschen gelegentlich ähnliche Fehler machten.

Beim bewussten Einsatz von Dialog-KI gäbe es trotzdem noch "viele offene Probleme" bei der Kooperation zwischen Mensch und Agenten, für die Diplomacy eine gute Testumgebung sei.

Meta veröffentlicht den Code für Cicero als Open Source bei Github. Tiefere Einblicke in Metas KI-Projekt gibt es auf der Cicero-Projektseite.