Metas MusicGen kann auf der Grundlage von Texteingaben neue kurze Musikstücke erzeugen, die sich optional an einer bereits vorhandenen Melodie orientieren können.

Wie viele Sprachmodelle basiert MusicGen auf einem Transformer-Modell. Ähnlich wie ein Sprachmodell die nächsten Zeichen in einem Satz vorhersagt, sagt MusicGen den nächsten Abschnitt in einem Musikstück voraus. Dazu zerlegen die Forscher die Audiodaten mithilfe von Metas Audio-Tokenizer EnCodec in kleinere Bestandteile. Als einstufiges Modell, das Tokens parallel verarbeitet, ist MusicGen schnell und effizient.

Für das Training verwendete das Team 20.000 Stunden lizenzierter Musik. Insbesondere stützte es sich auf einen internen Datensatz von 10.000 qualitativ hochwertigen Musikstücken sowie auf Musikdaten von Shutterstock und Pond5.

MusicGen kann Text und Musik als Prompts verarbeiten

Neben der Effizienz der Architektur und der Geschwindigkeit der Generierung zeichnet sich MusicGen dadurch aus, dass es sowohl Text- als auch Musik-Prompts verarbeiten kann. Der Text gibt den grundlegenden Stil vor, der sich dann an der Melodie der Audiodatei orientiert.

Kombiniert man etwa den Text-Prompt "ein leichter und fröhlicher EDM-Track mit synkopierten Drums, luftigen Pads und starken Emotionen, Tempo: 130 BPM" mit der Melodie von Bachs weltberühmter "Toccata und Fuge in d-Moll (BWV 565)", so entsteht das folgende Musikstück.

Video: Meta

Die Orientierung an der Melodie kann jedoch nicht exakt gesteuert werden, um etwa eine Melodie in vielen verschiedenen Stilen zu hören. Sie dient nur als grobe Vorgabe für die Generierung und findet sich nicht exakt in der Ausgabe wieder.

MusicGen liegt knapp vor Googles MusicLM

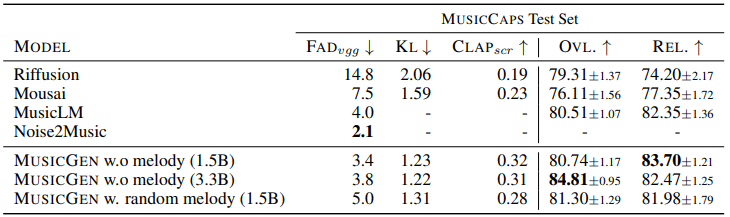

Die Autoren der Studie haben Tests mit drei Versionen ihres Modells in verschiedenen Größen durchgeführt: 300 Millionen (300M), 1,5 Milliarden (1,5B) und 3,3 Milliarden (3,3B) Parameter. Sie stellten dabei fest, dass die größeren Modelle qualitativ hochwertigere Audiodaten erzeugten, aber das Modell mit 1,5 Milliarden Parametern wurde von den Menschen am besten bewertet. Das Modell mit 3,3 Milliarden Parametern hingegen soll Texteingaben genauer umsetzen können.

Im Vergleich zu anderen Musikmodellen wie Riffusion, Mousai, MusicLM und Noise2Music schnitt MusicGen sowohl bei den objektiven als auch bei den subjektiven Metriken, die prüfen, wie gut die Musik zum Text passt und wie plausibel die Komposition ist, besser ab. Insgesamt liegen die Modelle knapp über dem Niveau von Googles MusicLM.

Meta hat den Code und die Modelle als Open Source bei Github veröffentlicht, die kommerzielle Nutzung ist gestattet. Eine Demo ist auf Huggingface verfügbar.