KI-Emotionserkennung: Microsoft schränkt Zugang zu "Azure Face" ein

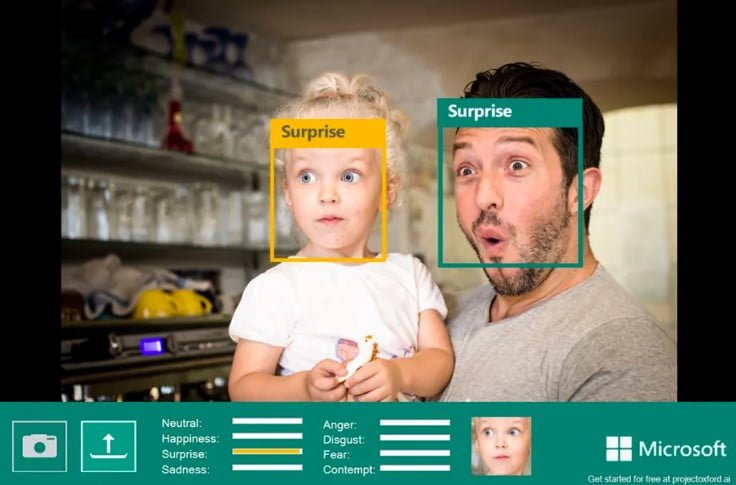

Gesichter kann Künstliche Intelligenz sicher erkennen - aber die Emotion darin nicht. Microsoft reagiert jetzt auf langjährige Kritik.

Eine 2019 veröffentlichte Studie zeigt, dass KI-gestützte Emotionserkennung nicht funktioniert. Das Hindernis ist weniger technischer Natur: Die Bildanalyse kann verlässlich erkennen, ob etwa die Mundwinkel nach oben oder nach unten zeigen.

Doch Maschinen können daraus nicht automatisch auf die Emotion schließen, wie ihr etwa in diesem Online-Test gut herausfinden könnte. Menschen gelingt das besser (und längst nicht immer), da sie den Gesichtsausdruck im Kontext einer Situation oder einer Kultur interpretieren.

Microsoft reagiert auf Kritik

Trotz dieser bekannten Unzulänglichkeiten bot Microsoft mit "Azure Face" als Bestandteil der "Azure Cognitive Services" neben Gesichts- auch eine Emotionserkennung an.

Im Zuge einer Aktualisierung der eigenen KI-Ethikrichtlinien schließt Microsoft jetzt den offenen API-Zugang zu dieser Emotionsanalyse aus. Das gilt auch für die Identifikation weiterer Merkmale wie Geschlecht, Alter, Lächeln, Gesichtsbehaarung, Haare und Make-up.

"Experten innerhalb und außerhalb des Unternehmens haben darauf hingewiesen, dass es keinen wissenschaftlichen Konsens über die Definition von ‚Emotionen‘ gibt, dass es schwierig ist, Schlussfolgerungen über verschiedene Anwendungsfälle, Regionen und Bevölkerungsgruppen hinweg zu verallgemeinern und dass der Datenschutz bei dieser Art von Funktion eine große Rolle spielt", schreibt Microsoft.

Die entsprechenden Funktionen sind für bestehende Kunden ab dem 30. Juni nicht mehr zugänglich, der Verkaufsstopp gilt ab sofort. Diese neuen Richtlinien gelten auch für mögliche alternative KI-Technologien, die emotionale Zustände von Menschen analysieren sollen. In der Vergangenheit stellten Forschende etwa ein System vor, das Emotion am Gang erkennen soll.

Emotionserkennung für Menschen mit Einschränkungen

Weiter anbieten will Microsoft maschinelle Emotionserkennung für die App Seeing AI. Die App scannt mit der Smartphone-Kamera die Umgebung und beschreibt sie für Menschen mit Sehbehinderung. Die Technologie könne in ausgewählten Nutzungsszenarien wertvoll sein, schreibt Microsoft.

Auch den Service "Custom Neural Voice" schränkt Microsoft ein, den man negativ konnotiert als "Audio Deepfake" bezeichnen könnte: Der Service kann Stimmen von Menschen kopieren und dann den Klang ihrer Stimme mit neuen Wörtern originalgetreu wiedergeben.

Ein solcher Stimmklon könnte etwa für einen Betrugsversuch verwendet werden. Dieses Gefahrenpotenzial sieht auch Microsoft, betont aber gleichzeitig den möglichen positiven Einsatz für Bildung, Barrierefreiheit und Unterhaltung.

Laut Microsoft ist der Zugang zu dem Service ab sofort für ausgewählte Kunden eingeschränkt und nur mehr möglich, wenn der Besitzer oder die Besitzerin der Originalstimme beim Einsatz des Services involviert ist.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.