Microsoft-Studie zeigt, wie fragil der Kampf gegen KI-Fälschungen wirklich ist

Ein neuer technischer Bericht von Microsoft bewertet systematisch, wie sich authentische von KI-generierten Medien unterscheiden lassen. Die Ergebnisse sind ernüchternd. Keine Methode ist für sich allein zuverlässig, und selbst kombinierte Ansätze haben Grenzen. Ob Microsoft die eigenen Vorschläge umsetzt, bleibt offen.

KI-gestützte Täuschung durchdringt das Netz in wachsendem Tempo. Das Weiße Haus teilte kürzlich ein manipuliertes Bild eines Demonstranten, russische Einflussoperationen verbreiten KI-generierte Videos, um Ukrainer von der Einberufung abzuhalten. In dieses Umfeld hinein hat Microsoft einen umfassenden technischen Bericht veröffentlicht, der systematisch untersucht, wie sich echte von künstlich erzeugten Medien unterscheiden lassen und wo die verfügbaren Methoden versagen.

Der Bericht mit dem Titel "Media Integrity and Authentication: Status, Directions, and Futures" entstand im Rahmen von Microsofts LASER-Programm für langfristige KI-Sicherheit unter der Leitung von Forschungschef Eric Horvitz. Ein fachübergreifendes Team aus den Bereichen KI, IT-Sicherheit, Sozialwissenschaften, Mensch-Computer-Interaktion, Politik, Betrieb und Governance hat dafür über mehrere Monate hinweg drei Kerntechnologien evaluiert. Im Zentrum stehen kryptographisch gesicherte Herkunftsmetadaten (sogenannte Provenance), unsichtbare Wasserzeichen und digitale Fingerabdrücke auf Basis von Soft-Hash-Verfahren.

Drei Methoden, keine davon narrensicher

Die drei Ansätze verfolgen unterschiedliche Ziele. Herkunftsmetadaten nach dem offenen C2PA-Standard heften kryptographisch signierte Informationen an eine Datei. Darin ist festgehalten, wer sie erstellt hat, mit welchem Werkzeug und welche Bearbeitungen vorgenommen wurden. Werden die Metadaten nachträglich manipuliert, bricht diese Signatur und die Fälschung wird erkennbar.

Unsichtbare Wasserzeichen betten für das menschliche Auge oder Ohr nicht wahrnehmbare Informationen direkt in den Medieninhalt ein. Sie überstehen dadurch viele Verarbeitungsschritte, etwa das Hochladen auf soziale Netzwerke. Digitale Fingerabdrücke wiederum berechnen eine Art mathematischen Kurzcode aus dem Inhalt selbst und speichern ihn in einer Datenbank. Wird ein Bild oder Video später erneut geprüft, lässt sich anhand des Codes feststellen, ob es mit einem bekannten Original übereinstimmt.

Laut dem Bericht hat jede Methode für sich genommen erhebliche Schwächen. Herkunftsmetadaten lassen sich leicht entfernen, etwa durch einen einfachen Screenshot. Wasserzeichen sind probabilistisch, liefern also keine hundertprozentig sicheren Ergebnisse und können sowohl fälschlich Alarm schlagen als auch Fälschungen übersehen. Digitale Fingerabdrücke leiden unter sogenannten Hash-Kollisionen, bei denen zwei unterschiedliche Dateien denselben Kurzcode erzeugen, sowie unter hohen Speicherkosten. Dazu kommt laut dem Bericht ein oft übersehener Punkt: Selbst validierte Herkunftsdaten beweisen nicht, dass ein Inhalt wahr ist. Sie belegen lediglich, dass er seit der Signierung nicht verändert wurde.

Laut einem Gespräch mit MIT Technology Review, ist das ein Punkt, den Horvitz auch gegenüber Gesetzgebern immer wieder betonen müsse. "Es geht nicht darum, Entscheidungen darüber zu treffen, was wahr ist und was nicht", sagte Horvitz dem Magazin. "Es geht darum, Kennzeichnungen zu entwickeln, die den Leuten einfach sagen, woher etwas stammt."

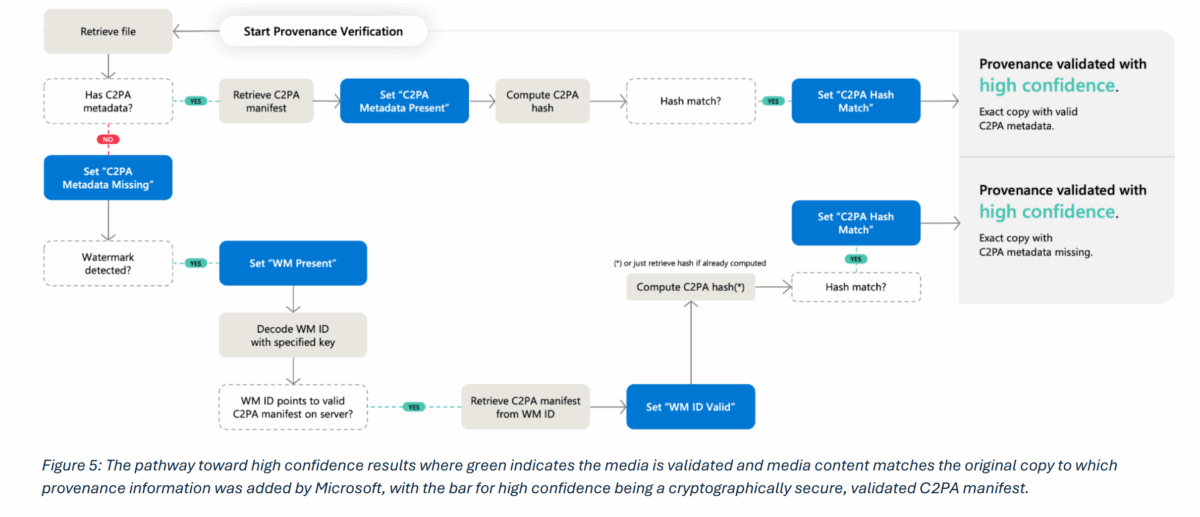

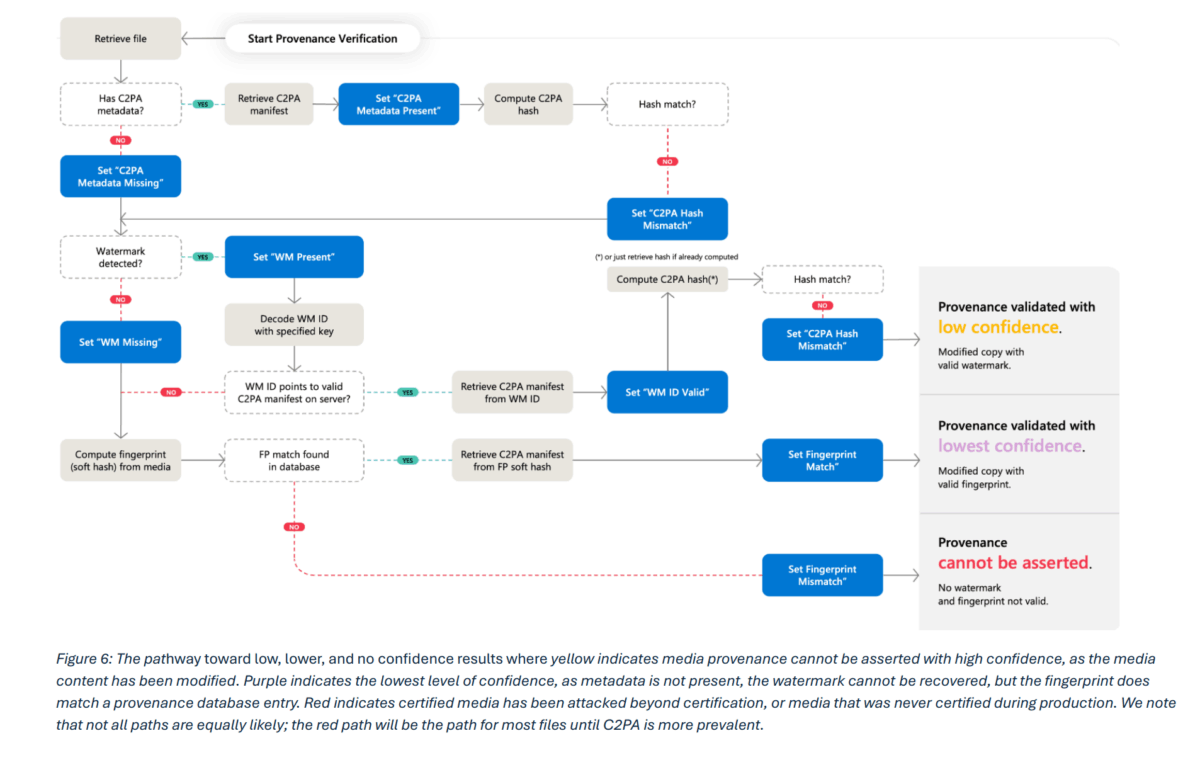

60 Kombinationen, nur 20 mit hohem Vertrauen

Das Forscherteam modellierte 60 verschiedene Kombinationen der drei Methoden und prüfte, wie sie unter realistischen Angriffsszenarien abschneiden. Das Ergebnis fällt ernüchternd aus: Nur 20 dieser Kombinationen führen zu dem, was der Bericht als "Hochvertrauens-Authentifizierung" bezeichnet. Dafür muss entweder ein validiertes C2PA-Manifest vorliegen, bei dem die gespeicherten Prüfsummen mit dem tatsächlichen Inhalt übereinstimmen, oder ein erkanntes Wasserzeichen muss auf ein solches Manifest in einem externen Speicher verweisen.

Die übrigen 40 Kombinationen liefern niedrigere Vertrauensniveaus oder gar keine belastbaren Aussagen. Microsoft empfiehlt deshalb, öffentliche Prüfwerkzeuge sollten ausschließlich Hochvertrauens-Ergebnisse anzeigen. Weniger verlässliche Signale, etwa mögliche Treffer beim digitalen Fingerabdruck, sollten nur forensischen Fachleuten zugänglich sein. Das Argument: Unzuverlässige Ergebnisse könnten mehr Verwirrung stiften als Klarheit schaffen.

Wenn Angriffe Realität und Fälschung vertauschen

Besonders ausführlich behandelt der Bericht sogenannte Umkehr-Angriffe, also Manipulationen, die Echtheitssignale gezielt auf den Kopf stellen. In einem Szenario nimmt ein Angreifer ein authentisches Foto und bearbeitet es minimal mit einem KI-Werkzeug. Das Bild wird korrekt als "KI-modifiziert" signiert, doch eine Plattform mit unzureichender Anzeige könnte es schlicht als "KI-generiert" kennzeichnen, ohne den Umfang der Änderung zu zeigen. Das echte Bild würde so diskreditiert.

In einem anderen Szenario erzeugt ein Angreifer ein KI-Bild, entfernt Wasserzeichen und Manifest und fügt ein gefälschtes Kamera-Manifest hinzu. Ohne zuverlässige Listen vertrauenswürdiger Unterzeichner würde ein Prüfwerkzeug das synthetische Bild als authentisch anzeigen.

Microsoft empfiehlt als Gegenmaßnahme, dass Plattformen bei der Anzeige von Herkunftsinformationen stets den sogenannten Bearbeitungsbereich mitliefern, also zeigen, wo genau Änderungen stattgefunden haben. Auch Vorschaubilder der Originalmedien sollten angezeigt werden. Verbreitungsplattformen wie soziale Netzwerke sollten vollständige Manifest-Details erhalten, damit Nutzer sie über Verifizierungsdienste prüfen können.

Lokale Geräte sind das schwache Glied

Wirklich vertrauenswürdige Ergebnisse sind laut dem Bericht nur möglich, wenn Medienerzeugung und Signierung in einer sicheren Cloud-Umgebung stattfinden. Lokale Geräte, insbesondere herkömmliche Computer, bieten dafür nicht genug Schutz. Administratoren können Programme modifizieren und kryptographische Schlüssel missbrauchen. Smartphones mit Android und iOS schneiden etwas besser ab, da sie manipulierte von unveränderten Betriebssystemen unterscheiden können.

Für Kameras sieht die Lage gemischt aus. Neuere Modelle wie das Google Pixel 10, die Nikon Z6 III oder die Canon EOS R1 implementieren bereits den C2PA-Standard. Einfache Kompaktkameras verfügen hingegen meist nicht über gesicherte Chips. Microsoft empfiehlt den Einsatz sogenannter Sicherheitsenklaven in der Gerätehardware. Dabei handelt es sich um abgeschottete Bereiche im Prozessor, die sensible Operationen wie das Signieren von Inhalten vor dem Zugriff anderer Programme schützen. Zusätzlich sollte die C2PA-Spezifikation ab Version 2.3 genutzt werden, die erstmals Sicherheitsstufen für Signierzertifikate einführte.

KI-Detektoren als letztes Mittel mit grundsätzlichem Paradox

KI-basierte Erkennungswerkzeuge für Deepfakes spielen im Bericht eine ergänzende, aber ausdrücklich nachgeordnete Rolle. Unternehmenseigene Detektoren könnten in Szenarien ohne gezielte Gegenangriffe eine Genauigkeit von etwa 95 Prozent erreichen, so Microsofts Team für KI und Gemeinwohl. Frei verfügbare Erkennungswerkzeuge lagen in Untersuchungen dagegen unter 70 Prozent Treffsicherheit.

Der Bericht benennt aber auch ein grundsätzliches Paradox: Je besser ein Detektor arbeitet, desto größer ist das Vertrauen in seine Ergebnisse. Doch genau die Fehler der besten Detektoren, insbesondere übersehene Fälschungen, könnten dann den größten Schaden anrichten, weil ihnen am meisten vertraut wird.

Zudem befinden sich Detektoren in einem permanenten Wettrüsten mit Angreifern. Forschung hat gezeigt, dass ausgefeilte Attacken die Erkennungsrate mancher Detektoren auf unter 30 Prozent drücken können.

Gesetze fordern, was technisch noch nicht möglich ist

Der Bericht analysiert auch die Gesetzgebung in mehreren Ländern. Kaliforniens Transparenzgesetz für KI, das ab August 2026 in Kraft tritt, verlangt von KI-Anbietern, dass sie sowohl sichtbare als auch versteckte Offenlegungen in KI-generierte Inhalte einbetten, die "permanent oder außerordentlich schwer zu entfernen" sein sollen, soweit technisch machbar. Der EU AI Act sieht vor, dass synthetische Inhalte maschinenlesbar als KI-generiert markiert werden müssen. Bei Verstößen drohen Strafen von bis zu drei Prozent des weltweiten Umsatzes oder 15 Millionen Euro, je nachdem, welcher Betrag höher ist.. Ähnliche Regelungen existieren oder entstehen in China, Indien und Südkorea.

Microsoft warnt ausdrücklich davor, dass einige dieser Anforderungen technisch nicht erfüllbar sind. Sichtbare Wasserzeichen lassen sich von Laien entfernen. Unsichtbare Wasserzeichen nach dem besten Stand der Technik können von versierten Angreifern beseitigt werden. Jüngste Forschung zeige, dass diffusionsbasierte Bildbearbeitung, also die Veränderung von Bildern durch generative KI-Modelle, selbst robuste Wasserzeichen brechen könne. Übereilte Einführung schlecht funktionierender Systeme könnte das Vertrauen der Öffentlichkeit in Authentifizierungsmethoden insgesamt untergraben.

Der Bericht fordert daher, dass politische Erwartungen schrittweise angehoben werden sollten, im Gleichschritt mit Fortschritten bei Forschung und technischen Methoden, die in der Breite einsetzbar sind.

Microsoft will die Regeln mitschreiben, aber nicht verbindlich umsetzen

Gegenüber MIT Technology Review bezeichnete Horvitz die Arbeit als eine Art Empfehlung zur "Selbstregulierung", räumte aber ein, dass sie auch Microsofts Ruf als vertrauenswürdiger Anbieter stärken solle. "Wir versuchen auch, ein ausgewählter, gewünschter Anbieter für Menschen zu sein, die wissen wollen, was in der Welt passiert", sagte er dem Magazin.

Auf die Frage von MIT Technology Review, ob Microsoft die eigenen Empfehlungen auf seinen Plattformen umsetzen werde, wich Horvitz jedoch aus. Produktgruppen und Führungskräfte seien in die Studie einbezogen worden, und die Entwicklungsteams würden "Maßnahmen auf Basis der Ergebnisse ergreifen", hieß es in einer schriftlichen Stellungnahme.

Microsoft sitzt im Zentrum eines weitläufigen KI-Ökosystems. Der Konzern betreibt Copilot, die Cloud-Plattform Azure, über die Kunden auf OpenAI- und andere große KI-Modelle zugreifen, das berufliche Netzwerk LinkedIn und hält eine milliardenschwere Beteiligung an OpenAI. Eine verbindliche Zusage zur Umsetzung der eigenen Blaupause blieb laut MIT Technology Review aus.

Hany Farid, Professor für digitale Forensik an der UC Berkeley, der nicht an der Studie beteiligt war, sagte gegenüber MIT Technology Review, dass die Übernahme des Konzepts durch die Industrie es "deutlich schwieriger" machen würde, die Öffentlichkeit mit manipulierten Inhalten zu täuschen. Versierte Einzelpersonen oder staatliche Akteure könnten die Werkzeuge umgehen, aber ein erheblicher Teil irreführender Inhalte ließe sich eliminieren. "Ich glaube nicht, dass es das Problem löst, aber es nimmt ein schönes großes Stück davon weg", so Farid.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.