Short

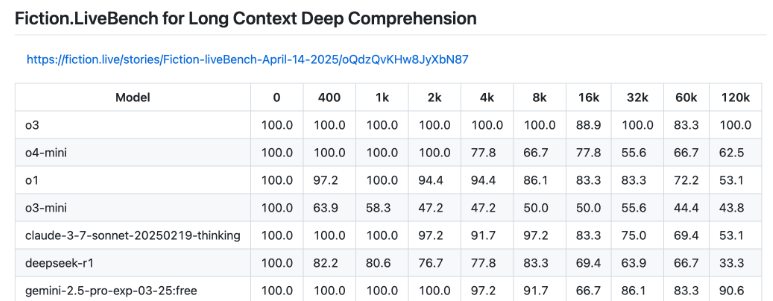

Der wohl interessanteste o3-Benchmark ist die Ausperformance bei der Verarbeitung langer Kontexte. Bei 128K Token (etwa 96.000 Wörter) von maximal 200K Token erreicht o3 im Fiction.live-Benchmark als erstes Modell 100 Prozent – das ist vielversprechend für KI-Anwendungen mit sehr langen Texten. Nur Googles Gemini 2.5 Pro kann mithalten und kommt auf 90,6 Prozent. o3-mini und o4-mini fallen deutlich ab. Fiction.LiveBench prüft, wie gut KI-Modelle komplexe Geschichten und Zusammenhänge bei sehr langen Texten komplett verstehen und korrekt wiedergeben. Ein Negativbeispiel ist Metas Llama 4, das zwar mit einem Kontextfenster von bis zu zehn Millionen Token wirbt, das aber über eine einfache Wortsuche hinaus kaum brauchbar ist.