Mistral stellt neues Code-Modell vor, das effizienter und kompetenter als Llama 3 sein soll

Das französische KI-Unternehmen Mistral hat mit Codestral ein neues Code-Modell auf den Markt gebracht, das sich durch hohe Codeleistung bei geringerem Rechenaufwand auszeichnen soll.

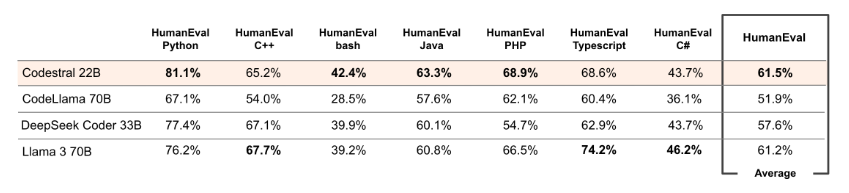

Laut Mistral beherrscht Codestral mehr als 80 Programmiersprachen, darunter die gängigsten wie Python, Java, C, C++, JavaScript und Bash, aber auch speziellere wie Swift und Fortran.

Es soll Entwickler in einer Vielzahl von Programmierumgebungen und Projekten unterstützen. Die Funktionen umfassen die Vervollständigung von Code, das Schreiben von Tests und die Vervollständigung von unvollständigem Code durch einen Fill-in-the-Middle-Mechanismus.

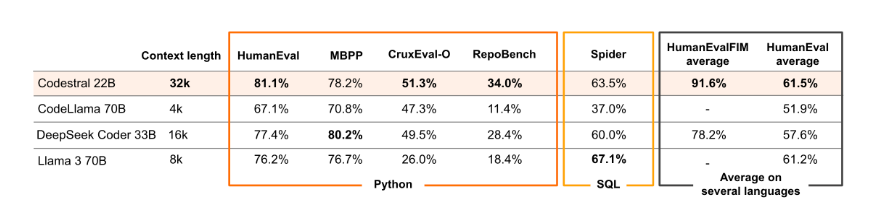

Als 22 Milliarden Parameter umfassendes Modell setzt Codestral im Vergleich zu früheren Modellen einen neuen Standard für das Verhältnis von Leistung und Latenz bei der Codegenerierung. Mit seinem größeren Kontextfenster von 32.000 Token übertrifft Codestral alle anderen Modelle in der RepoBench, einem Benchmark für längeren Code.

Mistral hat die Leistung von Codestral in verschiedenen Benchmarks für Python, SQL und andere Sprachen mit konkurrierenden Modellen mit höheren Hardwareanforderungen verglichen. Codestral schnitt durchweg besser ab, z.B. bei der Vervollständigung von Code-Repositories über große Distanzen oder bei der Vorhersage von Python-Ausgaben.

Codestral ist als Open-Weight-Modell unter der neuen Mistral AI Non-Production License lizenziert, die die Nutzung zu Forschungs- und Testzwecken erlaubt. Es kann von HuggingFace heruntergeladen werden.

Mistral bietet zudem zwei API-Endpunkte für Codestral: codestral.mistral.ai für die Integration in IDEs, wo Entwickler ihre eigenen API-Schlüssel mitbringen, und api.mistral.ai für Forschung, Batch-Abfragen oder Anwendungsentwicklung, wo die Ergebnisse direkt den Nutzern präsentiert werden. Ersteres ist acht Wochen lang kostenlos nutzbar, letzteres wird pro Token abgerechnet.

Erste Rückmeldungen von Entwicklern und Forschern bescheinigen Codestral eine gute Performance. Trotz seiner relativ kompakten Größe liefere es Ergebnisse, die mit größeren Modellen vergleichbar sind.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.