Mistral veröffentlicht neue leistungsstarke Open-Source-Modelle

Kurz & Knapp

- Mistral AI veröffentlicht mit Mistral 3 eine neue Reihe multimodaler Open-Source-Modelle, angeführt vom "Mistral Large 3", das auf einer Mixture-of-Experts-Architektur basiert.

- Das Flaggschiff steht unter der Apache-2.0-Lizenz, verarbeitet neben Text auch Bilder und konkurriert in Benchmarks direkt mit offenen Modellen von Qwen und Deepseek.

- Für lokale Anwendungen ergänzen drei effiziente "Ministral"-Modelle mit 3 bis 14 Milliarden Parametern das Angebot, die ebenfalls über Bildverständnis verfügen.

Das französische Start-up Mistral AI stellt mit Mistral 3 eine neue Generation offener, multimodaler und mehrsprachiger KI-Modelle vor. Neben kompakten Varianten für Edge-Anwendungen gibt es ein großes Mixture-of-Experts-Modell.

Laut Mistral AI umfasst die neue Reihe mehrere Modellgrößen: drei "Ministral"-Modelle mit 3, 8 und 14 Milliarden Parametern sowie das Flaggschiff "Mistral Large 3". Letzteres basiert auf einer sparsamen Mixture‑of‑Experts‑Architektur und wurde mit rund 3.000 Nvidia‑H200‑GPUs trainiert. Mistral gibt für das Modell 41 Milliarden aktive und 675 Milliarden Gesamtparameter an.

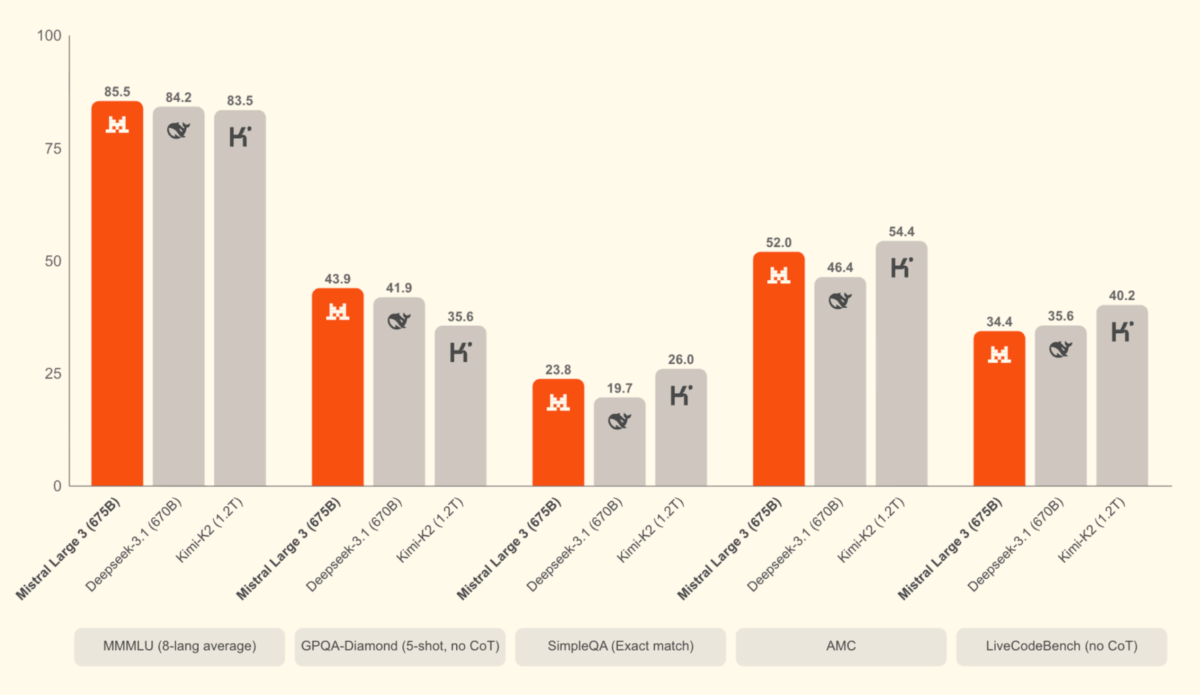

Mistral Large 3 ist vollständig quelloffen und unter der Apache‑2.0‑Lizenz verfügbar. Es soll bei allgemeinen Sprachaufgaben mit führenden offenen Modellen gleichziehen und zugleich Bildinhalte verstehen. Laut Unternehmensangaben liegt es auf dem LMArena-Leaderboard auf Rang zwei in der Kategorie der Open-Source-Modelle ohne Reasoning und auf Rang sechs in der Kategorie der OSS-Reasoning-Modelle. In den veröffentlichten Benchmarks liegt das Modell auf Augenhöhe mit den offenen Angeboten anderer Anbieter wie Qwen oder Deepseek. Allerdings hat Deepseek erst gestern mit V3.2 ein neues Modell veröffentlicht, das in einigen Benchmarks noch einmal deutlich gegenüber dem Vorgänger zugelegt hat.

Edge‑Modelle mit Priorität auf Effizienz

Die kleineren Varianten, zusammengefasst als "Ministral 3", richten sich an lokale oder Edge‑Anwendungen. Alle drei Modellgrößen – 3B, 8B und 14B – liegen in einer Basis‑, "Instruct"‑ und "Reasoning"‑Variante vor, jeweils mit Bildverständnis. Auch sie stehen unter der Apache‑2.0‑Lizenz.

Mistral zufolge erreichen die Instruktionsmodelle die Leistung vergleichbarer Open‑Source‑Modelle, erzeugen dabei jedoch deutlich weniger Tokens. Die Reasoning‑Varianten sind für gründlichere Schlussfolgerungen ausgelegt. Das 14B‑Modell erreichte laut Mistral 85 Prozent im AIME‑25‑Benchmark.

Die Modelle sind über Mistral AI Studio, Hugging Face und mehrere Cloud‑Anbieter wie Amazon Bedrock, Azure Foundry, IBM WatsonX und Together AI verfügbar. Später sollen auch Nvidia NIM und AWS SageMaker folgen. Mit Nvidia habe man eng für das neue Modell zusammengearbeitet, so das Unternehmen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren