Mit Metas HOT3D könnten Roboter ihr Handwerk direkt von menschlichen Experten lernen

Meta hat einen neuen Benchmark-Datensatz namens HOT3D veröffentlicht, der die KI-Forschung im Bereich der 3D-Hand-Objekt-Interaktionen vorantreiben soll. Der Datensatz enthält über eine Million Frames aus mehreren Perspektiven.

Der HOT3D-Datensatz von Meta zielt darauf ab, das Verständnis dafür zu verbessern, wie Menschen ihre Hände zur Manipulation von Objekten einsetzen. Laut Meta ist dies nach wie vor eine zentrale Herausforderung für die Computervision-Forschung.

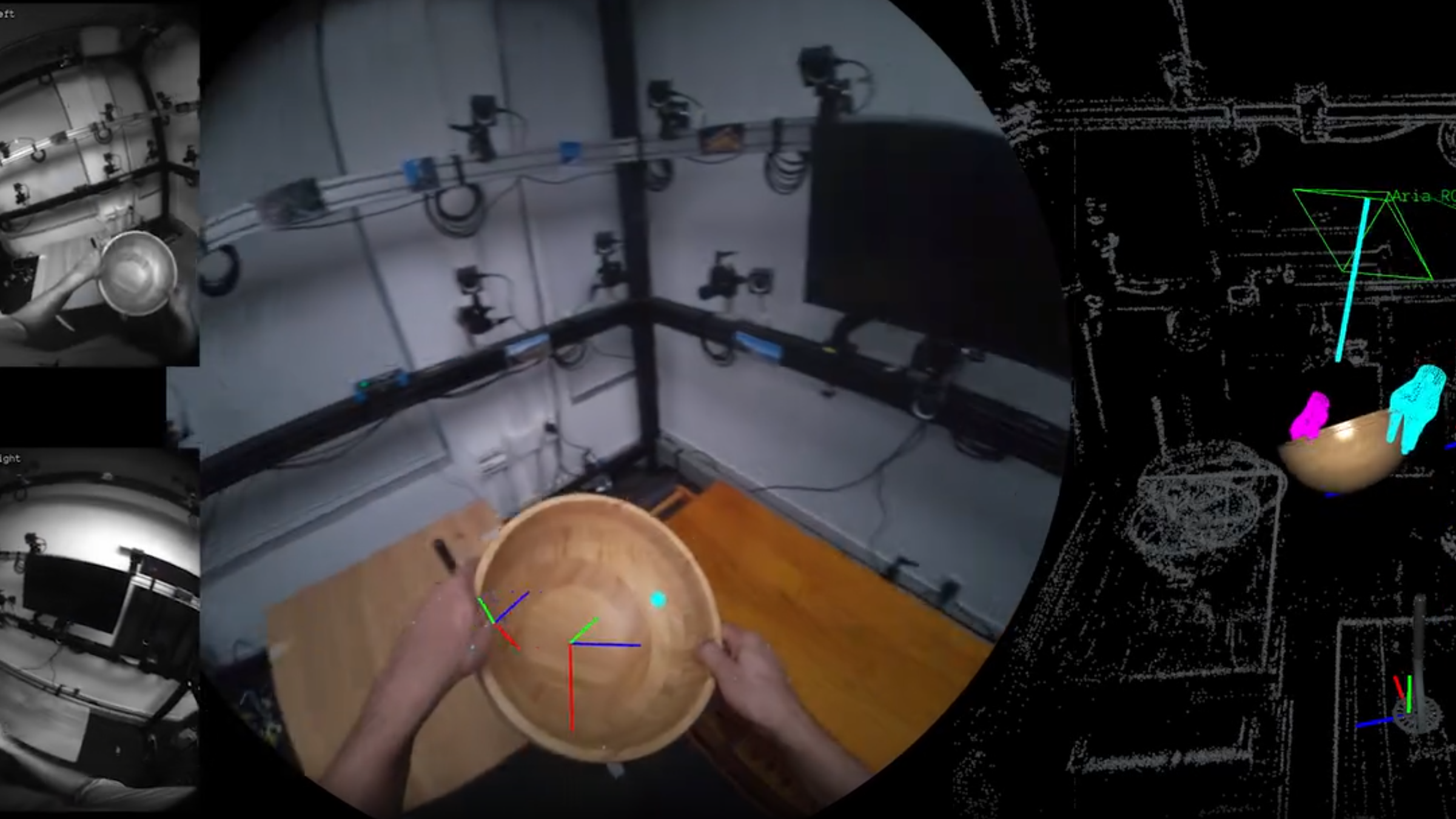

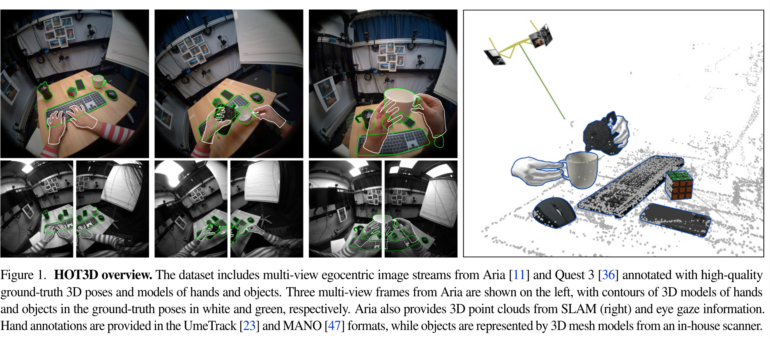

Der Datensatz umfasst über 800 Minuten an egozentrischen Videoaufnahmen und enthält synchronisierte Videoaufnahmen aus mehreren Perspektiven sowie hochwertige 3D-Pose-Annotationen von Händen und Objekten. Zudem sind 3D-Objektmodelle mit PBR-Materialien, 2D-Bounding-Boxes, Blicksignale und 3D-Szenen-Punktwolken aus SLAM enthalten.

Video: Meta

Die Aufnahmen zeigen 19 Testpersonen bei der Interaktion mit 33 verschiedenen Alltagsgegenständen. Neben einfachen Szenarien, in denen Objekte aufgehoben, betrachtet und abgelegt werden, enthält der Datensatz auch typische Handlungen in Küchen-, Büro- und Wohnzimmerumgebungen.

Für die Datenerfassung wurden zwei Geräte von Meta eingesetzt: Die Forschungsbrille Project Aria und das VR-Headset Quest 3. Project Aria liefert pro Aufnahme ein RGB-Bild und zwei monochrome Bilder, während Quest 3 zwei monochrome Bilder bereitstellt.

HOT3D könnte bessere Roboter und XR-Interaktionen ermöglichen

Ein Kernelement des Datensatzes sind die präzisen 3D-Annotationen für Hände und Objekte. Diese wurden mithilfe eines markerbasierten Motion-Capture-Systems erfasst. Die Handposen werden im UmeTrack- und MANO-Format bereitgestellt, während die Objektposen als 3D-Transformationen dargestellt sind.

Zusätzlich enthält der Datensatz hochwertige 3D-Modelle der 33 verwendeten Objekte. Diese wurden mit einem hausinternen 3D-Scanner von Meta erstellt und verfügen über detaillierte Geometrie sowie PBR-Materialien, die eine fotorealistische Darstellung ermöglichen.

Meta sieht in dem Datensatz Potenzial für verschiedene Anwendungen: "Der HOT3D-Datensatz und Benchmark wird neue Möglichkeiten in diesem Forschungsbereich eröffnen, wie die Übertragung manueller Fähigkeiten von Experten auf weniger erfahrene Benutzer oder Roboter, die Unterstützung eines KI-Assistenten beim Verständnis der Handlungen des Benutzers oder die Ermöglichung neuer Eingabemöglichkeiten für AR/VR-Benutzer, wie z.B. die Verwandlung jeder physischen Oberfläche in eine virtuelle Tastatur oder jeden Bleistift in einen multifunktionalen Zauberstab."

Der Datensatz ist auf Metas HOT3D-Projektseite verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.