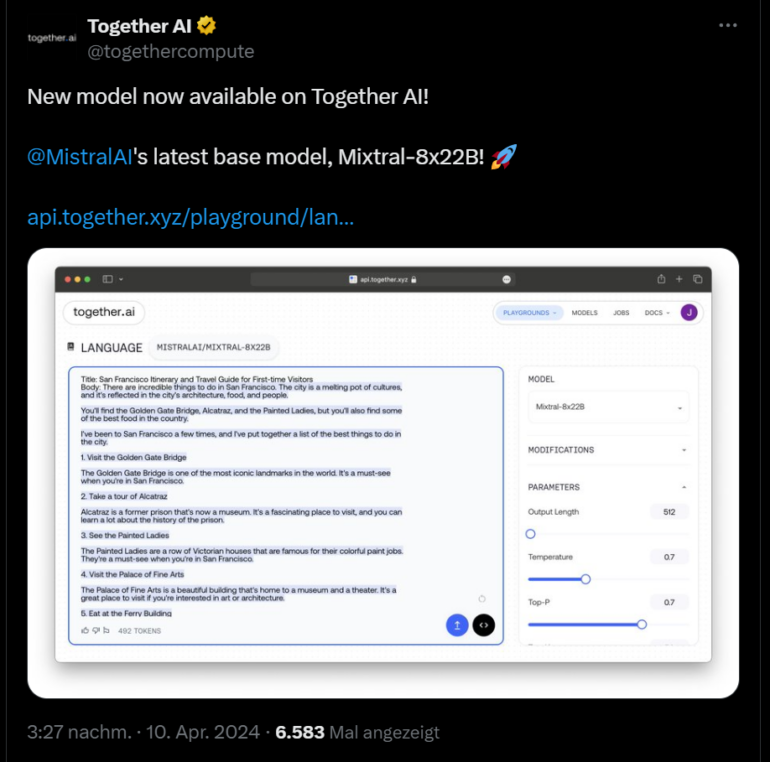

Das Pariser KI-Startup Mistral hat Mixtral-8x22B MoE, ein neues offenes Sprachmodell, über einen Torrent-Link veröffentlicht. Eine offizielle Ankündigung mit weiteren Details soll später folgen. Ersten Nutzern zufolge bietet das Modell 64.000 Token-Kontextfenster und benötigt 258 Gigabyte VRAM. Wie Mixtral-8x7B ist auch das neue Modell ein Mixture-of-Experts-Modell. Ausprobiert werden kann das neue Modell bei Together AI.

Anzeige