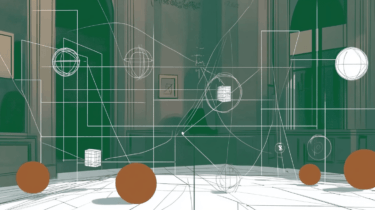

MVDream verwendet Stable Diffusion und NeRFs, um einige der bisher besten 3D-Renderings aus Text-Prompts zu erzeugen.

Forschende von ByteDance stellen MVDream (Multi-view Diffusion for 3D Generation) vor, ein Diffusionsmodell, das qualitativ hochwertige 3D-Renderings aus Textprompts erzeugen kann. Ähnliche Modelle existieren bereits, MVDream erreicht jedoch eine vergleichsweise hohe Qualität und vermeidet zwei Kernprobleme alternativer Ansätze.

Diese haben oft mit dem Janus-Problem und dem "Content Drifting" zu kämpfen. So hat zum Beispiel ein generierter Baby-Yoda mehrere Gesichter oder ein generierter Teller mit Waffeln verändert je nach Blickwinkel die Anzahl und Anordnung der Waffeln.

Um dieses Problem zu lösen, trainiert ByteDance ein Diffusionsmodell wie Stable Diffusion nicht nur wie üblich mit Prompt-Bildpaaren, sondern auch mit mehreren Ansichten von 3D-Objekten. Dazu rendern die Forschenden einen umfangreichen Datensatz von 3D-Modellen aus verschiedenen Perspektiven und Kamerawinkeln.

Indem das Modell kohärente Ansichten aus verschiedenen Blickwinkeln sieht, lernt es, kohärente 3D-Formen anstelle von unzusammenhängenden 2D-Bildern zu erzeugen, so das Team.

Video: ByteDance

MVDream soll mit SDXL noch besser werden

Konkret generiert das Modell aus einem Textprompt Bilder eines Objekts aus verschiedenen Perspektiven, mit denen das Team dann ein NeRF als 3D-Repräsentation des Objekts trainiert.

Im direkten Vergleich mit alternativen Ansätzen zeigt MVDream einen deutlichen Qualitätssprung und vermeidet häufige Artefakte wie das Janus-Problem oder Content Drifting.

Video: ByteDance

In einem Experiment zeigt das Team außerdem, dass MVDream über Dreambooth auch neue Konzepte lernen und dann beispielsweise 3D-Ansichten eines bestimmten Hundes generieren kann.

Video: ByteDance

Als Einschränkungen nennt das Team die noch geringe Auflösung von 256 x 256 Pixeln und die teilweise eingeschränkte Generalisierbarkeit. ByteDance erwartet jedoch, dass beide Probleme in Zukunft durch den Einsatz größerer Diffusionsmodelle wie SDXL reduziert oder gelöst werden können. Um die Qualität und den Stil der 3D-Renderings deutlich zu verbessern, ist jedoch wahrscheinlich ein umfangreiches Training mit einem neuen Datensatz erforderlich, so das Team.

Mehr Informationen und Beispiele gibt es im MVDreams-GitHub.