Neue Cache-Methode lässt Sprachmodelle direkt über interne Speicher kommunizieren

Ein Forschungsteam aus China hat eine neue Methode entwickelt, mit der Large Language Models direkt über ihre internen Speicherstrukturen kommunizieren können. Das Cache-to-Cache-Verfahren soll die Zusammenarbeit zwischen KI-Modellen beschleunigen und verbessern.

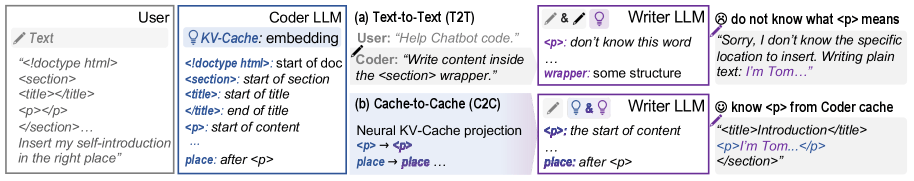

Wenn verschiedene Large Language Models zusammenarbeiten, müssen sie sich bislang ausschließlich über generierten Text austauschen. Diese Kommunikation bringt laut einem neuen Forschungspapier verschiedener chinesischer Universitäten drei entscheidende Nachteile mit sich: Text fungiert als Informationsengpass, natürliche Sprache ist mehrdeutig, und die Token-für-Token-Generierung verursacht spürbare Verzögerungen.

Ein praktisches Beispiel verdeutlicht das Problem: Wenn ein Programmier-LLM einem Schreiber-LLM über Text mitteilt "Schreibe Inhalte in den section-Wrapper", versteht der Schreiber möglicherweise nicht, was "<p>" als HTML-Tag bedeutet, und platziert den Text an der falschen Stelle.

KV-Cache als reichhaltigere Alternative zu Text

Als Alternative schlagen die Wissenschaftler:innen Cache-to-Cache (C2C) vor, ein Verfahren für direkte semantische Kommunikation zwischen LLMs. Statt Text nutzt C2C den sogenannten KV-Cache als Übertragungsmedium.

Der KV-Cache ist eine interne Speicherstruktur von LLMs, die während der Textverarbeitung entsteht. Er speichert mathematische Repräsentationen bereits verarbeiteter Wörter und enthält deutlich mehr semantische Informationen als der finale Textoutput. Während Text nur das Endergebnis der Verarbeitung darstellt, bewahrt der KV-Cache die reichhaltigen Zwischenschritte der Sprachverarbeitung.

Bei der Cache-to-Cache-Kommunikation würde das Programmier-LLM sein internes Verständnis der HTML-Struktur direkt übertragen, sodass der Schreiber den Text automatisch an der richtigen Stelle platzieren kann.

Fusion zweier Speicherstrukturen

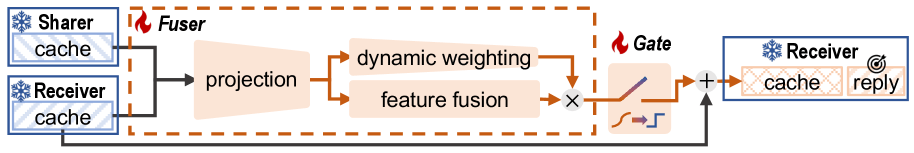

Das C2C-System projiziert den KV-Cache eines Quellmodells in den Speicherraum eines Zielmodells und verschmilzt beide über ein neuronales Netzwerk namens Cache Fuser. Dieser Fuser besteht aus drei Komponenten: einem Projektionsmodul, das die verschiedenen Cache-Formate angleicht, einer dynamischen Gewichtung, die entscheidet, wie stark die übertragenen Informationen berücksichtigt werden, und einem lernbaren Gate, das auswählt, welche Ebenen des Modells von der Übertragung profitieren.

Die Herausforderung besteht darin, dass verschiedene LLMs ihre internen Repräsentationen unterschiedlich organisieren. Die Forschenden lösen dies durch eine schrittweise Anpassung. Zunächst werden die verschiedenen Wortzerlegungen der Modelle aufeinander abgestimmt, dann die verschiedenen Verarbeitungsebenen miteinander verknüpft.

Oracle-Experimente der Forschenden zeigen, dass die Anreicherung der KV-Cache-Semantik die Antwortqualität verbessern kann, ohne die Cache-Größe zu erhöhen. Zudem lassen sich KV-Caches zwischen verschiedenen LLMs konvertieren, wobei unterschiedliche Modelle verschiedene semantische Interpretationen desselben Inputs codieren.

Deutliche Verbesserungen in Tests

In Experimenten auf vier Benchmarks erzielt C2C durchschnittlich 8,5 bis 10,5 Prozent höhere Genauigkeit als Einzelmodelle. Gegenüber der Text-zu-Text-Kommunikation erreicht das Verfahren etwa 3 bis 5 Prozent bessere Ergebnisse bei einer durchschnittlichen Verdopplung der Geschwindigkeit.

Die Forschenden testeten verschiedene Modellkombinationen, darunter Qwen2.5, Qwen3, Llama 3.2 und Gemma 3 mit unterschiedlichen Größen von 0,6 bis 14 Milliarden Parametern. Dabei zeigte sich, dass größere Quellmodelle mit reichhaltigerem Wissen zu stärkeren Verbesserungen führen.

Eine technische Analyse bestätigt, dass C2C tatsächlich den semantischen Informationsgehalt anreichert. Nach der Cache-Fusion stieg ein Maß für die Informationsdichte der gespeicherten Daten deutlich an, was auf erfolgreich übertragenes Wissen hinweist.

Nur Verbindungsmodul muss trainiert werden

Ein praktischer Vorteil des Ansatzes liegt im geringen Trainingsaufwand: Während des Lernprozesses bleiben sowohl das Quell- als auch das Zielmodell unverändert. Nur das C2C-Verbindungsmodul wird trainiert, um die Cache-Fusion zu optimieren. Dies reduziert den Rechenaufwand erheblich im Vergleich zum vollständigen Neutraining großer Modelle.

Das Verfahren soll sich laut den Wissenschaftlern auf verschiedene Bereiche ausweiten lassen: datenschutzbewusste Zusammenarbeit zwischen Cloud- und Edge-Geräten, Integration mit bestehenden Beschleunigungsmethoden und multimodale Anwendungen, die Sprach-, Bild- und Aktionsmodelle verbinden.

Die Forschenden stellen ihren Code auf GitHub zur Verfügung und sehen in Cache-to-Cache eine praktische Alternative zur textbasierten Kommunikation für skalierbare Multi-LLM-Systeme mit geringer Latenz.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.