Das Mistral AI Team veröffentlicht Mistral 7B, ein kleines großes Sprachmodell mit 7,3 Milliarden Parametern, das größere Llama-Modelle in Benchmarks übertrifft. Das Modell kann ohne Einschränkungen unter der Apache 2.0 Lizenz verwendet werden.

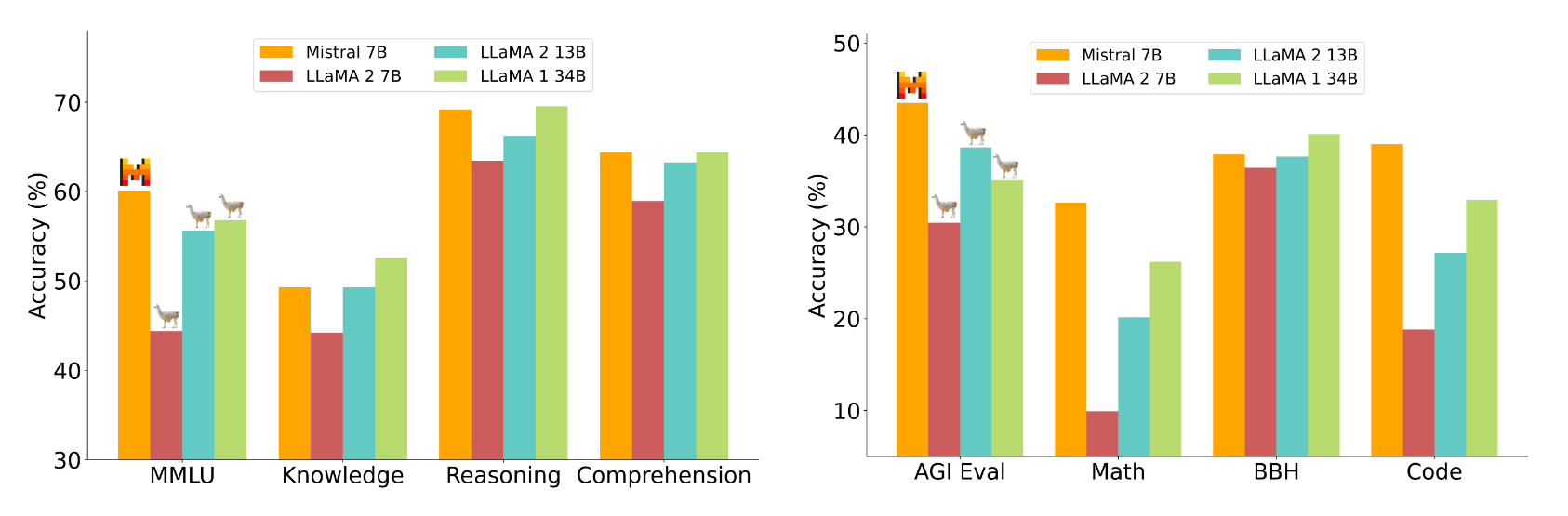

Mistral 7B übertrifft das größere Llama 2 13B in allen Benchmarks und Llama 1 34B in vielen. Außerdem nähert sich Mistral 7B der Programmierleistung von CodeLlama 7B an und erzielt weiterhin gute Ergebnisse bei Aufgaben in englischer Sprache.

Mistral 7B kann kostenlos heruntergeladen und überall mit einer Referenzimplementierung, in jeder Cloud (AWS/GCP/Azure) mit vLLM Inference Server und Skypilot oder über HuggingFace verwendet werden. Laut Mistral AI kann das Modell durch Feintuning leicht an neue Aufgaben wie Chat oder Instruktionen angepasst werden.

Mistral AI vergleicht Mistral 7B mit den Llama 2 Modellen 7B und 13B in zahlreichen Bereichen wie logisches Denken, Weltwissen, Leseverständnis, Mathematik und Code.

Laut Mistral AI ist Mistral 7B einem theoretischen Llama 2-Modell, das mehr als dreimal so groß ist, ebenbürtig, spart aber Speicher und erhöht den Datendurchsatz. Dass es bei Wissensfragen hinter Llama 1 34B liegt, führt Mistral auf die geringeren Parameter zurück.

Optimierungen in der Transformer-Architektur

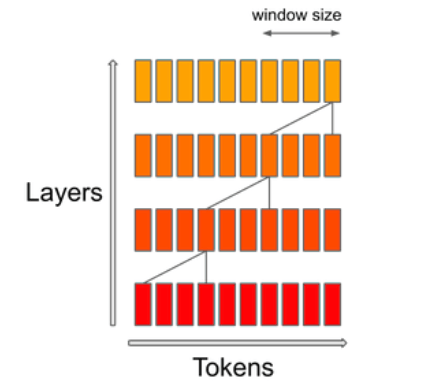

Eine höhere Effizienz erreicht Mistral durch die Grouped-Query-Attention (GQA), die mehrere Anfragen gleichzeitig bearbeiten kann und so die Recheneffizienz in Transformer-Modellen bei gleichbleibend hoher Modellleistung erhöht.

Der Sliding-Window-Attention (SWA) Mechanismus konzentriert sich auf eine bestimmte Größe des Kontextfensters innerhalb einer Sequenz. Dadurch soll ein Gleichgewicht zwischen Rechenkosten und Modellqualität erreicht werden. Laut Mistral verdoppelt sich dadurch die Geschwindigkeit für Sequenzlängen von 16k mit einem Kontextfenster von 4k.

Um seine Vielseitigkeit zu demonstrieren, hat Mistral AI den Mistral 7B an die HuggingFace-Instruktionsdatensätze angepasst, was zum Modell Mistral 7B Instruct führte. Es übertrifft alle 7B Modelle auf MT-Bench und konkurriert mit 13B Chat Modellen.

Mistral AI wird nachlegen

Das französische Start-up Mistral AI machte im Juni auf sich aufmerksam, als es mit 105 Millionen US-Dollar die größte europäische Seed-Runde verkündete - ohne ein Produkt zu haben. Das Team besteht aus ehemaligen Mitarbeitern von Meta und Google Deepmind, prominenter Investor ist der ehemalige Google-Chef Eric Schmidt.

Das Geschäftsmodell ist die Verbreitung leistungsfähiger Open-Source-Modelle mit speziellen Bezahloptionen für zahlungswillige Kunden. Top-Modelle könnten kostenpflichtig sein, heißt es in einem geleakten Pitch-Brief.

Daraus geht auch hervor, dass Mistral bis Ende 2023 eine "Familie von Textgenerierungsmodellen" auf den Markt bringen will, die ChatGPT mit GPT-3.5 und Google Bard "deutlich übertreffen" soll. Ein Teil dieser Modellfamilie wird Open Source sein. Mistral 7B dürfte also erst der Anfang sein.