Nvidia 3D MoMa: Neural Inverse Rendering macht aus Fotos 3D-Objekte

Nvidias 3D MoMa erzeugt aus knapp 100 Fotos innerhalb einer Stunde ein fertiges 3D-Modell - inklusive Texturen und Beleuchtung.

Fortschritte beim Einsatz Künstlicher Intelligenz für Computergrafik ermöglichen es entsprechenden Systemen, 3D-Repräsentationen aus 2D-Fotos zu lernen, die klassische Ansätze wie Photogrammetrie schlagen können.

Besonders beeindruckende Ergebnisse erzeugen hier sogenannte Neural Radiance Fields (NeRFs), die fotorealistische Renderings von Objekten, Landschaften oder Innenräumen für Googles Immersive View erzeugen.

Probleme haben NeRFs etwa bei der Darstellung von Bewegung oder wenn aus der Netz-Repräsentation ein verarbeitbares 3D-Objekt mit Mesh, Textur und Beleuchtung entstehen soll. Das Bewegungsproblem versuchen unter anderem Forschende von Google mit HumanNeRF anzugehen. Für das zweite Problem gibt es bereits erste Methoden, doch die Extraktion eines 3D-Objektes aus dem neuronalen Netz ist noch immer umständlich.

Nvidias 3D MoMa verzichtet auf NeRFs

Doch effiziente Varianten des sogenannten Inverse Rendering - also die Generierung von traditionellen 3D-Modellen aus Fotos - könnte den Arbeitsablauf in der Grafikindustrie stark beschleunigen.

Forschende von Nvidia zeigen jetzt 3D MoMa, eine neuronale Inverse-Rendering-Methode, die deutlich schneller nutzbare 3D-Modelle erzeugt als alternative Methoden - auch solche, die NeRFs nutzen.

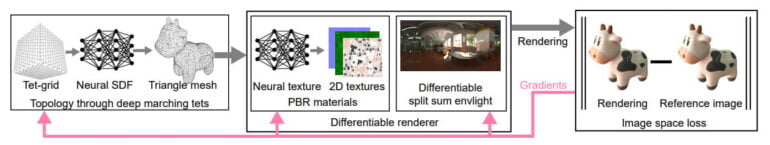

Nvidias 3D MoMa lernt stattdessen Topologie, Materialien und Umgebungsbeleuchtung aus 2D-Aufnahmen mit separaten Netzen, darunter eines für Texturen und eines, das unter anderem SDF-Werte (Signed Distance Field) aus einem wandernden Tetraeder-Gitter lernt.

3D MoMa gibt so direkt ein 3D-Modell in Form von Dreiecks-Mesh und texturierten Materialien aus und kann anschließend in geläufigen 3D-Werkzeugen bearbeitet werden. Für das Training mit knapp 100 Fotos benötigt 3D MoMa etwa eine Stunde auf einer Nvidia Tensor Core GPU.

Alternative Methoden, die auf NeRFs setzen, benötigen oft einen oder mehrere Tage Training. Nvidias Instant NeRF ist zwar deutlich schneller und lernt eine 3D-Repräsentation in wenigen Minuten, unterstützt allerdings keine Dekomposition von Geometrie, Materialien und Beleuchtung.

Video: Nvidia

Inverse Rendering als der "heilige Gral"

David Luebke, Vize-Präsident für Grafikforschung bei Nvidia, sieht 3D MoMa als wichtigen Schritt zur schnellen Erzeugung von 3D-Modellen, die Kreative ohne Einschränkungen in bestehenden Werkzeugen importieren, bearbeiten und erweitern könnten. Inverse Rendering sei schon lange der "heilige Gral der Vereinigung von Computer Vision und Computergrafik", so Luebke.

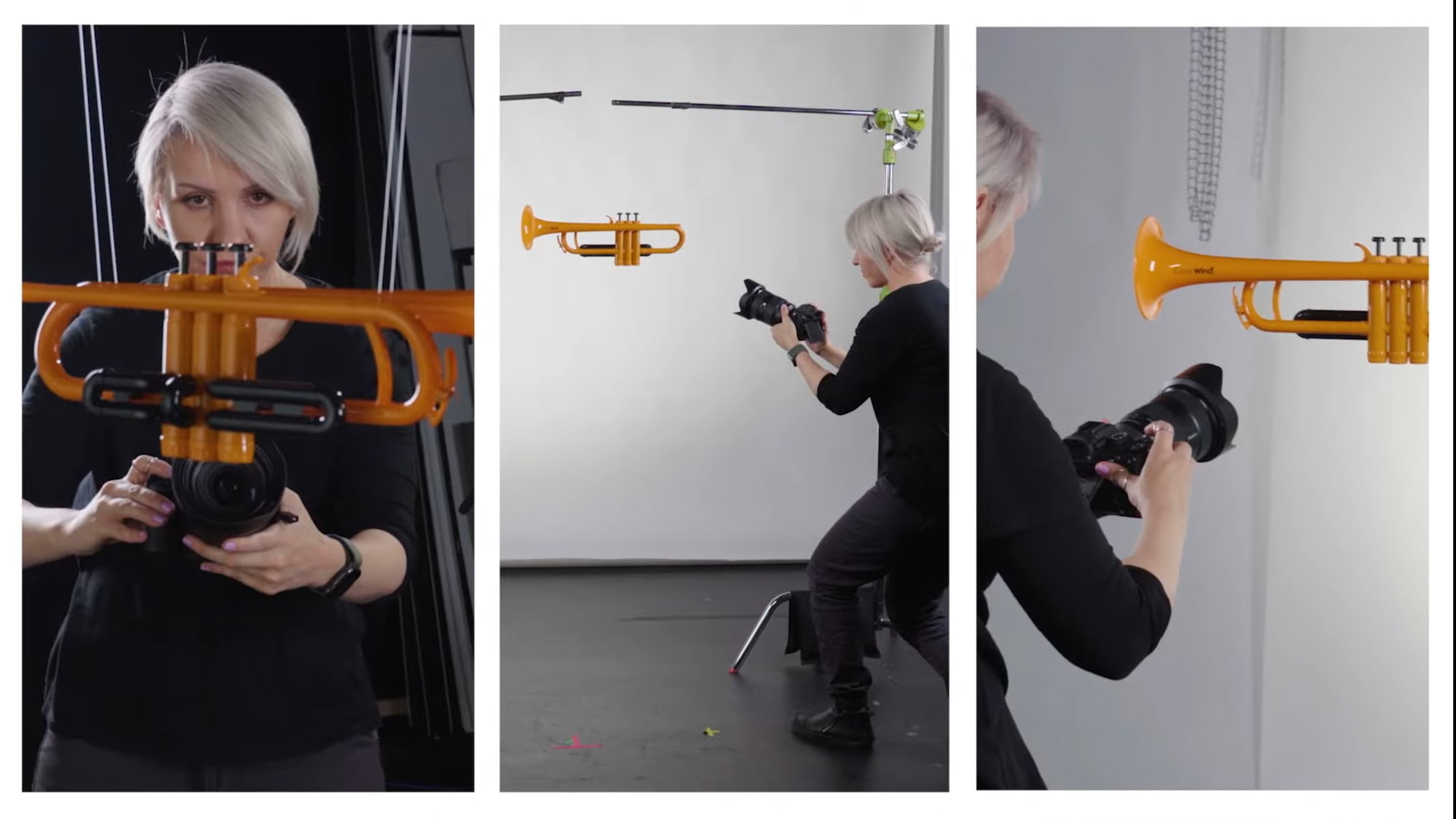

Für einen Showcase sammelten Nvidia-Forschende knapp 100 Fotos von jeweils fünf Jazz-Band-Instrumenten und nutzten die 3D-MoMa-Pipeline, um daraus 3D-Modelle zu schaffen und zu bearbeiten.

Die Ergebnisse sind im Video oben zu sehen und noch nicht perfekt - doch weitere Verbesserungen sind absehbar und könnten schon zeitnah den Modellierungsprozess ähnlich stark ändern, wie es der Einzug der Photogrammetrie bereits getan hat.

Wer mehr über das Inverse Rendering, NeRFs und andere Neural-Rendering-Methoden lernen will, kann sich unseren DEEP MINDS Folge #8 mit Nvidia-Forscher Thomas Müller anschauen. Müller ist einer der Co-Autoren von 3D MoMa.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.