Nvidia stellt RTX-50-GPUs vor: "KI ist die neue Grafik"

Nvidia hat eine neue Grafikkarten-Generation vorgestellt: die GeForce-RTX-50-Serie für Desktop-PCs und Laptops, die auf vielen Ebenen Gebrauch von deren KI-Rechenleistung machen.

Nvidia hat auf der CES die neuen Grafikkarten der RTX-50-Serie vorgestellt, darunter die RTX 5090 für 1.999 Dollar und die RTX 5080 für 999 Dollar. Die RTX 5090 und 5080 sollen ab dem 30. Januar erhältlich sein, die RTX 5070 Ti und 5070 folgen im Februar.

Die Karten nutzen die neue Blackwell-Architektur und GDDR7-Speicher. Die RTX 5090 soll dank DLSS 4 doppelt so schnell sein wie die RTX 4090, benötigt aber auch 575 Watt Leistung. Die RTX 5080 verspricht ebenfalls eine Verdopplung der Leistung gegenüber der RTX 4080. Auch Laptop-Varianten der RTX-50-Serie wurden angekündigt und sollen ab März verfügbar sein.

Kleine neuronale Netze in Shadern sollen neue Gaming-Ära einläuten

Laut Nvidia ist die neue GPU-Serie dafür optimiert, dass KI in Zukunft einen großen Teil der Renderarbeit übernehmen kann, beispielsweise durch KI-gestütztes Raytracing, das Rendern hochkomplexer Szenen und die Erstellung lebensechter Charaktere. Das RTX Kit soll Geometrie, Texturen, Materialien und Beleuchtung verbessern, um eine höhere visuelle Qualität und Leistung zu erzielen und gleichzeitig Artefakte, Instabilität und VRAM-Verbrauch zu reduzieren.

Eine zentrale Komponente der neuen Grafikkarten sind die RTX Neural Shader. Diese integrieren kleine neuronale Netze direkt in die programmierbaren Shader. Nvidia verspricht sich davon vielfältige Einsatzmöglichkeiten, darunter Radiance Caching, Texturkompression, Materialien und Radiance Fields.

Mit dem RTX Neural Shaders SDK sollen Entwickler ihre Spieldaten und Shader-Codes auf RTX-GPUs trainieren und die trainierten Modelle zur Laufzeit beschleunigen können.

Konkrete Anwendungen sind laut Nvidia die KI-basierte Texturkompression (RTX Neural Texture Compression), die Kompression komplexer Shader-Codes für Materialien (RTX Neural Materials) und die KI-basierte Berechnung indirekter Beleuchtung (RTX Neural Radiance Cache).

Menschlichere Gesichter und Figuren durch KI

Ein weiterer Schwerpunkt der Präsentation war die realistischere Darstellung von Personen in Spielen. Dafür soll die Funktion RTX Neural Faces sorgen, die mit Hilfe von generativer KI die Qualität von Gesichtern verbessern soll.

Statt auf reines Brute-Force-Rendering zu setzen, verwendet Neural Faces ein trainiertes KI-Modell, um aus einem einfachen, gerasterten Gesicht und 3D-Daten ein natürlicher wirkendes Gesicht zu inferieren.

Ergänzend dazu dient das RTX Character Rendering SDK, das sich auf die Darstellung von Haaren und Haut konzentriert. Mithilfe neuer GPU-beschleunigter Primitive wie Linear-Swept Spheres (LSS) für Haare und Subsurface Scattering (SSS) für Haut sollen natürlichere Darstellungen erzielt werden.

Mehr Dreiecke durch beschleunigte BVH-Berechnung

Um deutlich komplexere Welten mit hunderten Millionen Dreiecken in Echtzeit rendern zu können, setzt Nvidia auf RTX Mega Geometry. Die Technologie soll den Aufbau der Bounding Volume Hierarchy (BVH) beschleunigen und damit bis zu 100-mal mehr Dreiecke als bisherige Verfahren ermöglichen.

Erreicht werden soll dies durch eine intelligente Aktualisierung von Dreiecksclustern in Stapeln auf der GPU, was den CPU-Overhead reduzieren und die Performance und Bildqualität in Raytracing-Szenen erhöhen soll.

DLSS 4 mit bis zu drei zusätzlichen Frames

Für eine höhere Leistung und geringere Latenz sollen die neuen Versionen der KI-Technologien DLSS und Reflex sorgen. DLSS (Deep Learning Super Sampling) ist eine Technologie von Nvidia, die mithilfe von KI aus niedrig aufgelösten Bildern höher aufgelöste Bilder generiert und so die Leistung steigert.

DLSS 4 führt eine Multi-Frame-Generation ein, die bis zu drei zusätzliche Frames für jeden gerenderten Frame erzeugt. Außerdem wird eine neue Transformer-basierte Architektur für DLSS Super Resolution, DLSS Ray Reconstruction und Deep Learning Anti-Aliasing verwendet.

Reflex 2 setzt auf eine Technik namens Frame Warp, die den gerenderten Frame anhand der letzten Mauseingabe aktualisiert, bevor er an den Bildschirm gesendet wird. Dadurch soll die Latenz im Vergleich zum nativen Rendering um bis zu 75 Prozent reduziert werden.

Autonome Spielfiguren durch Nvidia ACE

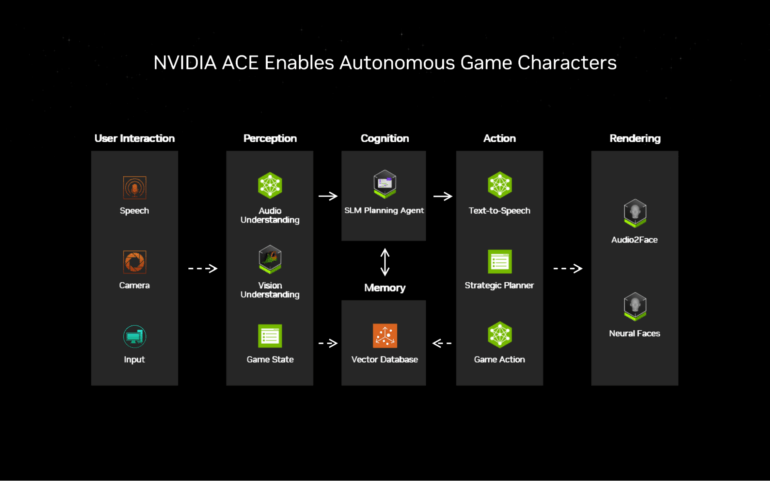

Auch im Bereich der Spiel-KI will Nvidia mit der Einführung der Nvidia ACE autonomen Spielfiguren neue Maßstäbe setzen. Mithilfe generativer KI sollen sich Spielwelten mit Begleitern wie dem "PUBG Ally" erschaffen lassen, die Spielziele verstehen und unterstützen, sowie mit Gegnern, die sich dynamisch an die Taktik der Spieler:innen anpassen.

Ermöglicht werden soll dies durch ACE Small Language Models (SLMs) für die Planung sowie multimodale SLMs für Vision und Audio, sodass KI-Charaktere akustische Signale wahrnehmen und ihre Umgebung erfassen können. Auch ein neues Audio2Face-Echtzeit-Diffusionsmodell für genauere Lippensynchronisation und Emotionen wurde angekündigt.

Jim Fan, leitender Wissenschaftler bei Nvidia, ist von der Bedeutung der KI für die Zukunft der Computergrafik überzeugt: "Verinnerlicht ihr wirklich, was Jensen über Grafik gesagt hat? Dass die neue Karte neuronale Netze verwendet, um 90+% der Pixel für eure Spiele zu generieren? Traditionelle Raytracing-Algorithmen rendern nur ~10%, eine Art 'grobe Skizze', und dann füllt ein generatives Modell den Rest der feinen Details aus. In einem Durchlauf. In Echtzeit. KI ist die neue Grafik, meine Damen und Herren."

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.