"Object Images": Forscher packen komplexe 3D-Modelle in 64x64-Pixel-Bilder

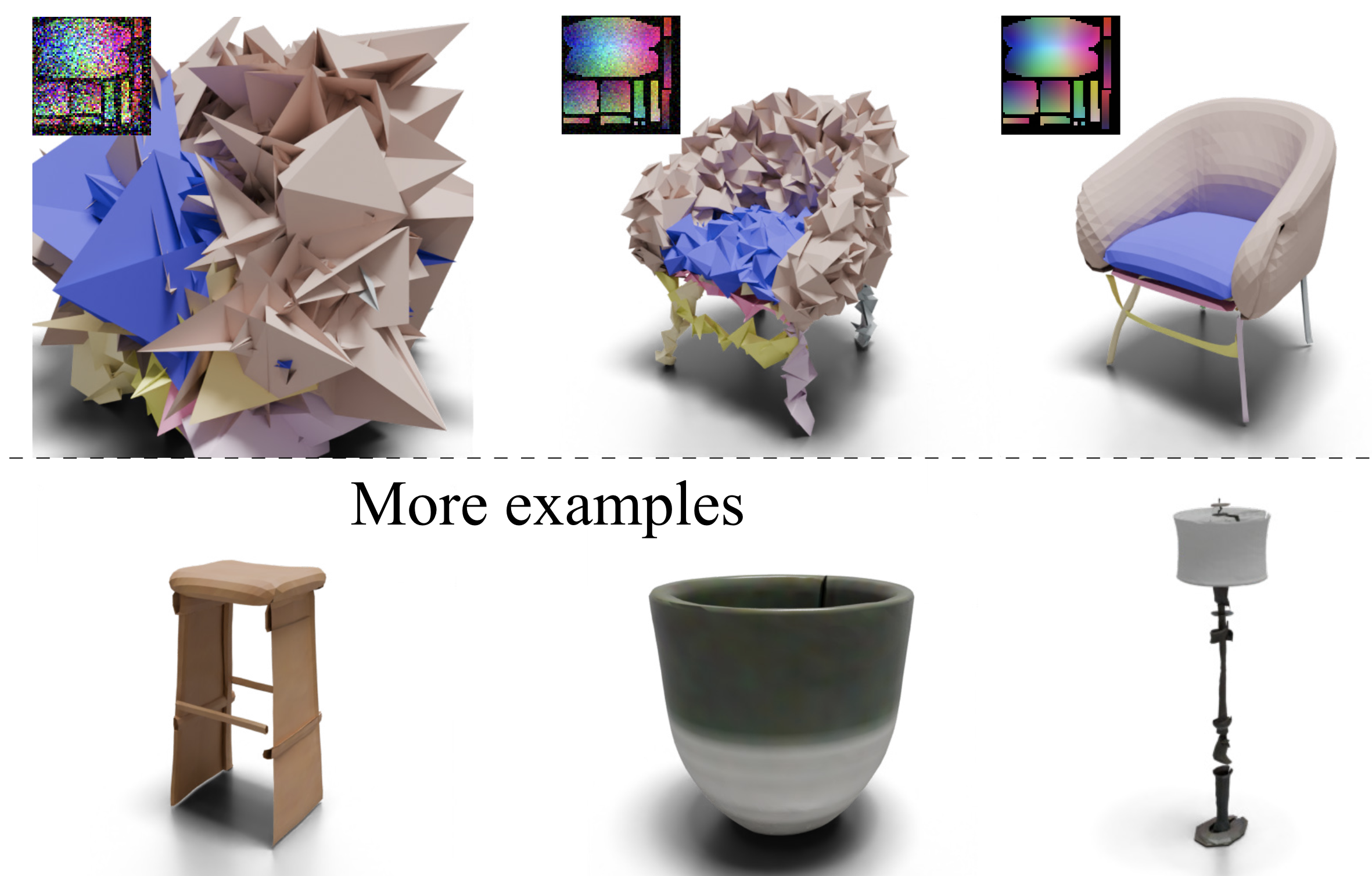

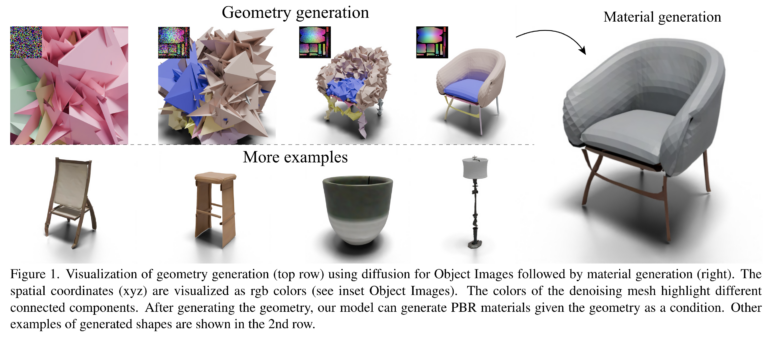

Ein Forscherteam hat eine neue Technik vorgestellt, die es ermöglicht, realistische 3D-Modelle mit Texturen aus kompakten 2D-Bildern zu erzeugen. Der Ansatz könnte den Prozess der 3D-Inhaltserstellung grundlegend verändern.

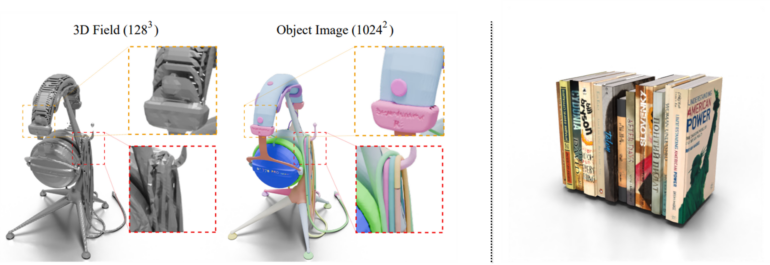

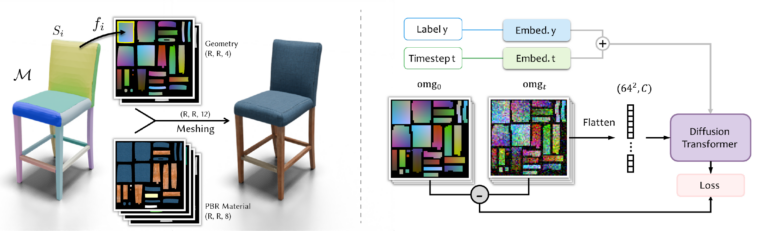

Wissenschaftler der Simon Fraser University und der City University of Hong Kong haben eine neuartige Methode entwickelt, um 3D-Modelle mit UV-Texturen effizient aus 2D-Bildern zu generieren. Die als "Object Images" (kurz: Omages) bezeichnete Technik fasst die Geometrie, das Erscheinungsbild und die Oberflächenstruktur eines 3D-Objekts in einem 64x64 Pixel großen Bild zusammen.

Diese kompakte Darstellung ermöglicht es, komplexe 3D-Formen in ein handlicheres 2D-Format zu überführen. Umgekehrt lassen sich aus diesen Bildern wieder vollständige 3D-Modelle rekonstruieren.

Video: Yan, Lee et al.

Object Images ermöglichen 3D-Modelle aus winzigen Bildern

Die "Object Images" bestehen aus 12 Kanälen, die Informationen zu Geometrie, Albedo (Textur), Normalenkarten, Metallizität und Rauheit enthalten. Durch Umkehrung der 2D-Abbildung kann ein komplettes 3D-Modell mit PBR-Materialien erzeugt werden.

Um ihre Methode zu testen, trainierten die Forscher ein Diffusionsmodell auf dem Amazon Berkeley Objects (ABO) Datensatz mit etwa 8.000 hochwertigen 3D-Modellen. Laut dem Team erreichten die generierten 3D-Formen mit Oberflächenstrukturen eine mit aktuellen 3D-Generierungsmodellen vergleichbare Qualität.

Der Ansatz hat jedoch auch Einschränkungen: Die erzeugten 3D-Modelle weisen noch Lücken auf, das Training erfordert 3D-Formen mit hochwertigen Daten und die derzeit genutzte Auflösung von 64x64 Pixeln bietet zwar Vorteile, schränkt aber auch die mögliche Qualität der Endergebnisse ein.

Dennoch sehen die Forscher in ihrer Arbeit einen wichtigen Schritt auf dem Weg zu einer effizienten Erzeugung hochwertiger 3D-Assets. Sie wollen nun die bestehenden Einschränkungen der Methode überwinden.

Mehr Informationen und bald den Code gibt es auf der Projektseite.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.