Open-Source-KI-Gedächtnis Mastra nutzt Ampel-Emojis für effizientere Kompression

Das Open-Source-Framework Mastra komprimiert Konversationen von KI-Agenten nach menschlichem Vorbild zu dichten Beobachtungen, priorisiert mit Emojis. Auf dem LongMemEval-Benchmark erreicht das System einen neuen Bestwert.

KI-Agenten haben ein grundlegendes Problem mit ihrem Gedächtnis. Je länger eine Konversation dauert, desto mehr Token füllen das Kontextfenster. Das Modell wird langsamer, teurer und ungenauer. Mastra, ein Open-Source-Framework für agentenbasierte KI-Systeme, will dieses Problem mit einem neuen Ansatz namens "Observational Memory" lösen.

Statt den gesamten Nachrichtenverlauf im Kontextfenster zu halten, beobachten zwei Hintergrund-Agenten die Konversation und komprimieren sie zu dichten Notizen. Als Vorbild dient laut Mastra das menschliche Gehirn, das Millionen visueller Eindrücke zu wenigen Beobachtungen destilliert, statt jedes Detail zu speichern.

Das System kommt ohne Vektordatenbank oder Wissensgraph aus. Die Beobachtungen werden als reiner Text in einem klassischen Storage-Backend wie PostgreSQL, LibSQL oder MongoDB gespeichert und direkt ins Kontextfenster geladen, statt über Embedding-Suche abgerufen zu werden.

Rote Kreise für Wichtiges, grüne für Nebensächliches

Innovativ ist das Priorisierungssystem der komprimierten Beobachtungen. Mastra reimplementiert klassische Logging-Stufen aus der Softwareentwicklung mit Emojis, die ein Sprachmodell besonders gut parsen kann. 🔴 steht für wichtige Informationen, 🟡 für potenziell relevante, 🟢 für reine Kontextinformationen ohne besondere Priorität. Ergänzt wird das durch ein Drei-Datums-Modell mit Beobachtungsdatum, referenziertem Datum und relativem Datum, was laut Mastra das zeitliche Reasoning verbessert.

Date: 2026-01-15

- 🔴 12:10 User is building a Next.js app with Supabase auth, due in 1 week (meaning January 22nd 2026)

- 🔴 12:10 App uses server components with client-side hydration

- 🟡 12:12 User asked about middleware configuration for protected routes

- 🔴 12:15 User stated the app name is "Acme Dashboard"

Neue Nachrichten werden angehängt, bis ein konfigurierbarer Schwellenwert erreicht ist, standardmäßig 30.000 Token. Dann tritt ein sogenannter "Observer"-Agent in Aktion und komprimiert die Nachrichten zu den Emoji-annotierten Beobachtungen.

Die Kompressionsrate hängt stark vom Inhalt ab: Bei reinen Textkonversationen, wie sie im LongMemEval-Benchmark vorkommen, liegt sie laut Mastras Research-Seite beim 3- bis 6-Fachen – im Benchmark selbst bei etwa 6-Fach.

Bei Agenten, die viele Tool-Aufrufe tätigen, etwa Browser-Agenten mit Playwright-Screenshots oder Coding-Agenten, die Dateien scannen, steigt die Kompression auf das 5- bis 40-Fache. Je verrauschter die Tool-Ausgaben, desto höher das Verhältnis. Eine Playwright-Sitzung mit 50.000 Token pro Seitenscreenshot schrumpft so auf wenige Hundert Token.

Wachsen die Beobachtungen selbst über einen zweiten Schwellenwert von standardmäßig 40.000 Token, übernimmt ein "Reflector"-Agent. Er kondensiert die Beobachtungen weiter, kombiniert verwandte Einträge und entfernt nicht mehr Relevantes. So entsteht ein dreistufiges System aus aktuellen Nachrichten, Beobachtungen und Reflexionen.

Protokoll statt Verdichtung

Mastra grenzt Observational Memory explizit von herkömmlicher Verdichtung ab, bei der der Nachrichtenverlauf bei drohendem Kontextüberlauf einmalig zusammengefasst wird. Observational Memory arbeitet stattdessen als fortlaufendes, nur angehängtes Ereignisprotokoll: Der Observer dokumentiert laufend, was passiert, welche Entscheidungen getroffen wurden und was sich geändert hat. Auch bei der Reflexion wird das Protokoll nur umstrukturiert, nicht zusammengefasst. Verbindungen werden hergestellt und redundante Einträge entfernt.

Ein wesentlicher Vorteil ist laut Mastra die Kompatibilität mit Prompt-Caching, wie es Anthropic, OpenAI und andere Anbieter unterstützen. Da Beobachtungen nur angehängt und nicht dynamisch zusammengestellt werden, bleibt der Prompt-Präfix stabil und ermöglicht bei jedem Turn volle Cache-Treffer.

Nur bei Reflexionen, die selten stattfinden, wird der gesamte Cache invalidiert. Das reduziert Kosten und adressiert zwei Kernprobleme langer Konversationen: den Leistungsabfall durch zu viel Nachrichtenverlauf und irrelevante Token, die Platz im Kontextfenster belegen.

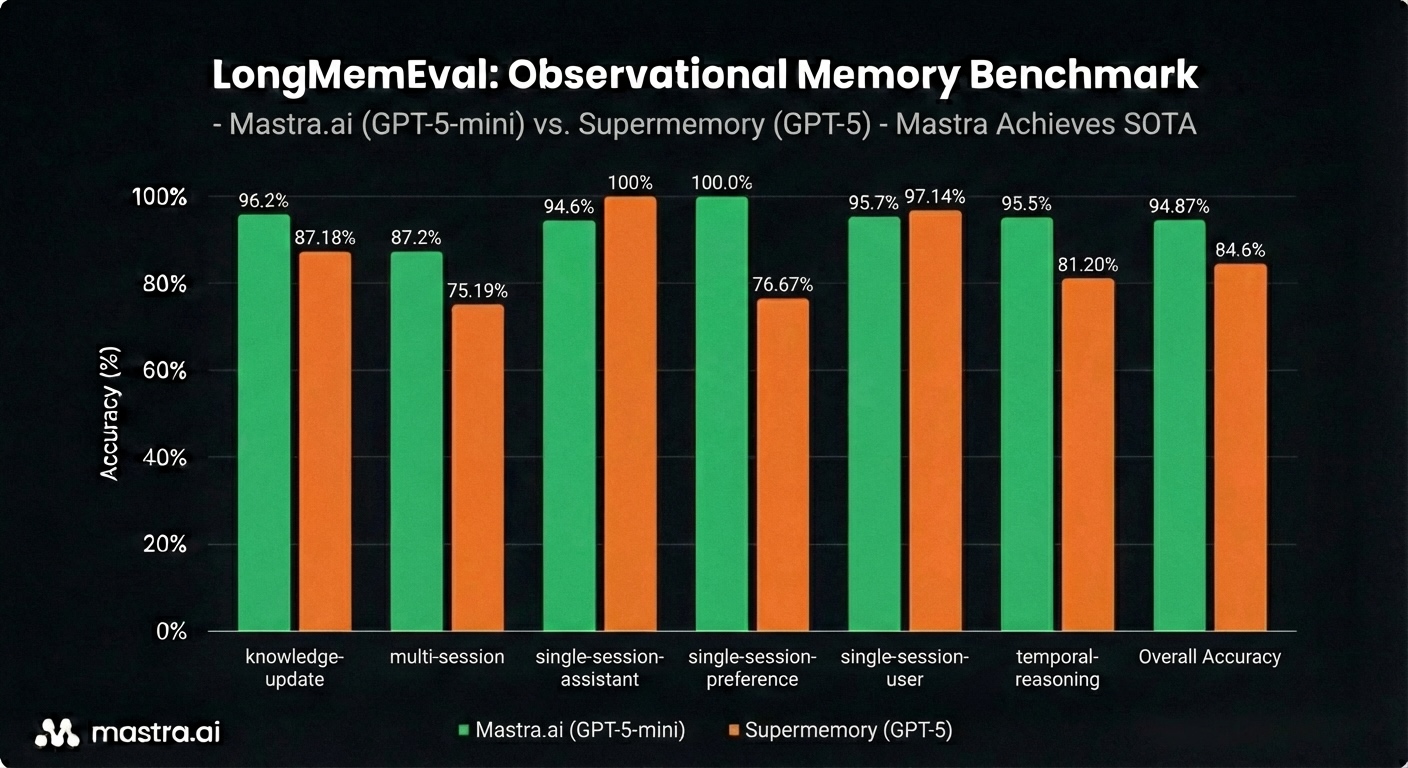

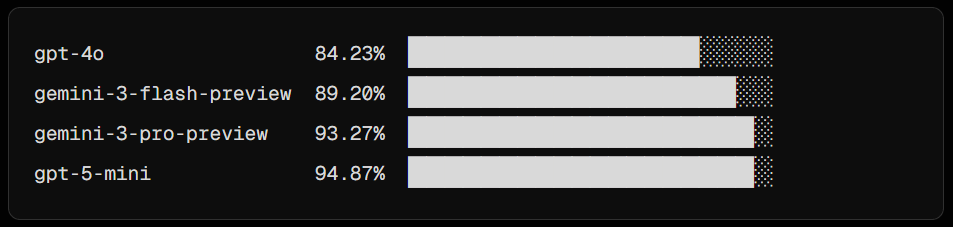

Neuer Bestwert auf dem LongMemEval-Benchmark

Auf dem LongMemEval-Benchmark erreicht Observational Memory laut Mastra mit GPT-5 Mini 94,87 Prozent, über drei Punkte höher als jeder zuvor verzeichnete Wert. Mit GPT-4o erzielt das System 84,23 Prozent und übertrifft damit sowohl die Oracle-Konfiguration, die nur die relevanten Konversationen erhält, als auch den bisherigen Bestwert von Supermemory. Konkurrierende Systeme wie Hindsight setzen dabei auf mehrstufiges Retrieval und neuronales Reranking, während Observational Memory mit einem einzigen Durchlauf und stabilem Kontextfenster arbeitet.

Ganz ohne Einschränkungen kommt das System allerdings nicht aus. Die Observation läuft aktuell synchron und blockiert die Konversation, während der Observer Nachrichten verarbeitet. Ein asynchroner Hintergrund-Modus soll laut Mastra in Kürze folgen. Zudem funktionieren Anthropics Claude-4.5-Modelle derzeit nicht als Observer oder Reflector. Mastra positioniert Observational Memory als Nachfolger seiner bisherigen Memory-Systeme Working Memory und Semantic Recall, die das Team im Frühjahr veröffentlicht hatte. Der Code für das Framework ist öffentlich auf GitHub verfügbar.

KI-Gedächtnis wird zum Wettlauf der Architekturen

Vergangenes Jahr stellte ein chinesisches Forschungsteam mit "GAM" ein ähnlich motiviertes Gedächtnissystem vor, das ebenfalls zwei spezialisierte Agenten einsetzt, dort "Memorizer" und "Researcher" genannt, um den sogenannten "Context Rot" bei langen Konversationen zu bekämpfen. Im Unterschied zu Mastras textbasiertem Ansatz setzt GAM allerdings auf Vektorsuche und iteratives Retrieval in einer vollständigen Historie.

Parallel dazu veröffentlichte Deepseek ein OCR-Modell, das Textdokumente als komprimierte Bilder verarbeitet und so das Kontextfenster um bis zu das Zehnfache entlasten soll. Ähnlich wie Menschen sich eher an das Erscheinungsbild einer Seite erinnern als an jeden einzelnen Satz, speichert das System den visuellen Eindruck statt den vollen Text.

Forschende aus Shanghai skizzierten die Vision eines "Semantic Operating System" als lebenslanges KI-Gedächtnis, das Kontext nicht nur speichern, sondern wie das menschliche Gehirn aktiv verwalten, anpassen und gezielt vergessen können soll.

Das effiziente Gedächtnis für KI-Agenten entwickelt sich damit zu einem der aktivsten Forschungsfelder der Branche, jüngst noch einmal angefeuert durch den persönlichen Assistenten OpenClaw. Auch Chatbots wie ChatGPT bieten schon lange eine Memory-Funktion, setzen dabei aber eher auf herkömmliche Verdichtung, die eine weitere potenzielle Fehlerquelle bei der Arbeit mit generativer KI darstellt.

Ganz unabhängig davon, welche Architektur sich durchsetzt und ob ein KI-Gedächtnis kommt, dürfte in jedem Fall gutes Context Engineering, also das Bereitstellen nur der relevanten Informationen für das KI-Modell zum benötigten Zeitpunkt, eine große Rolle spielen – sei es nur, um ressourcenfreundlich zu arbeiten. Beim aktuellen Stand der Technologie ist Context Engineering essenziell, um die KI-Fehlerquote gering zu halten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.