Update vom 12. April 2024:

Das aktualisierte GPT-4 ist jetzt in ChatGPT verfügbar. Das Modell sollte vorwiegend in Mathematik und Coding besser sein und zudem weniger herumreden.

In den Benchmarks zeigt sich das wie folgt:

- MATH (Measuring Mathematical Problem Solving With the MATH Dataset): +8.9%, misst die Fähigkeit, mathematische Probleme zu lösen.

- GPQA (A Graduate-Level Google-Proof Q&A Benchmark): +7.9%, misst die Fähigkeit, anspruchsvolle Fragen zu beantworten, die nicht durch einfache Google-Suchen beantwortet werden können.

- MGSM (Multilingual Grade School Math Benchmark): +4.5%, misst die Fähigkeit, mathematische Probleme auf Grundschulniveau in mehreren Sprachen zu lösen.

- DROP (A Reading Comprehension Benchmark Requiring Discrete Reasoning Over Paragraphs): +4.5%, misst das Leseverständnis und die Fähigkeit, diskrete Schlussfolgerungen aus Absätzen zu ziehen.

- HumanEval (Evaluating Large Language Models Trained on Code): +1.6%, misst die Fähigkeit, Code zu verstehen und zu generieren, basierend auf menschlichen Bewertungen.

- MMLU (Measuring Massive Multitask Language Understanding): +1.3%, misst das Verständnis und die Fähigkeit, Aufgaben aus verschiedenen Bereichen zu lösen.

Ursprünglicher Artikel vom 9. April 2024:

OpenAI rollt verbessertes GPT-4-Vision-Modell für ChatGPT und API aus

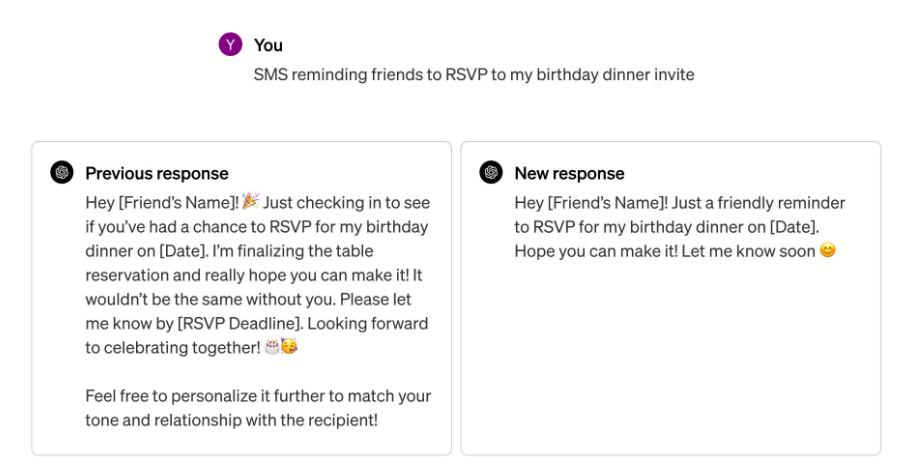

OpenAI hat Verbesserungen am GPT-4 Turbo-Modell in seiner API angekündigt, die bald auch in ChatGPT verfügbar sein werden.

Das neue multimodale GPT-4 Turbo-Modell (2024-04-09) mit Bildverarbeitung ist allgemein in der API verfügbar. Dieses Modell kann mit nur einem API-Aufruf sowohl Text als auch Bilder analysieren und Schlussfolgerungen ziehen. Bisher mussten Entwickler dafür separate Modelle verwenden.

Anfragen mit Bildern unterstützen nun auch gängige API-Funktionen wie den JSON-Modus und Funktionsaufrufe, was die Integration in Anwendungen und Arbeitsabläufe von Entwicklern erleichtern soll.

OpenAI demonstriert die Leistungsfähigkeit des neuen Modells anhand einiger Anwendungsfälle wie tldraw, das für eine Web-Interface-Zeichnung den passenden Code schreibt.

Video: Roberto Nickson