OpenAI-Chef sieht Kombination von LLMs und LRMs als Schlüssel für KI-Fortschritt

Laut OpenAI-CEO Sam Altman ist die Kombination von Large Language Models (LLMs) mit Reinforcement Learning der Schlüssel zu weiteren Durchbrüchen in der KI-Entwicklung. Er sieht darin eine Möglichkeit, die Skalierungsgrenzen von LLMs zu überwinden.

Die bisherige Methode, immer größere Sprachmodelle (LLMs, Large Language Models) mit immer mehr Daten zu trainieren, stößt an ihre Grenzen. Das sogenannte "Pretraining" skaliert nicht mehr wie bisher, das scheint mittlerweile Konsens in der KI-Branche.

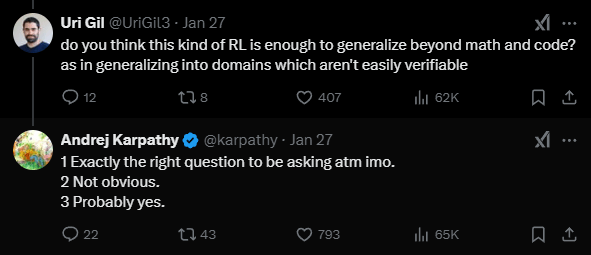

Die Alternative sind spezialisierte Modelle, die mit Reinforcement Learning für bestimmte Aufgaben optimiert werden, bei denen es eindeutig richtige oder falsche Lösungen gibt - wie Programmieren oder Mathematik. OpenAI nennt diese Modelle "Large Reasoning Models" (LRMs).

Die Frage ist nun: Können die Vorteile beider Ansätze - die Allgemeingültigkeit von LLMs und die spezialisierte Genauigkeit von LRMs - kombiniert werden?

Laut Altman bringen LRMs einen "unglaublichen Effizienzgewinn bei der Rechenleistung". Sie würden in vielen Benchmarks eine Leistung erzielen, von der man im alten Paradigma erwartet hätte, dass sie erst mit GPT-6 möglich wäre - und das mit viel kleineren Modellen.

Das Problem sei, so Altman auf einer Veranstaltung in Tokio, dass ein LRM nicht in allen Bereichen besser werde, wenn es auf diese neue Art trainiert wird. Aber man könne es in bestimmten Dimensionen verbessern. Und man könne jetzt besser vorhersagen, wo ein viel größeres, vortrainiertes Modell mit dieser Methode landen würde.

KI soll bis Ende des Jahres besser coden als alle Menschen

Altman erwartet, dass der nächste große Sprung in der Rechenleistung für ein vortrainiertes Modell mit Reasoning-Eigenschaften die ersten Anzeichen für "echte neue wissenschaftliche Erkenntnisse" bringen wird. Derzeit sei selbst das beste OpenAI-Modell unglaublich gut im Programmieren, aber nicht im Erfinden völlig neuer Algorithmen, neuer Physik oder neuer Biologie. Das werde sich mit den nächsten zwei Größenordnungen an Rechenleistung ändern.

Der OpenAI-Chef verdeutlicht den zuletzt rasanten Fortschritt im Bereich der Programmierung: Das allererste Reasoning-Modell o1 sei noch ein mittelmäßiger Programmierer gewesen. Das im Dezember vorgestellte o3-Modell sei bereits der 175. beste Programmierer der Welt gewesen. Inzwischen habe man intern bereits Platz 50 erreicht - mit der Aussicht, bis Ende des Jahres die Spitze zu erreichen.

Altman wiederholt Rückkehr zu Open Source

Altman wiederholte zudem OpenAIs Rückkehr zu mehr Open Source, bleibt aber wie gehabt vage. "Wir werden bestimmte Modelle als Open Source zur Verfügung stellen. Die Gesellschaft scheint bereit, die damit verbundenen Kompromisse einzugehen."

Laut Altman habe OpenAI gute Fortschritte dabei gemacht, die Modelle für Open-Source-Anwendungen sicher und robust zu machen. Sie würden zwar nicht immer so verwendet, aber meistens. "Ich denke also, wir werden uns in diese Richtung bewegen", so der OpenAI-CEO. Wann und welche Modelle veröffentlicht werden, ließ er offen.

Vor kurzem hatte das chinesische Unternehmen Deepseek sein Reasoning-Modell R1, das ähnliche Leistung wie OpenAIs proprietäres o1-Modell erreicht, samt Architektur und Gewichten als Open Source veröffentlicht. Das hatte Fragen aufgeworfen, ob OpenAIs Abkehr von Open Source noch zeitgemäß ist. Bisher hatte OpenAI argumentiert, dass es die Verbreitung seiner fortschrittlichen Modelle kontrollieren müsse, um Missbrauch zu verhindern.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.