OpenAI ist nicht Schuld, wenn ungeschützte ChatGPT-Accounts im Darknet landen

Mindestens 100.000 Zugangsdaten von ChatGPT-Nutzer*innen sollen im Darknet gelandet sein. Jetzt äußert sich OpenAI zu dem Vorfall.

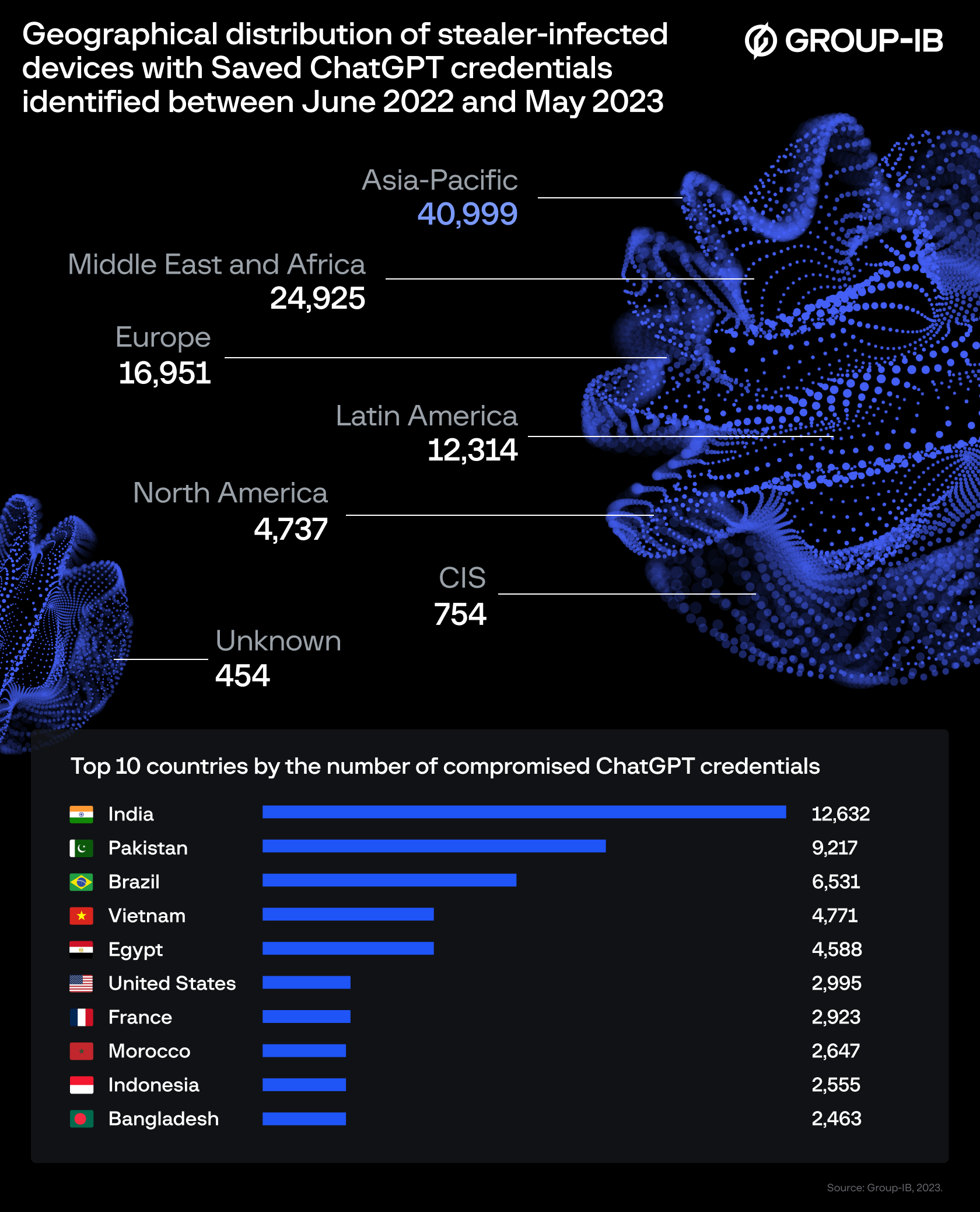

Betroffen sind vorwiegend Personen aus den USA, Frankreich, Marokko, Indonesien, Pakistan und Brasilien. Die ältesten Daten sollen aus dem Juni 2022 stammen. ChatGPT wurde im November 2022 öffentlich zugänglich gemacht.

Zwei Tage nach den ersten Berichten zum Darknet-Vorfall meldete nun sich der Entwickler OpenAI in einer Stellungnahme gegenüber Tom's Hardware zu Wort. Das US-Unternehmen betont, dass weder sie noch Nutzer*innen gezielt angegriffen wurden. Die geleakten Accounts würden untersucht.

Es war nie leichter, an ChatGPT-Accounts zu kommen

Die meisten der veröffentlichten Zugangsdaten wurden laut den Sicherheitsanalysten von Group-IB in Logs gefunden, die mit verschiedenen Schadprogrammen in Verbindung gebracht werden. An der Spitze steht die vermeintlich einfach zu bedienende Software Raccoon, die für 78.348 kompromittierte Accounts verantwortlich sein soll.

"Die Ergebnisse des Threat Intelligence Reports von Group-IB sind das Ergebnis von handelsüblicher Malware auf den Geräten der Nutzer*innen und nicht von einem Einbruch bei OpenAI", so ein Sprecher von OpenAI.

Ferner folge OpenAI den besten Industriestandards für die Authentifizierung und Autorisierung von Benutzern und ermutige seine Nutzer, starke Passwörter zu verwenden und nur geprüfte und vertrauenswürdige Software auf ihren Computern zu installieren.

ChatGPT ist ein besonders empfindliches Ziel

Dass bei solchen Account-Leaks sensible Daten in die falschen Hände geraten, ist nicht ungewöhnlich. Bei ChatGPT könnten die Auswirkungen jedoch besonders dramatisch sein: Da ChatGPT standardmäßig alle Chats speichert, könnten Angreifer*innen mit den Logins ungewollt an eine "Fundgrube sensibler Informationen" gelangen. Denn Menschen chatten mit ChatGPT über alle möglichen Themen und geben dabei auch sensible private oder geschäftliche Informationen ein.

Samsung beispielsweise hat die Nutzung von ChatGPT aus Angst vor Datenlecks verboten, nachdem ein Fall im Unternehmen bekannt wurde, bei dem Mitarbeitende sensiblen Code eingegeben hatten. Wer ChatGPT und Co. bei Samsung dennoch nutzt, kann entlassen werden.

Nach politischem Druck ermöglicht OpenAI seit Ende April per Opt-Out, alle Chats nach dem Verlassen automatisch zu löschen und aus dem Trainingsmaterial zu entfernen. Für die mehr als 100.000 Accounts kommt das zu spät: Die geleakten Daten stehen laut der Sicherheitsforscher*innen längst im Darknet zum Verkauf. Ein Passwortwechsel kann nicht schaden.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.