OpenAI kündigt GPT-4 "omni" als neues Spitzenmodell mit Audio- und Bildfunktionen an

Das neueste multimodale KI-Modell von OpenAI, GPT-4o, vereint Text-, Bild- und Audioverarbeitung in einem einzigen Modell. Es soll neue Maßstäbe in Leistung und Effizienz setzen. Das für Sprachassistenz optimierte Modell ist ab sofort kostenlos in ChatGPT verfügbar.

OpenAI hat mit GPT-4o, o steht für "omni", eine neue Version seines Sprachmodells vorgestellt, das laut OpenAI-Forscher William Fedus das derzeit leistungsfähigste auf dem Markt ist. GPT-4o kombiniert zum ersten Mal Text-, Bild- und Audioverarbeitung in einem einzigen Modell. Alle Ein- und Ausgaben werden vom selben neuronalen Netz verarbeitet.

Laut OpenAI kann GPT-4o in nur 232 Millisekunden auf Audio-Eingaben reagieren, im Durchschnitt in 320 Millisekunden, was der menschlichen Reaktionszeit in Gesprächen ähnelt. Die alten Modelle lagen bei 2,8 bis 5,4 Sekunden.

OpenAI demonstrierte die Audio-Fähigkeiten des auf geringe Latenz optimierten Modells als Sprachassistent: GPT-4o kann ruhige von aufgeregten Atemzügen unterscheiden und auf Wunsch verschiedene Emotionen in synthetischer Sprache ausdrücken - von zurückhaltend bis übertrieben. Sogar Stimmveränderungen, z. B. hin zu einem Roboter-Sound, und Singen sind möglich.

Video: OpenAI

Die Textleistung in Englisch entspricht der von GPT-4 Turbo, während GPT-4o bei nicht-englischen Sprachen deutlich besser abschneiden soll.

Durch die Vision-Fähigkeiten kann GPT-4o auch Videos oder Grafiken analysieren - jetzt sogar live. Auch Emotionen in Gesichtern in einem Video oder auf einem Foto kann GPT-4o erkennen und beschreiben und entsprechend darauf reagieren.

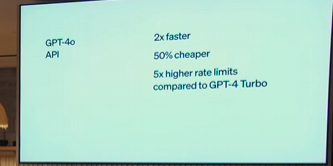

GPT-4o wird effizienter und günstiger

Ein Schwerpunkt bei der Entwicklung von GPT-4o lag auf Effizienz: Laut OpenAI soll das neue Modell doppelt so schnell und 50 Prozent günstiger als der Vorgänger GPT-4 Turbo sein. Dies dürfte insbesondere kommerzielle Anwender der API ansprechen.

Gleichzeitig erweitert OpenAI den Zugang zur Spitzentechnologie: GPT-4o ist ab sofort kostenlos in ChatGPT nutzbar. Damit steht erstmals ein Spitzenmodell, laut OpenAI das beste der Welt, der breiten Öffentlichkeit kostenlos zur Verfügung.

Allerdings gibt es Einschränkungen: Kostenlose Nutzer von ChatGPT haben nur ein Fünftel der Zugriffsmöglichkeiten von zahlenden Kunden und API-Nutzern.

Entwickler können GPT-4o in der API als Text- und "Vision"-Modell nutzen - doppelt so schnell und halb so teuer wie GPT-4 Turbo und mit fünfmal höheren Nutzungsobergrenzen. Die Audio- und Video-Fähigkeiten von GPT-4o will OpenAI in den nächsten Wochen zunächst einer kleinen Gruppe von vertrauenswürdigen Partnern in der API zur Verfügung stellen.

"Unsere ursprüngliche Vorstellung, als wir OpenAI gründeten, war, dass wir KI erschaffen und sie nutzen würden, um alle möglichen Vorteile für die Welt zu schaffen. Stattdessen sieht es jetzt so aus, als würden wir KI erschaffen und andere Menschen werden sie nutzen, um alle möglichen erstaunlichen Dinge zu schaffen, von denen wir alle profitieren", schreibt OpenAI CEO Sam Altman.

GPT-4o übertrifft Vorgängermodell deutlich

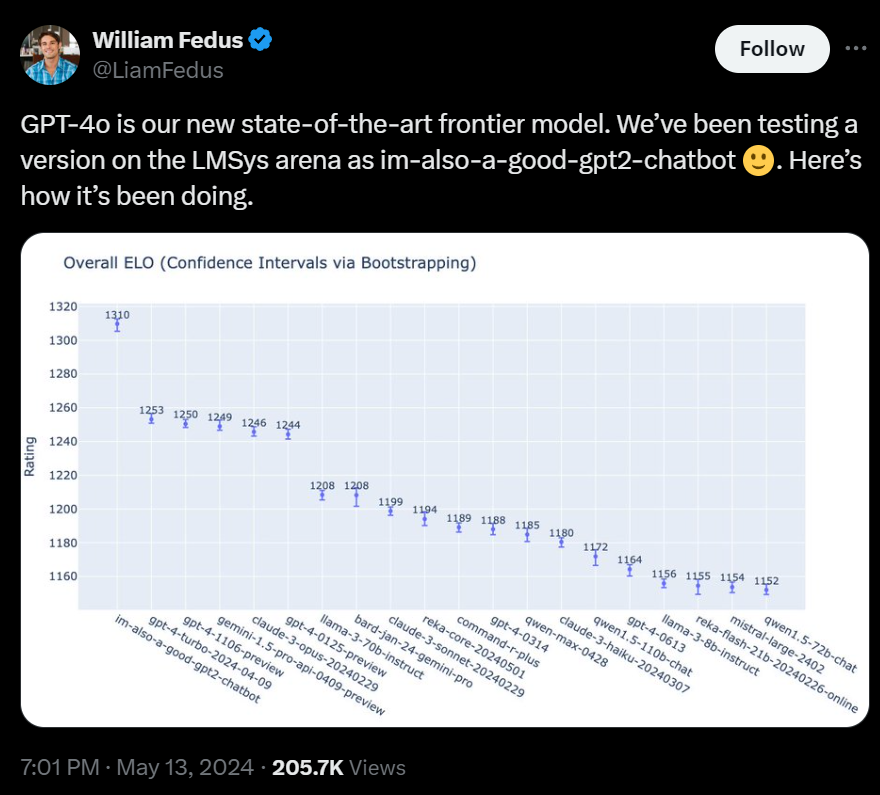

Um die Leistungsfähigkeit von GPT-4o zu demonstrieren, hat OpenAI das Modell in der LMSys Arena, einem Benchmark für Sprachmodelle, antreten lassen. Dabei übertraf es seinen Vorgänger GPT-4 Turbo um rund 60 ELO-Punkte. Die ELO-Bewertung wird derzeit als einer der wichtigsten Indikatoren für die Modellleistung angesehen, da die Bewertung im Blindtest von Menschen anhand der tatsächlichen Ausgaben des Modells vorgenommen wird.

ELO ist ein Bewertungssystem, das ursprünglich aus dem Schach stammt und die relative Spielstärke misst. Je höher der ELO-Wert, desto besser schneidet ein Spieler - oder in diesem Fall ein KI-Modell - im Vergleich ab. Die Daten stammen aus der Chatbot-Arena, in der OpenAI das Modell in den vergangenen Tagen unter falschem Namen antreten ließ.

Bei schwierigeren Aufgaben, insbesondere im Bereich der Programmierung, ist der Vorsprung laut Fedus noch größer: Hier erreicht GPT-4o einen um 100 Punkte höheren ELO-Wert als sein Vorgänger.

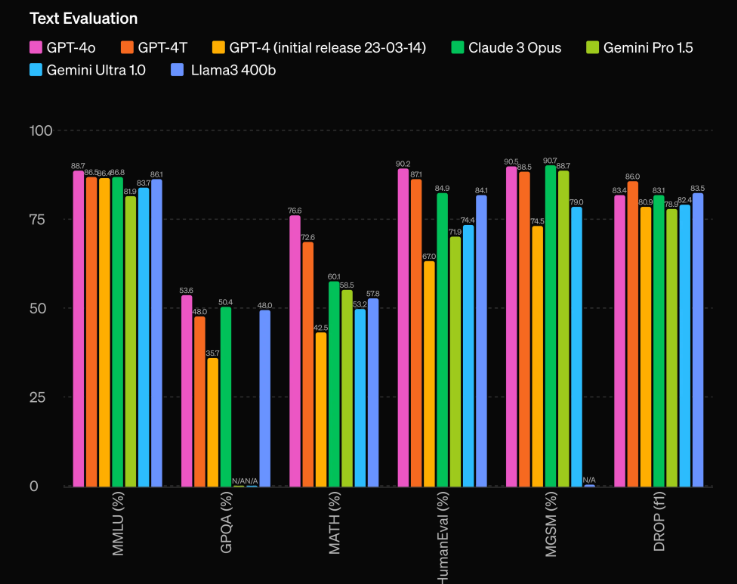

Bei traditionellen Benchmarks erreicht GPT-4o laut OpenAI die Leistung von GPT-4 Turbo bei Text, logischem Denken und Programmieren, setzt aber neue Bestwerte bei mehrsprachigen Aufgaben sowie beim Audio- und Bildverständnis.

So erzielt GPT-4o mit 87,2 Prozent einen neuen Höchstwert beim 5-Shot-Test zu Allgemeinwissen (MMLU). Auch bei der Spracherkennung und -übersetzung sowie bei Aufgaben mit Diagrammen (M3Exam) übertrifft es deutlich GPT-4 und andere Modelle. Bei visuellen Wahrnehmungstests setzt GPT-4o ebenfalls neue Maßstäbe.

Ein neuer Tokenizer für GPT-4o kann Sprachen effizienter in Tokens zerlegen, was die Verarbeitung beschleunigt und den Speicherbedarf senkt, speziell bei nicht-lateinischen Schriften. So benötigt der Satz "Hallo, mein Name ist GPT-4o" auf Telugu 3,5 Mal weniger Token als bisher, auf Deutsch immerhin noch 1,2 Mal weniger.

Weitere Neuigkeiten hatte OpenAI nicht parat. Informationen zum nächsten großen Modell sollen demnächst folgen.

Neue Desktop-App für ChatGPT

OpenAI führt zudem für ChatGPT eine neue Desktop-App für macOS sowie ein aktualisiertes Design ein. Die App ist für kostenlose und zahlende Nutzer verfügbar und ermöglicht per Tastenkombination einen schnellen Zugriff auf ChatGPT.

Video: OpenAI

Screenshots können direkt in der App besprochen werden. Ein Sprachmodus erlaubt Konversationen mit ChatGPT, zukünftig sollen auch GPT-4s Audio- und Videofunktionen integriert werden.

Die macOS-App wird schrittweise ausgerollt, eine Windows-Version soll folgen. Das neue Design von ChatGPT soll freundlicher und gesprächiger wirken, mit überarbeiteter Startseite und Nachrichtenlayout.

Sicherheit, Verfügbarkeit und Grenzen

Laut OpenAI wurde die Sicherheit von GPT-4o von Grund auf für alle Modalitäten mitentwickelt, etwa durch Filterung der Trainingsdaten oder Optimierung des Verhaltens nach dem Training. Zudem wurden neue Sicherheitssysteme für Audio-Ausgaben geschaffen.

OpenAI hat GPT-4o gemäß dem eigenen "Preparedness Framework" und mit bisher 70 externen Experten evaluiert, um Risiken durch die neuen Modalitäten zu entdecken und zu entschärfen. Vorerst werden nur Text und Bild als Eingabe sowie Text als Ausgabe für die Öffentlichkeit freigegeben.

Die anderen Modalitäten werden nach und nach folgen, sobald die technische Infrastruktur, die Benutzerfreundlichkeit und die Sicherheit gewährleistet sind. In den kommenden Wochen soll eine Alpha-Version des Sprachmodus mit GPT-4o in ChatGPT Plus gestartet werden.

Trotz der Fortschritte habe auch GPT-4o Grenzen, etwa bei komplexen Aufgaben mit mehreren Schritten oder beim Verständnis von Kontext und Nuancen. OpenAI bittet um Feedback, um das Modell weiter zu verbessern.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.