OpenAI zeigt am Beispiel von Minecraft, wie Künstliche Intelligenz mit Videotraining und bestärkendem Lernen komplexe Fähigkeiten lernen kann.

In 2019 stellten KI-Forschende das erste Mal die MineRL-Challenge vor, bei der Künstliche Intelligenz lernen soll, Minecraft zu spielen. Konkret besteht MineRL aus verschiedenen Aufgaben, etwa das Finden einer Höhle oder den Bau eines Hauses.

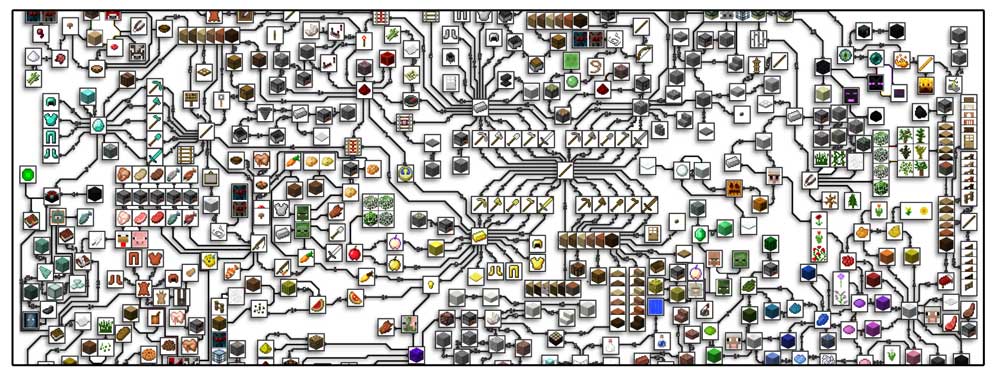

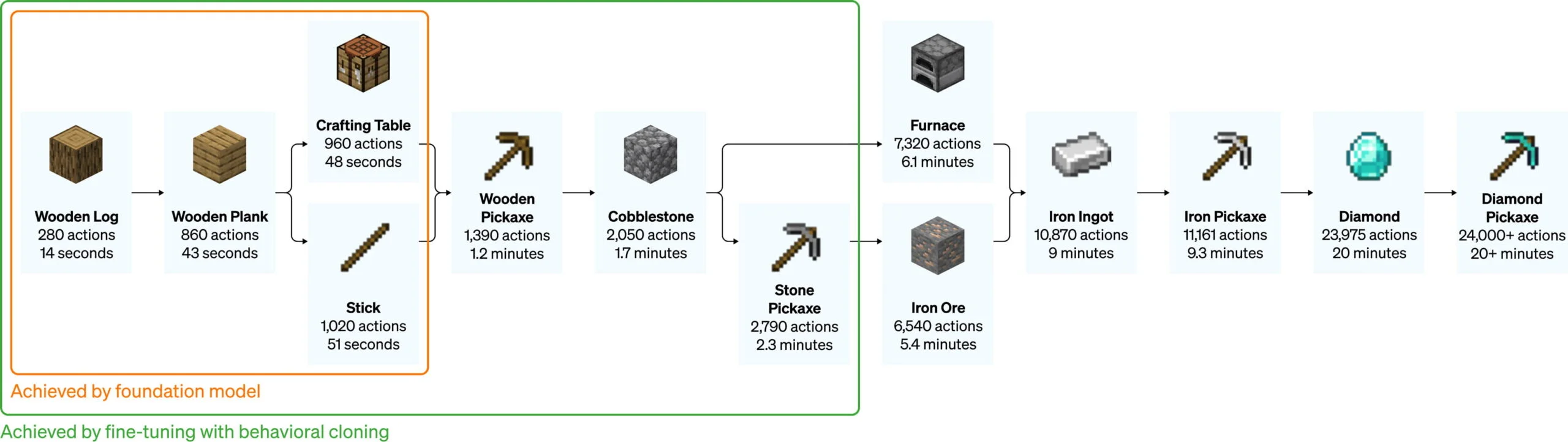

In Minecraft selbst gibt es darüber hinaus zahlreiche weitere Aufgaben, die unterschiedliche Fähigkeiten erfordern und unterschiedlich schwer sind: Der Bau einer Spitzhacke aus Holz ist etwa weitaus simpler als der einer Spitzhacke aus Diamant, die weitere Zwischenschritte erfordert. Menschliche Spieler benötigten dafür üblicherweise mehr als 20 Minuten und etwa 24.000 Aktionen.

Seit der ersten Veröffentlichung von MineRL sind vier Jahre vergangen, in denen jährlich zahlreiche Teilnehmenden ihre KI-Ansätze in den verschiedenen Aufgaben gegeneinander antreten lassen. Alle Teams erhalten Zugriff auf eine spezielle Minecraft-Version, sowie eine umfassende Sammlung Gameplay-Videos, die als Trainingsmaterial dienen sollen.

Denn statt bloß auf das bestärkende Lernen zu setzen, das mit den komplexen Aufgaben in der offenen Welt schnell überfordert ist, sieht das Team hinter MineRL eine mögliche Lösung in hybriden Ansätzen, die auf imitierendes Lernen als zentrales Element setzen.

Fortschritte in MineRL könnten daher einen Weg zu zahlreichen Anwendungen ebnen, in denen KI-Systeme von menschlichen Beispielen lernen, Aktionen durchzuführen, etwa in der Bedienung von Computern, Smartphones oder verkörpert als Roboter.

OpenAI sammelt 70.000 Stunden Gameplay als Trainingsmaterial

In einer neuen Forschungsarbeit zeigt nun ein Team von OpenAI, wie eine Mischung aus Videotraining und bestärkendem Lernen einer KI den Weg zur Diamant-Spitzhacke ebnet. Zentrales Element der Arbeit ist dabei das sogenannte Video PreTraining (VPT), bei dem ein KI-Modell mit riesigen Mengen rohen Gameplay-Videos und nur einer kleinen Menge von Menschen aufgearbeiteten Videos trainiert wird.

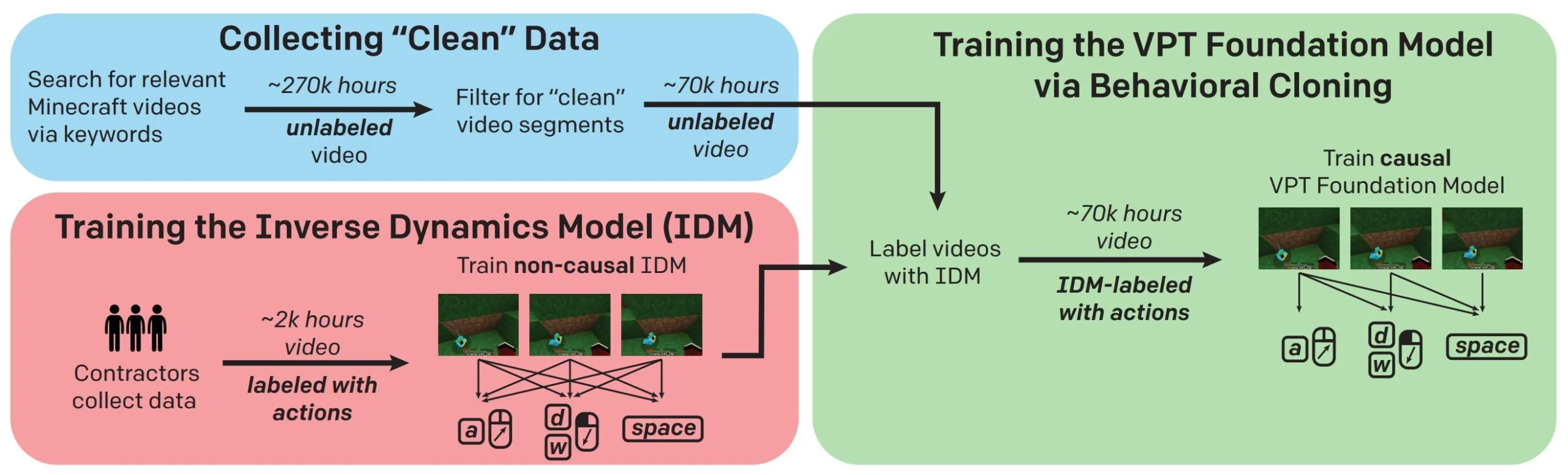

Konkret sammelte OpenAI knapp 270.000 Stunden Minecraft-Videos, die auf knapp 70.000 Stunden reines Gameplay heruntergeschnitten wurden. Zusätzlich nahmen Menschen gegen Bezahlung weitere 2.000 Stunden Gameplay inklusive Tastatur- und Maus-Eingabedaten auf. OpenAI investierte für diese Videos knapp 2.000 US-Dollar.

Mit den gelabelten Videodaten trainierte OpenAI ein sogenanntes Inverse Dynamics Model (IDM), das aus Bildern vergangener und zukünftiger Ereignisse im Gameplay lernte, die entsprechenden Tastatur- und Maus-Eingaben vorherzusagen.

Das IDM labelte anschließend die 70.000 Stunden rohes Gameplay - die geringe Investition von 2.000 US-Dollar erschloss also einen massiven Datenschatz.

Diesen gelabelten, riesigen Videodatensatz nutzte OpenAI für das Training des sogenannten "VPT Foundation Model", das im Training aus Inputs und vergangenen Bildern zukünftige Aktionen vorhersagen muss. So lernt das Modell, das Verhalten menschlicher Spieler:innen vorherzusagen und zu klonen.

OpenAIs Modell zeigt interessante Zero-Shot-Fähigkeiten

Das VPT-Modell setzt OpenAI in Minecraft mit einer 20Hz Bildwiederholrate sowie simulierter Maus und Tastatur ein. Mit dem bloßen Videotraining (Zero-Shot) kann das KI-Modell Aufgaben erledigen, die mit bloßen bestärkendem Lernen bisher fast unmöglich waren: Es kann Bäume fällen, Stämme sammeln, die Stämme zu Brettern verarbeiten und aus diesen Brettern einen Crafting Table herstellen. Laut OpenAI benötigen Menschen dafür etwa 50 Sekunden oder 1.000 aufeinanderfolgende Spielhandlungen.

Video: OpenAI

Das Modell zeigt zudem weitere komplexe Handlungen, etwa Schwimmen, das Jagen von Tieren für Nahrung, das Essen dieser Nahrung und auch das "Säulenspringen", bei dem durch wiederholtes Springen und das Platzieren eines Blocks unter sich Spieler:innen sich in die Höhe bewegen.

OpenAI trainierte das KI-Modell zusätzlich mit gelabelten Videos von Minecraft-Gameplay aus den ersten zehn Minuten eines neuen Spiels, um zu überprüfen, ob sich das Modell so für zuverlässige "Early-Game"-Fähigkeiten fein abstimmen lässt.

Die Forschenden stellten nach diesem Feintraining eine massive Verbesserung bereits angelegter Fähigkeiten im Early-Game fest. Zudem ist das fein abgestimmte Modell in der Lage, tiefer in den Technologiebaum vorzudringen und Holz- und Steinwerkzeuge herzustellen. In Einzelfällen sei sogar der rudimentäre Bau von Unterkünften oder das Durchsuchen von Dörfern inklusive des Plünderns von Truhen zu beobachten.

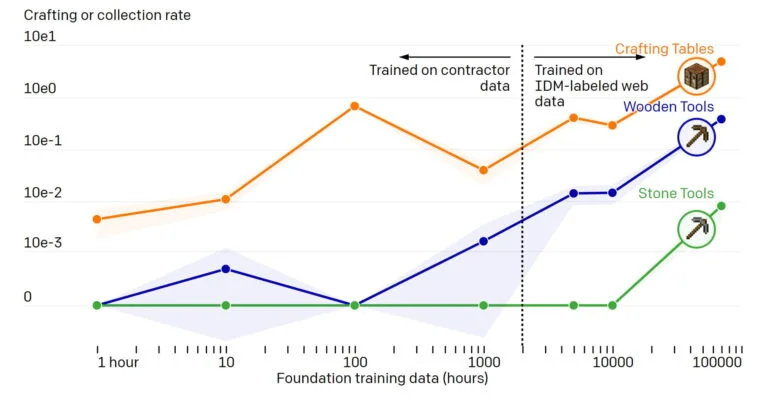

In einem Vergleich zeigt OpenAI außerdem, dass ein KI-Modell, das lediglich mit den von Menschen gelabelten Videodaten trainiert wird, nicht die Crafting-Fähigkeiten des VPT-Modell erreicht. Auch hier gilt: mehr Daten, bessere Ergebnisse.

OpenAI knackt den Weg zur Diamant-Spitzhacke

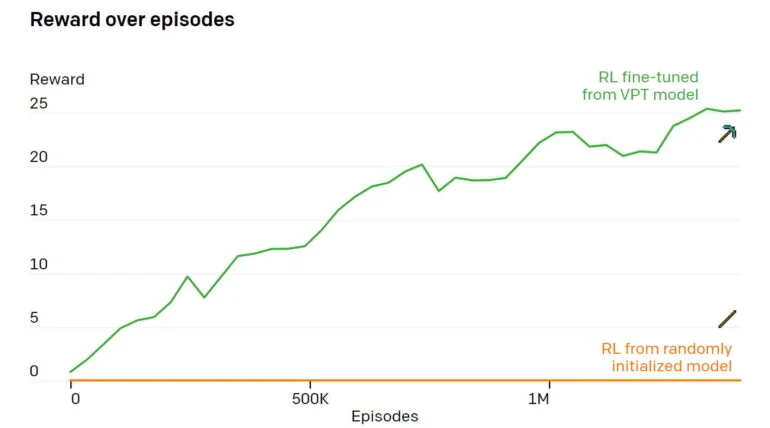

In einem weiteren Schritt nutzt OpenAI das vortrainierte und anschließend fein abgestimmte VPT-Modell als Grundlage für einen KI-Agenten, der bestärkend lernt, eine Diamant-Spitzhacke in zehn Minuten herzustellen.

Während des Trainings wird der Agent für die Sammlung und Herstellung der relevanten Objekte auf dem Weg zur Spitzhacke belohnt. Die gelernte Nachahmung des menschlichen Verhaltens stellt sich wie erwartet als ein besserer Ausgangspunkt dar, als die sonst von Agenten des bestärkenden Lernens zufällig durchgeführten Aktionen.

So erzielt eine solche zufällig initialisierte Strategie laut OpenAI kaum Belohnungen, da sie nie lernt, Stämme zu sammeln und nur selten Stöcke sammelt. Die auf das VPT-Modell aufbauenden Agenten lernen dagegen in 80 Prozent der Fälle Eisen-Spitzhacken herzustellen, sammeln in knapp 20 Prozent der Fälle Diamanten und schaffen es in 2,5 Prozent der Fälle, eine Diamant-Spitzhacke herzustellen.

Damit liegt das KI-System im Schnitt etwa auf menschlichen Niveau, so OpenAI. Es sei das erste KI-Modell, dass in einer Minecraft-Welt ohne Einschränkungen eine Diamant-Spitzhacke herstellen könne.

Video: OpenAI

Das Modell entwickle außerdem nützliche Fähigkeiten für den Diamantenabbau, wie effiziente Abbaumuster, die Höhlenerkundung, die Rückkehr zu zuvor platzierten Objekten wie dem Crafting Table und fortgeschrittene Techniken wie die Verwendung von Holz-Spitzhacken als Treibstoff beim Übergang zu Eisenwerkzeugen.

OpenAI will mit noch mehr Daten trainieren - und plant neue Experimente

Für weitere Verbesserungen sei es möglich, bis zu eine Million Stunden an Minecraft-Trainingsvideos zu sammeln, schätzen die Forschenden. Größere und besser abgestimmte Modelle versprechen weitere Verbesserungen.

Das aktuelle VPT-Modell ist zudem nur auf vergangene Beobachtungen konditioniert, kann also nicht gezielt gesteuert werden. Das Team von OpenAI konnte in einem ersten Test mit 17.000 Stunden Videomaterial inklusive zugehöriger Untertitel jedoch zeigen, dass eine Kombination aus VPT plus Training mit der Sprache, die diese Video begleitet, eine gewisse Steuerbarkeit erzeugt.

Da in den Gameplay-Videos die Sprecher:innen manchmal ihr Vorhaben sprachlich kommentieren (z.B. "Lass uns ein paar Bäume fällen, um eine Holzaxt zu machen") könne das Modell Zusammenhänge zwischen der Sprache und den gelernten Verhaltensgrundlagen herstellen.

Bei Sätzen, die den KI-Agenten zur Erkundung anregen (z. B. "Ich gehe auf Erkundungstour" und "Ich werde Wasser finden"), entferne sich der KI-Agent deutlich weiter von seinem Startpunkt. Außerdem sammle der Agent bevorzugt frühe Spielgegenstände wie Samen, Holz und Erde, wenn er mit Texten wie "Ich werde Samen sammeln / Holz hacken / Erde sammeln" angeregt werde.

Noch sei diese Steuerbarkeit zu schwach, um nützlich zu sein. Doch mehr Trainingsdaten, mehr Rechenleistung und ein multimodaler Trainingsprozess, in dem das Modell in letzter Stufe die nächste Aktion und den nächsten Text zusammen vorhersagen lernt, könnten das ändern, vermutet das Team.

OpenAI stellt die von Menschen aufgenommenen Videodaten inklusive Eingabedaten, die Minecraft-Umgebung, den Modellcode und die Modell-Weights als Open-Source zur Verfügung.

Das Unternehmen hat sich zudem dieses Jahr mit dem MineRL-NeurIPS-Wettbewerb zusammengetan: Alle Teilnehmenden können OpenAIs Modelle verwenden und nachtrainieren, um die Aufgaben des Wettbewerbs zu lösen.

OpenAI nutzt Minecraft für Forschung an Foundation Models

Für OpenAI zeigt das VPT-Modell, dass Video PreTraining den Weg für KI-Agenten ebnet, die durch das Betrachten von großen Mengen an Internetvideos lernen, zu handeln. VPT zeige, dass das semi-überwachte Imitationslernen aus großen und frei verfügbaren Videodatensätzen für Domänen, die sequenzielle Entscheidungen erfordern, funktionieren könne.

Das so entstandene VPT-Model sei ein "Foundation Model", ähnlich den großen Sprachmodellen wie OpenAIs GPT-3 und könne - wie an Minecraft demonstriert - mit weiteren Daten fein abgestimmt oder als Grundlage für KI-Agenten, die bestärkend lernen, genutzt werden. Ermöglicht wird das Training des Foundation Models durch das IDM, welches im Falle von Minecraft für die Internetvideos die passenden Eingabedaten generiert.

Diese Methode sei ein zentraler Baustein für das VPT: "Das Internet enthält eine enorme Menge an öffentlich zugänglichen Videos, aus denen wir lernen können. Sie können beobachten, wie eine Person eine großartige Präsentation hält, wie ein digitaler Künstler einen wunderschönen Sonnenuntergang malt oder wie ein Minecraft-Spieler ein kompliziertes Haus baut", schreibt OpenAI im Blog-Beitrag zu VPT. "Diese Videos geben jedoch nur wieder, was passiert ist, nicht aber, wie es genau gemacht wurde, d. h. sie kennen etwa nicht die genaue Abfolge der Mausbewegungen und gedrückten Tasten."

Ähnlich wie bei Foundation Models für Sprache zeigt sich auch bei VPT der Trend zu besseren Fähigkeiten bei mehr Trainingsdaten. Das größte Modell liegt bei knapp 500 Millionen Parametern. Für die Experimente setzte OpenAI jedoch aus Kostengründen auf ein kleineres Modell mit 220 Millionen Parametern.

Grundsätzlich ermögliche das Lernen mit der menschlichen Tastatur- und Mausschnittstelle eine verlustfreie Modellierung der gesamten Bandbreite menschlichen Verhaltens in Minecraft, so OpenAI.

VPT biete daher auch einen allgemeinen Ansatz für das Training von Verhaltensgrundlagen ("behavorial priors") in schweren, aber generischen Handlungsräumen in jeder Domäne, die eine große Menge an frei verfügbaren, ungelabelten Daten habe - etwa der Computernutzung.

Das umfasst neben Minecraft nahezu jede Software, über die es genug Videomaterial gibt. Sollte OpenAI die Steuerbarkeit der Modelle durch die Integration der Audio-/Untertitelspur verbessern, könnten schon bald Modelle entstehen, die alltägliche Software rudimentär bedienen können. Diese Modelle könnten etwa über die OpenAI-API DALL-E 2 Bilder direkt in Photoshop bearbeiten.

Wer mehr über den Einsatz Künstlicher Intelligenz abseits der Sprache und über Probleme und Chancen des bestärkenden Lernens erfahren will, kann sich unseren DEEP MINDS #1 mit Tim Rocktäschel (mittlerweile bei Deepmind) anhören.