OpenAI positioniert GPT-5.2-Codex als Werkzeug für die Cyberabwehr

Kurz & Knapp

- OpenAI veröffentlicht GPT-5.2-Codex, ein KI-Modell, das komplexe Aufgaben lösen und Schwachstellen aufdecken kann; geprüfte Sicherheitsexperten erhalten exklusiven Zugang mit weniger restriktiven Filtern.

- Verbesserte Kontextkomprimierung und optimierte Bildverarbeitung sorgen für effizientere Analysen und genauere Interpretation technischer Diagramme.

- In Benchmarks erzielt das Modell nur geringe Leistungssteigerungen gegenüber dem Vorgänger, wird aber gezielt für Cybersicherheitsanwendungen positioniert.

Das neue KI-Modell GPT-5.2-Codex soll als autonomer Software-Agent komplexe Aufgaben lösen. Da die Technologie auch effektiv Schwachstellen finden kann, startet OpenAI ein exklusives Zugangsprogramm: Geprüfte Experten erhalten Zugriff auf eine Version mit gelockerten Sicherheitsfiltern.

Technisch setzt OpenAI dabei auf eine weiterentwickelte Kontextkomprimierung ("Compaction"). Diese Methode hilft dem Modell, lange Konversationsverläufe und umfangreiche Code-Analysen effizienter zu verarbeiten. Das System soll so auch bei komplexen Projekten den Überblick behalten und baut damit direkt auf den Fähigkeiten des Vorgängers GPT-5.1-Codex-Max auf. Dieser war bereits darauf ausgelegt, sogar länger als einen Tag an einer Aufgabe zu arbeiten.

Zudem hat OpenAI die Bildverarbeitung optimiert, damit GPT-5.2-Codex technische Diagramme oder Screenshots von Benutzeroberflächen präziser interpretieren kann. Auch die Steuerung von nativen Windows-Umgebungen funktioniert laut Hersteller nun zuverlässiger als noch beim Vorgängermodell.

Benchmarks zeigen nur leichte Gewinne

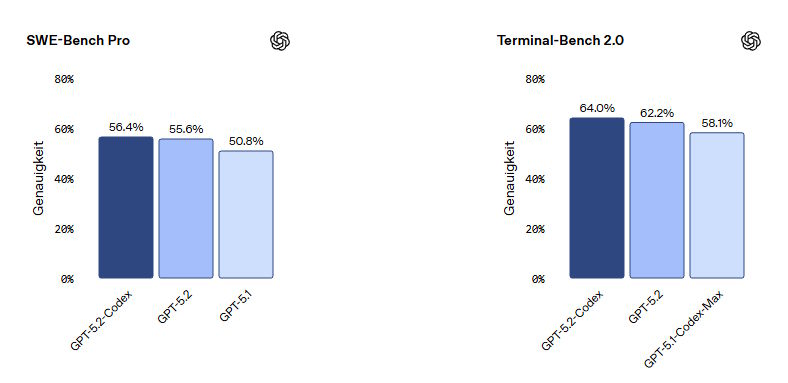

In standardisierten Tests zeigt das neue Modell allerdings nur leichte Verbesserungen gegenüber der Basisversion. Im SWE-Bench Pro simuliert die Software die Lösung realer Probleme in GitHub-Repositories. Hier erreicht GPT-5.2-Codex eine Lösungsrate von 56,4 Prozent, während die Standardversion bereits bei 55,6 Prozent liegt.

Im Terminal-Bench 2.0 steigt die Genauigkeit etwas stärker auf 64 Prozent. Dieser Test prüft, wie gut KI-Agenten Kommandozeilen-Tools bedienen, Server einrichten oder Code kompilieren können.

KI als Werkzeug für Hacker und Sicherheitsforscher

Ein Schwerpunkt der Veröffentlichung liegt auf der Cybersicherheit. Die gesteigerte Fähigkeit zur Code-Analyse lässt sich sowohl für die Verteidigung als auch für Angriffe nutzen. OpenAI führt als Beleg einen Vorfall aus jüngerer Vergangenheit an. Der Sicherheitsforscher Andrew MacPherson soll eine frühere Version des Modells für die Untersuchung einer Schwachstelle im React-Framework genutzt haben.

Die KI entdeckte dabei unerwartete Verhaltensweisen. Diese führten nach weiterer Analyse zu drei bis dahin unbekannten Sicherheitslücken um Dienste lahmzulegen oder Quellcode offenzulegen. Die Entdeckung zeigt laut OpenAI, wie autonome KI-Systeme die Arbeit von Sicherheitsforschern beschleunigen können.

Diese Fähigkeiten bergen Risiken. OpenAI bewertet das Modell in seinem Preparedness Framework mittlerweile fast auf der Stufe "Hoch" im Bereich Cybersicherheit. Als Reaktion darauf führt das Unternehmen ein Programm für vertrauenswürdigen Zugang ein.

Es richtet sich an geprüfte Sicherheitsexperten und Organisationen. Teilnehmer erhalten einen Zugriff auf die Modelle, der weniger restriktiv ist als die öffentliche Version. Fachleute sollen so Sicherheitslücken suchen können, ohne von den Schutzfiltern der KI blockiert zu werden.

GPT-5.2-Codex steht ab sofort zahlenden Nutzern von ChatGPT zur Verfügung. Die Integration erfolgt über die Kommandozeile, Entwicklungsumgebungen und die Cloud. Eine Schnittstelle für Drittanbieter soll bald folgen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren