OpenAI will bis März 2028 eine autonome Forschungs-KI entwickeln

OpenAI hat im Rahmen der tiefgreifenden Änderungen an seiner Organisationsstruktur erstmals einen Zeitplan für seine KI-Forschung veröffentlicht. CEO Sam Altman und Chief Scientist Jakub Pachocki gaben auch Einblicke in den künftigen Kurs der Infrastruktur- und Sicherheitsstrategie.

In einer ausführlichen Präsentation erklärte Sam Altman zusammen mit Chief Scientist Jakub Pachocki, dass OpenAI sein Selbstverständnis von der Entwicklung künstlicher allgemeiner Intelligenz (AGI) neu justiert habe. Statt einer orakelhaften Intelligenz wolle das Unternehmen Werkzeuge schaffen, mit denen Menschen die Zukunft gestalten.

Altman gliederte OpenAIs Arbeit in drei Säulen: Forschung, Produkt und Infrastruktur. Alle drei seien notwendig, um AGI als nützliches Werkzeug bereitzustellen. Ziel sei eine persönliches AGI, das Menschen in Arbeit und Alltag assistiert, kombiniert mit Anwendungen wie ChatGPT, einem eigenen Browser (Atlas) und künftigen Geräten, mit denen sich KI überall nutzen lassen soll.

Zeitplan für KI-Forscher und neue Sicherheitsarchitektur

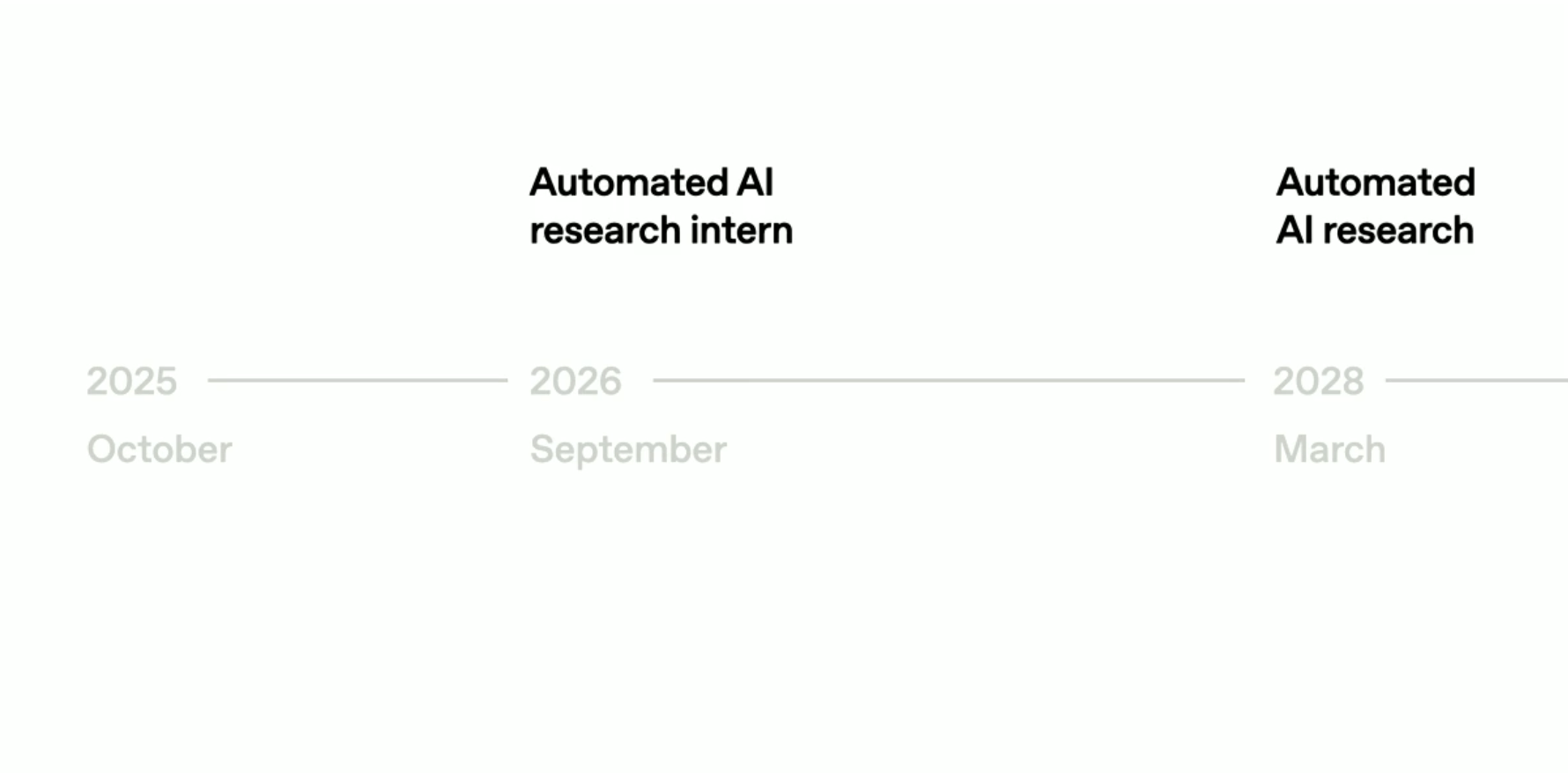

Pachocki stellte die ehrgeizige Forschungsagenda vor. Nach Angaben des Chief Scientists soll OpenAI bis September 2026 ein KI-System mit Forschungspraktikanten-Fähigkeiten entwickeln, das menschliche Wissenschaftler bedeutend beschleunigen könne. Bis März 2028 plant das Unternehmen die Fertigstellung eines voll autonomen KI-Forschers, der eigenständig Forschungsprojekte durchführt.

Als theoretische Grundlage nannte Pachocki die fortgesetzte Skalierung von Deep-Learning-Systemen, insbesondere über In-Context Compute – Rechenleistung zur Laufzeit, die das Denken eines Modells verlängert.

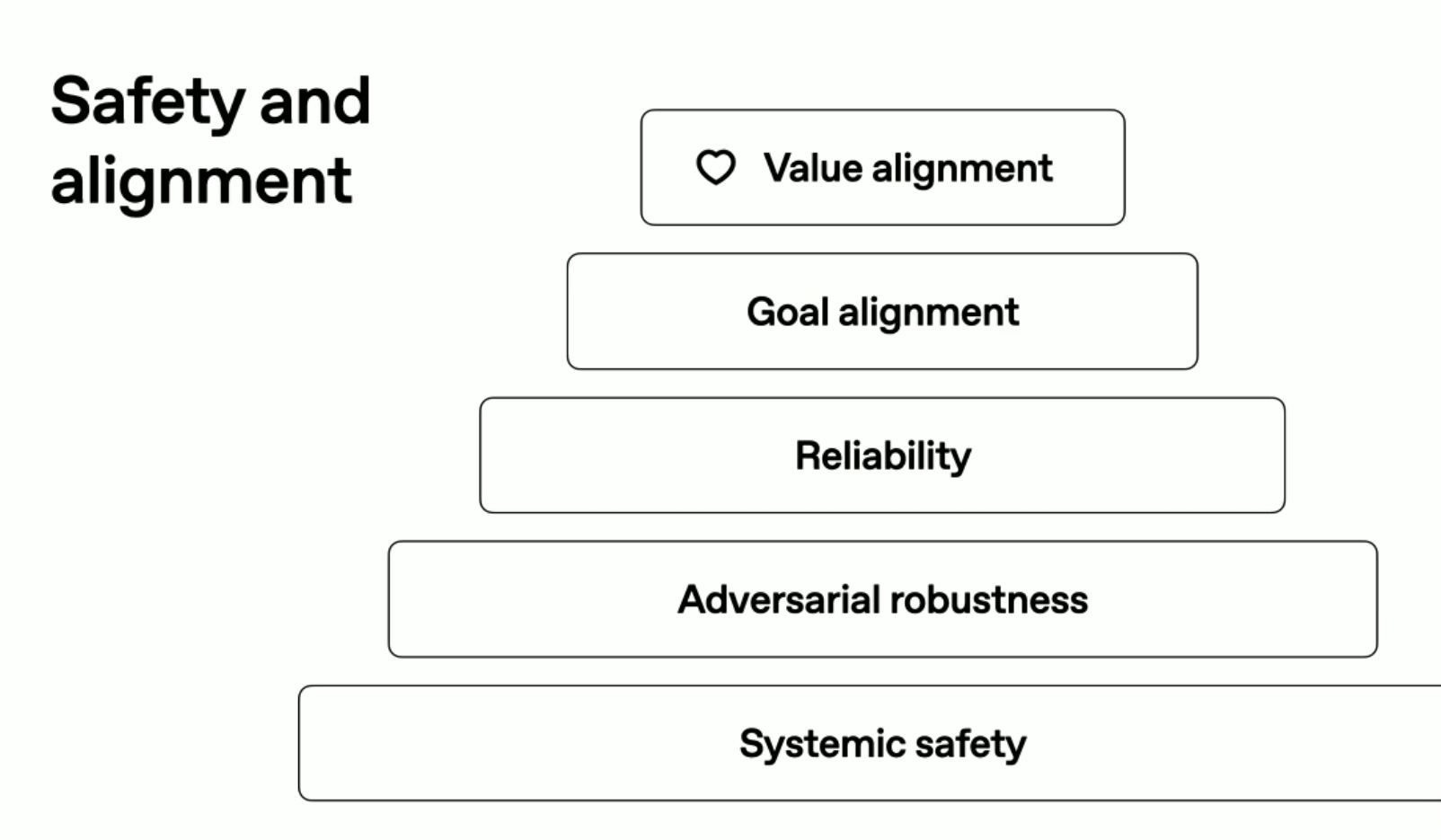

Für die Sicherheitsarbeit stellte er ein Fünf-Ebenen-Modell vor, das von der Wertausrichtung (was eine KI anstrebt) über Zielausrichtung und Zuverlässigkeit bis hin zur systemischen Sicherheit reicht. Eine zentrale neue Methode ist die Forschung an Chain-of-Thought Faithfulness, einem Ansatz, bei dem das interne Denken von Modellen teilweise unbeaufsichtigt bleibt. Dadurch könnten die negativen Effekte der Trainingsüberwachung reduziert und echte Rückschlüsse auf den Reasoning-Prozess ermöglicht werden.

GPT-4.5, Nachfolgemodelle und interne Systeme

In der anschließenden Fragerunde äußerten sich Altman und Pachocki auch zu den bestehenden und kommenden Sprachmodellen. Viele Nutzer hatten nach der Zukunft von GPT-4.5 gefragt, das für viele Schreibende als bestes Modell gilt. Nach Angaben von Altman werde GPT-4.5 weiter verfügbar bleiben, bis ein deutlich überlegenes Modell bereitsteht. Er betonte, dass OpenAI im kommenden Jahr mit „viel besseren“ Modellen rechne, insbesondere im Bereich des Schreibens und kreativen Arbeitens.

Altman wies zugleich darauf hin, dass interne Modelle nicht „versteckt“ würden. Es gebe zwar derzeit Prototypen und einzelne Modulteile mit neuen Fähigkeiten, aber kein fertiges System, das den veröffentlichten Modellen weit voraus wäre. Pachocki ergänzte, man habe derzeit viele einzelne Forschungsergebnisse in Entwicklung, die in den nächsten Monaten zu einer bedeutenden Leistungssteigerung zusammengeführt würden.

1,4 Billionen Dollar Infrastruktur und Milliardeninvestitionen

Altman gab in dem Stream auch ungewöhnlich konkrete Zahlen bekannt: OpenAI habe derzeit Infrastrukturverpflichtungen von rund 1,4 Billionen US-Dollar, verteilt auf 30 Gigawatt Rechenkapazität, um die kommenden Modellgenerationen zu betreiben.

Zu den Partnern zählen AMD, Broadcom, Google, Microsoft, Nvidia, Oracle und Softbank. Künftig sollen Fabriken zur Chipproduktion und modulare Stargate-Rechenzentren entstehen, eines davon wird bereits in Abilene, Texas, gebaut.

Langfristig plant OpenAI laut Altman eine Art Infrastruktur-Fabrik, die wöchentlich ein Gigawatt Rechenleistung erzeugt – zum Zielpreis von etwa 20 Milliarden US-Dollar pro Gigawatt über fünf Jahre.

Kooperationen und langfristige Perspektive

Auf die Frage nach der Zusammenarbeit mit anderen KI-Laboren erklärte Altman, OpenAI strebe gemeinsame Sicherheitsstandards und Transparenz mit Konkurrenten wie Anthropic, Google Deepmind und xKI an. Bereits jetzt gebe es gemeinsame Forschungsprojekte etwa zur Interpretierbarkeit neuronaler Netze.

Altman bekräftigte zudem erneut seine Absicht, kein Reklamemodell zu verfolgen: Einnahmen sollen über Abonnements, Geräteverkäufe und Unternehmenslösungen kommen. Langfristig, so Altman, müsse OpenAI jährliche Umsätze in der Größenordnung von Hunderten Milliarden Dollar erzielen, um die Infrastruktur zu finanzieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.