OpenAIs Aardvark soll Software automatisch auf Sicherheitslücken untersuchen

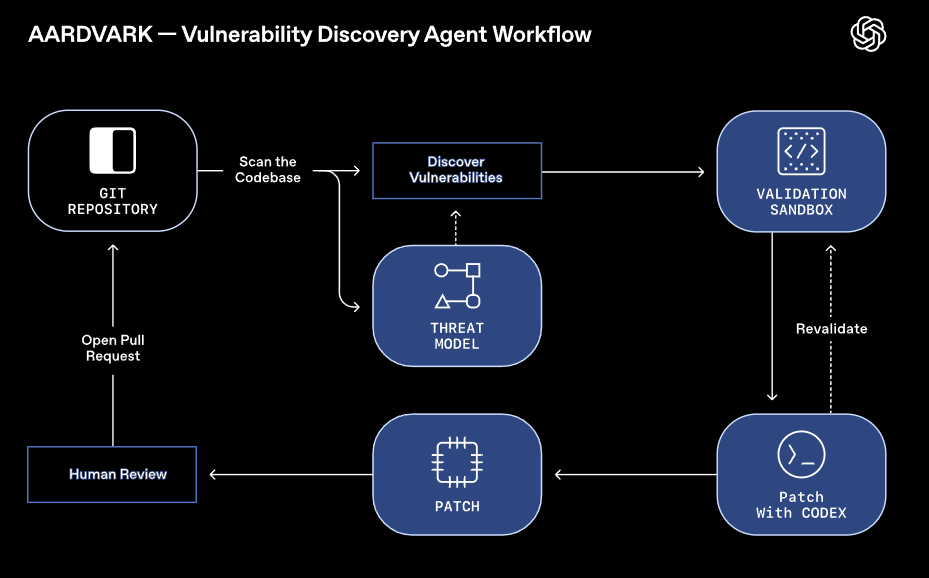

OpenAI testet derzeit Aardvark, ein KI-gestütztes Sicherheitswerkzeug, das Software-Code auf Schwachstellen untersucht. Das System basiert auf GPT-5 und soll wie ein Sicherheitsexperte arbeiten: Es analysiert Code-Repositorien, bewertet potenzielle Risiken, prüft ihre Ausnutzbarkeit in einer Testumgebung und schlägt mögliche Korrekturen vor.

In Tests erkannte die Software laut OpenAI 92 Prozent bekannter und künstlich eingefügter Schwachstellen. Auch in Open-Source-Projekten wurde Aardvark eingesetzt; dabei identifizierte es mehrere Sicherheitsprobleme, die unter anderem mit CVE-Nummern (Common Vulnerabilities and Exposures) versehen wurden.

Aardvark kommt bereits in internen Systemen und bei ausgewählten Partnern zum Einsatz, ist aber derzeit nur in einer geschlossenen Betaversion verfügbar, auf die man sich hier bewerben kann. Ein ähnliches Open-Source-Tool gibt es von Anthropic für Claude.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.