Das KI-Modell Phenaki kann anhand detaillierter, aufeinanderfolgender Texteingaben minutenlange, zusammenhängende Videos generieren.

Am selben Tag wie Metas "Make a Video" machte ein zweites Text-zu-Video-System online die Runde: Es heißt Phenaki und kann laut Angaben der Autoren minutenlange, zusammenhängende Videos anhand aufeinander aufbauender Textbefehle generieren.

Die Autoren sind anonym, da das Paper noch im Review-Prozess für die KI-Fachkonferenz International Conference on Learning Representations (ICLR) ist.

Zeitliche Zusammenhänge

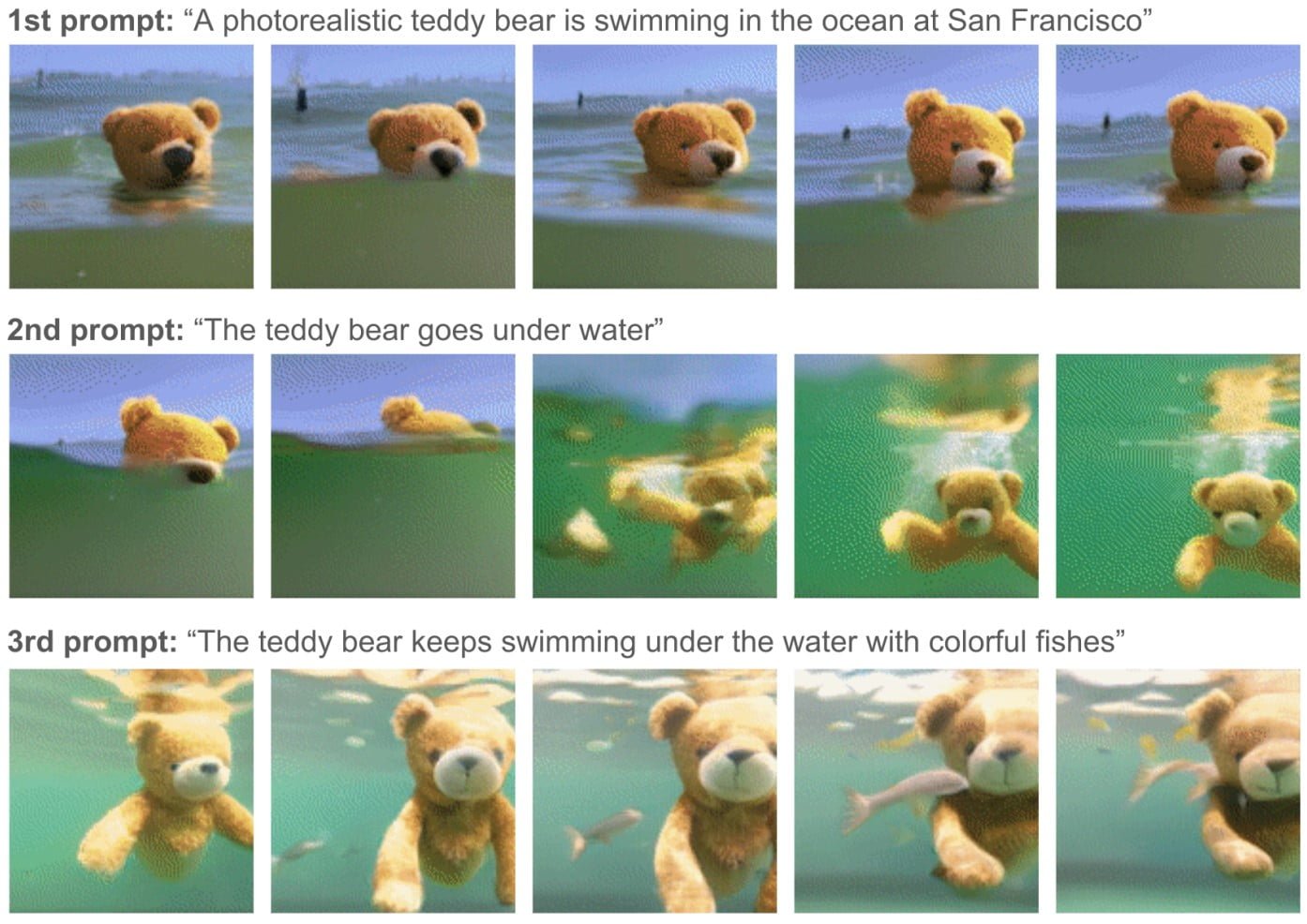

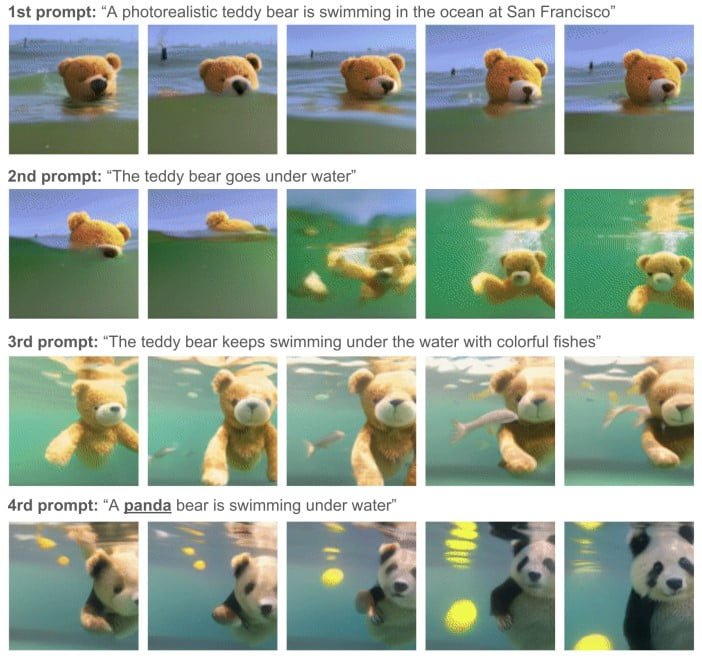

Im Unterschied zu KI-generierten Bildern reichten für KI-generierte Videos einzelne Prompts nicht aus, schreiben die Autoren. Ein KI-Video-System müsse auf mehrere, zusammenhängende Prompts konditioniert werden - eine Story, die Geschehnisse über einen Zeitverlauf beschreibt.

Die Forschenden entwickelten daher ein Transformer-basiertes Modell, das Videos zu kleinen Repräsentationen diskreter Token komprimiert. Dieser Tokenizer verwendet zeitabhängige kausale Aufmerksamkeit, sodass Videosequenzen entlang einer in einem Prompt beschriebenen zeitlichen Reihenfolge von Ereignissen aneinandergereiht werden können.

"In Phenaki behandeln wir Videos als eine zeitliche Abfolge von Bildern (statt einer einzelnen Abfolge, Anm. der Redaktion), was die Anzahl der Video-Token angesichts der Redundanz bei der Videogenerierung erheblich verringert und zu wesentlich geringeren Trainingskosten führt", schreibt das Forschungsteam.

Gleichzeitiges lernen aus Bild- und Video-Text-Paaren

Trainiert wurde das multimodale Modell wie große Bild-KI-Systeme insbesondere mit Text-Bild-Paaren. Zusätzlich trainierten die Forscher Phenaki mit 1,4-Sekunden kurzen Video-Text-Paaren mit acht Bildern pro Sekunde.

"Wir zeigen, wie gemeinsames Training auf einem großen Korpus von Bild-Text-Paaren sowie einer kleineren Anzahl von Video-Text-Beispielen zu einer Generalisierung führen kann, die über das hinausgeht, was in den Videodatensätzen verfügbar ist", schreiben die Forscher.

Das System kann laut der Forscher sogar Prompts verarbeiten, die eine neue Komposition von Konzepten darstellen oder schon vorhandene Bilder anhand einer Texteingabe animieren.

Als Beispiel für ein längeres Video zeigt das Team den folgenden Clip. Er wurde anhand eines ausführlichen Textbefehls generiert, der Szene für Szene beschreibt.

Viel Verkehr in einer futuristischen Stadt. Ein außerirdisches Raumschiff kommt in der futuristischen Stadt an. Die Kamera geht in das Innere des außerirdischen Raumschiffs. Die Kamera bewegt sich vorwärts, bis sie einen Astronauten in einem blauen Raum zeigt. Der Astronaut tippt auf der Tastatur. Die Kamera bewegt sich von dem Astronauten weg. Der Astronaut verlässt die Tastatur und geht nach links. Der Astronaut verlässt die Tastatur und geht weg. Die Kamera bewegt sich über den Astronauten hinaus und blickt auf den Bildschirm. Auf dem Bildschirm hinter dem Astronauten sind Fische zu sehen, die im Meer schwimmen. Crash zoomt auf den blauen Fisch. Wir folgen dem blauen Fisch, wie er im dunklen Ozean schwimmt. Die Kamera zeigt durch das Wasser nach oben in den Himmel. Der Ozean und die Küstenlinie einer futuristischen Stadt. Crash-Zoom in Richtung eines futuristischen Wolkenkratzers. Die Kamera zoomt in eines der vielen Fenster. Wir befinden uns in einem Büroraum mit leeren Schreibtischen. Ein Löwe rennt auf den Schreibtischen herum. Die Kamera zoomt auf das Gesicht des Löwen im Inneren des Büros. Zoom auf den Löwen, der einen dunklen Anzug trägt, in einem Büroraum. Der Löwe im Anzug schaut in die Kamera und lächelt. Die Kamera zoomt langsam auf das Äußere des Wolkenkratzers hinaus. Zeitraffer des Sonnenuntergangs in der modernen Stadt

Video: Phenaki Demo

Zunächst keine Veröffentlichung wegen ethischer Bedenken

Trainiert wurde Phenaki laut der Autoren mit einer Reihe Datensätze, darunter der LAION-400M Datensatz, der zwar gewalthaltige, gewaltverherrlichende und pornografische Inhalte enthalte, aber die Qualität der Generierung verbessert habe. In einer aktuellen Phenaki-Version kämen Datensätze zum Einsatz, die "solche Probleme" minimierten.

Dennoch möchte das Team aus ethischen Bedenken derzeit keine für Phenaki trainierten Modelle, den Code, die Daten oder eine interaktive Demo veröffentlichen. Vor einer möglichen Veröffentlichung will es zunächst den Zusammenhang aus Daten, Eingaben und gefiltertem Output besser versehen. Zudem will es den enthaltenen Bias in den generierten Videos messen, um Verzerrungen und Vorurteile auf allen Ebenen der Modellentwicklung (Datenauswahl, Training, Filter) zu minimieren.