PhotoGuard soll vor Bildmanipulation durch KI-Modelle schützen

KI-Bilder werden immer realistischer und bisher gibt es keine zuverlässige Methode, sie zurückzuverfolgen. Forschende des MIT wollen zumindest Originalbilder besser vor KI-Manipulationen schützen.

Statt Manipulationen aufzuspüren, wollen die Forschenden die Originalbilder robuster machen, sodass Manipulationen gar nicht oder nur mit deutlich höherem Aufwand möglich sind.

"PhotoGuard" heißt das System, das minimale Pixelstörungen in ein Originalbild einbringt, die für Menschen unsichtbar sind, aber von KI-Systemen wahrgenommen werden. Diese Störungen sollen Bildmanipulationen erheblich erschweren. Entwickelt wurde das System vom Computer Science and Artificial Intelligence Laboratory (CSAIL) des Massachusetts Institute of Technology (MIT).

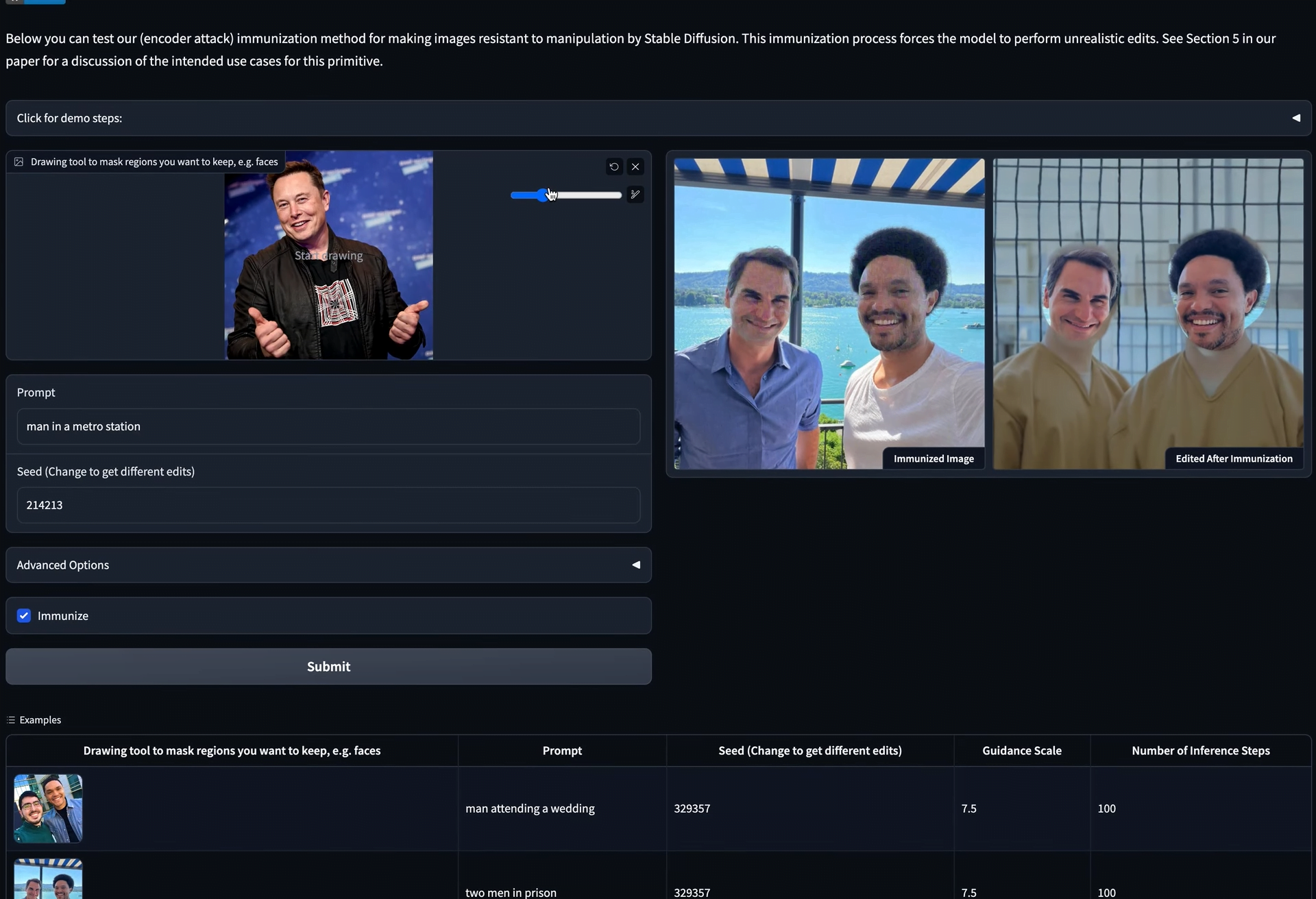

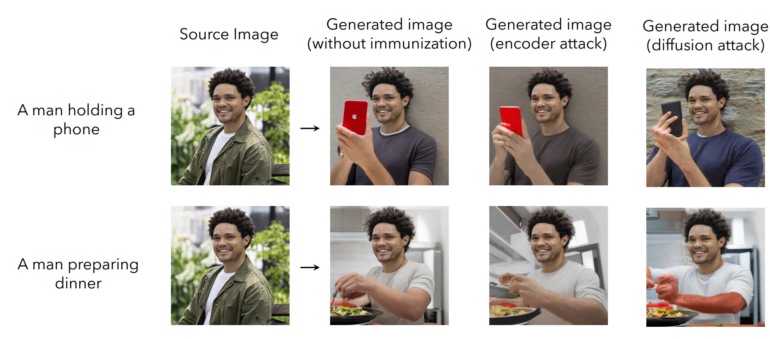

PhotoGuard verwendet zwei Methoden, um ein Bild gegen Manipulationen durch KI zu "immunisieren". Die erste Methode, der sogenannte "Encoder"-Angriff, zielt auf die im KI-Modell vorhandene Abstraktion des Bildes im latenten Raum und manipuliert dort die Daten so, dass das Modell das Bild nicht mehr eindeutig als solches erkennt und Fehler einbaut. Die Veränderung ist vergleichbar mit einem grammatikalisch falschen Satz, dessen Sinn für uns Menschen noch klar ist, der aber ein Sprachmodell irritieren kann.

Die zweite Methode, der Diffusionsangriff, ist etwas raffinierter: Für ein Originalbild wird ein bestimmtes Zielbild definiert, das durch minimale Pixelveränderungen am Originalbild während der Inferenz bestimmt wird. Wenn das KI-Modell dann versucht, das Originalbild zu verändern, wird es automatisch auf das von den Forschenden definierte Zielbild gelenkt, und das Ergebnis ergibt keinen Sinn mehr. Das folgende Video zeigt das System in Aktion.

Manipulationsschutz direkt in die Modelle integrieren

Die Forschenden schlagen vor, dass ihre oder vergleichbare Schutzmaßnahmen direkt von den Modellentwicklern angeboten werden. Sie könnten zum Beispiel über eine Programmierschnittstelle einen Dienst anbieten, der es ermöglicht, Bilder gegen die Manipulationsmöglichkeiten ihres jeweiligen Modells zu immunisieren. Diese Immunisierung müsste auch mit zukünftigen Modellen kompatibel sein und könnte als Hintertür beim Modelltraining eingebaut werden.

Ein weitreichender Schutz vor KI-Manipulation erfordert einen kollaborativen Ansatz zwischen Entwicklern, Social-Media-Plattformen und der Politik, die beispielsweise vorschreiben könnte, dass auch Modellentwickler Schutzmechanismen anbieten müssen, so die Forschenden.

Sie weisen zudem darauf hin, dass PhotoGuard keinen vollständigen Schutz bietet. Angreifer könnten versuchen, das geschützte Bild zu manipulieren, etwa durch einen neuen Ausschnitt, zusätzliches Rauschen oder eine Drehung. Generell sehen die Forschenden aber Potenzial, robuste Modifikationen zu entwickeln, die solchen Manipulationen standhalten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.