KI-Bildgenerator PixArt-δ generiert hochauflösende KI-Bilder in 0,5 Sekunden

Ist Stable Diffusion im Feld der Open-Source-Bildgeneratoren bald nicht mehr alternativlos? PixArt wird in seiner neusten Entwicklung schneller und genauer und behält seine verhältnismäßig hohe Auflösung dabei bei.

In einem Paper haben Forschende von Huawei Noah's Ark Lab, der Dalian University of Technology, der Tsinghua University und Hugging Face PixArt-δ (Delta) vorgestellt, ein fortschrittliches Framework zur Text-zu-Bild-Synthese, das in Konkurrenz zur Stable-Diffusion-Familie treten soll.

Das Modell ist eine wesentliche Verbesserung des früheren Modells PixArt-α (Alpha), das bereits in der Lage war, Bilder mit einer Auflösung von 1024 x 1024 Pixeln in kurzer Zeit zu generieren.

Hochauflösende Bildgenerierung in einer halben Sekunde

PixArt-δ integriert das Latent Consistency Model (LCM) und ControlNet in das PixArt-α-Modell, was die Inferenzgeschwindigkeit erheblich beschleunigt. Diese Integration ermöglicht die Erzeugung von hochwertigen Bildern in nur zwei bis vier Schritten. Das neue Modell kann 1.024 x 1.024 Pixel große Bilder in 0,5 Sekunden erzeugen, was einer siebenfachen Beschleunigung gegenüber PixArt-α entspricht.

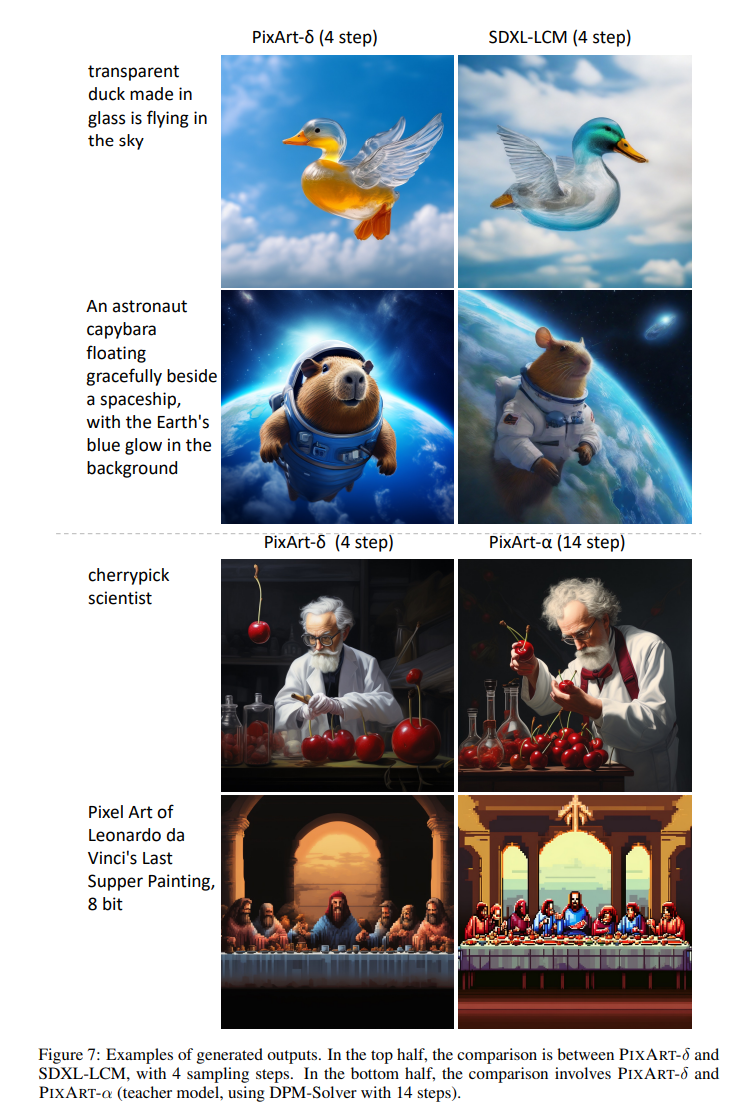

SDXL Turbo, das von Stability AI im November 2023 vorgestellt wurde, erzeugt Bilder mit 512 x 512 Pixeln in nur einem Schritt und damit in etwa 0,2 Sekunden. Die Ergebnisse von PixArt-δ sind jedoch im Vergleich zu denen von SDXL Turbo und einer vierstufigen Variante von SDXL mit LCM höher aufgelöst und machen einen deutlich konsistenteren Eindruck. Es scheinen weniger Bildfehler aufzutreten und das Modell folgt den Prompt-Anweisungen genauer.

Das neue PixArt-Modell ist außerdem so konzipiert, dass es innerhalb eines Tages effizient auf V100-GPUs mit 32 GB VRAM trainiert werden kann. Darüber hinaus kann es dank seiner 8-Bit-Inferenzfähigkeit Bilder mit einer Seitenlänge von 1024 Pixeln sogar auf 8-GB-GPUs synthetisieren, was seine Benutzerfreundlichkeit und Zugänglichkeit erheblich verbessert.

Mehr Kontrolle über die Bildgenerierung

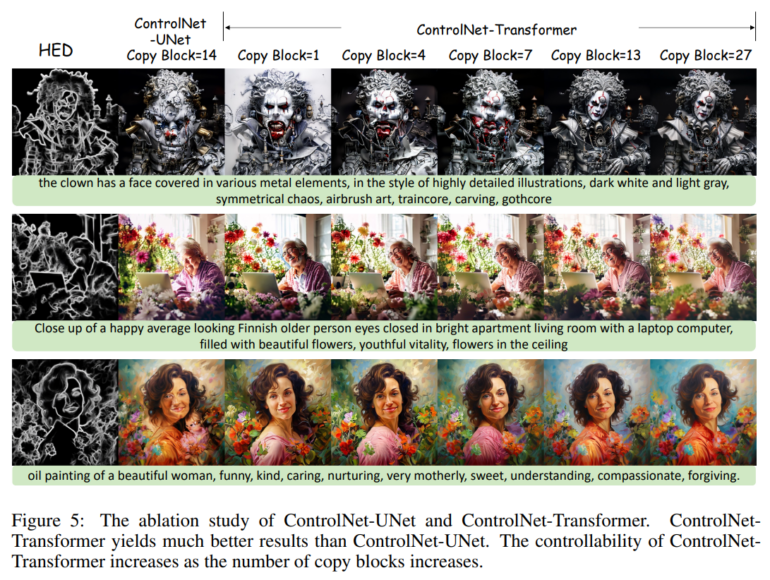

Die Integration eines ControlNet-Moduls in PixArt-δ ermöglicht eine feinere Steuerung von Text-zu-Bild-Diffusionsmodellen mit Hilfe von Referenzbildern. Die Wissenschaftler:innen haben eine neuartige ControlNet-Architektur eingeführt, die speziell für Transformer-basierte Modelle entwickelt wurde und dadurch eine explizite Kontrollierbarkeit bei gleichzeitig qualitativ hochwertiger Bildgenerierung erreicht.

Die Gewichte für die ControlNet-Variante von PixArt-δ stellen die Forschenden bereits auf Hugging Face zur Verfügung. Eine Onlinedemo existiert bislang jedoch offenbar nur von PixArt-α mit und ohne LCM.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.