OpenAIs Point-E ist DALL-E für 3D Objekte. Das extrem schnelle Modell generiert aus Text eine 3D-Punktewolke und anschließend ein Mesh.

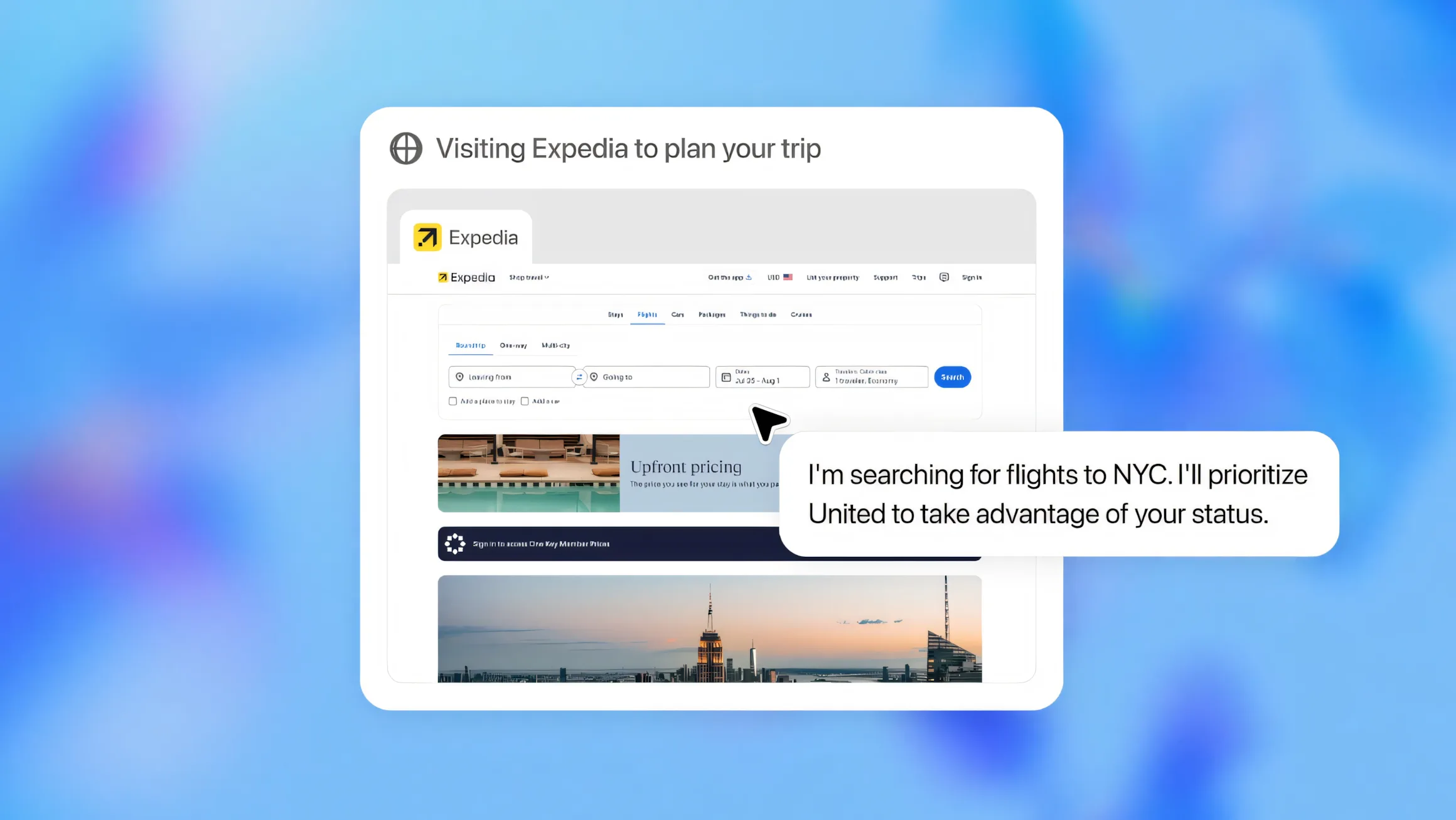

Nachdem OpenAI bereits generative KI-Modelle für Text und für Bilder auf den Markt gebracht hat, zeigt das Unternehmen nun, was als Nächstes kommen könnte: ein Text-zu-3D-Generator. Point-E generiert aus Text-Beschreibungen 3D-Punktwolken, die als Modelle etwa in virtuellen Umgebungen dienen können. Abseits von OpenAI gibt es bereits andere generative KI-Modelle für 3D, etwa Googles Dreamfusion oder Nvidias Magic3D.

Das von OpenAI als Open-Source veröffentlichte Point-E soll jedoch deutlich schneller sein und 3D-Modelle in ein bis zwei Minuten auf einer einzelnen Nvidia V100 GPU generieren können.

OpenAIs Point-E generiert Punktewolke

Dabei generiert Point-E keine 3D-Modelle im klassischen Sinne, sondern Punktwolken, die 3D-Formen repräsentieren. Im Vergleich generiert etwa Googles Dreamfusion NeRFs - das dauert deutlich länger, kann jedoch im Gegensatz zu einer Punktwolke deutlich mehr Details darstellen. Die vergleichsweise niedrigere Qualität von Point-E erlaubt jedoch die Effizienz des Systems.

Die Punktwolke wird anschließend von einem weiteren Modell in Meshs verwandelt, die als Standard im 3D-Modelling und -Design dienen. Laut OpenAI ist dieser Prozess noch nicht fehlerfrei. In einigen Fällen können bestimmte Teile der Wolke falsch verarbeitet werden und zu fehlerhaften Meshs führen.

Zwei generative Modelle in Point-E

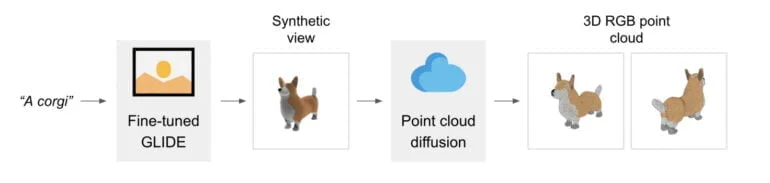

Point-E besteht selbst aus zwei Modellen: einem GLIDE- und einem Bild-zu-3D-Modell. Ersteres ähnelt Systemen wie DALL-E oder Stable Diffusion und kann aus Text-Beschreibungen Bilder generieren.

Das zweite Modell wurde von OpenAI mit Bildern und zugehörigen 3D-Objekten trainiert und lernte so, aus Bildern entsprechende Punktwolken zu generieren. Für das Training nutzte das Unternehmen mehrere Millionen 3D-Objekte und zugehörige Metadaten, heißt es im Paper.

In diesem zweistufigen Prozess kann es jedoch immer wieder zu Fehlern kommen. Point-E ist nicht perfekt, dafür generiert es Objekte fast 600-mal schneller als Dreamfusion. "Das könnte sie für bestimmte Anwendungen praktischer machen oder die Entdeckung von 3D-Objekten höherer Qualität ermöglichen", so das Team.

Wir haben Point-E vorgestellt, ein System zur textbedingten Synthese von 3D-Punktwolken, das zunächst synthetische Ansichten und dann farbige Punktwolken erzeugt, die auf diesen Ansichten basieren. Wir haben festgestellt, dass Point-E in der Lage ist, effizient vielfältige und komplexe 3D-Formen auf der Grundlage von Textaufforderungen.

OpenAI

Point-E ist laut OpenAI ein Startpunkt für weitere Arbeiten in der Text-zu-3D-Synthese und ist als Open-Source auf Github verfügbar. Wenn die Entwicklung von DALL-E 2, ChatGPT und anderen Produkten des Unternehmens als Richtschnur dienen, könnte ein Point-E 2 schon nächstes Jahr den 3D-Markt gehörig aufwirbeln.