Sprachmodelle mit Zugang zu Werkzeugen, so genannte augmentierte Sprachmodelle, haben potenziell viel mehr Fähigkeiten als native Sprachmodelle. Die ReWoo-Methode könnte sie wesentlich effizienter machen.

Das derzeit prominenteste Beispiel für ein erweitertes Sprachmodell ist ChatGPT mit Internetbrowser oder Plugins. Dank dieser Tools kann ChatGPT beispielsweise aktuelle Informationen abrufen oder Rechenaufgaben sicher lösen.

Die Methode ReWOO (Reasoning Without Observation) soll zur Effizienz solcher erweiterten Modelle beitragen. Im HotpotQA-Test, einem mehrstufigen Benchmark für logisches Denken, erzielte sie eine Steigerung der Genauigkeit um vier Prozent bei fünfmal geringerem Tokenverbrauch.

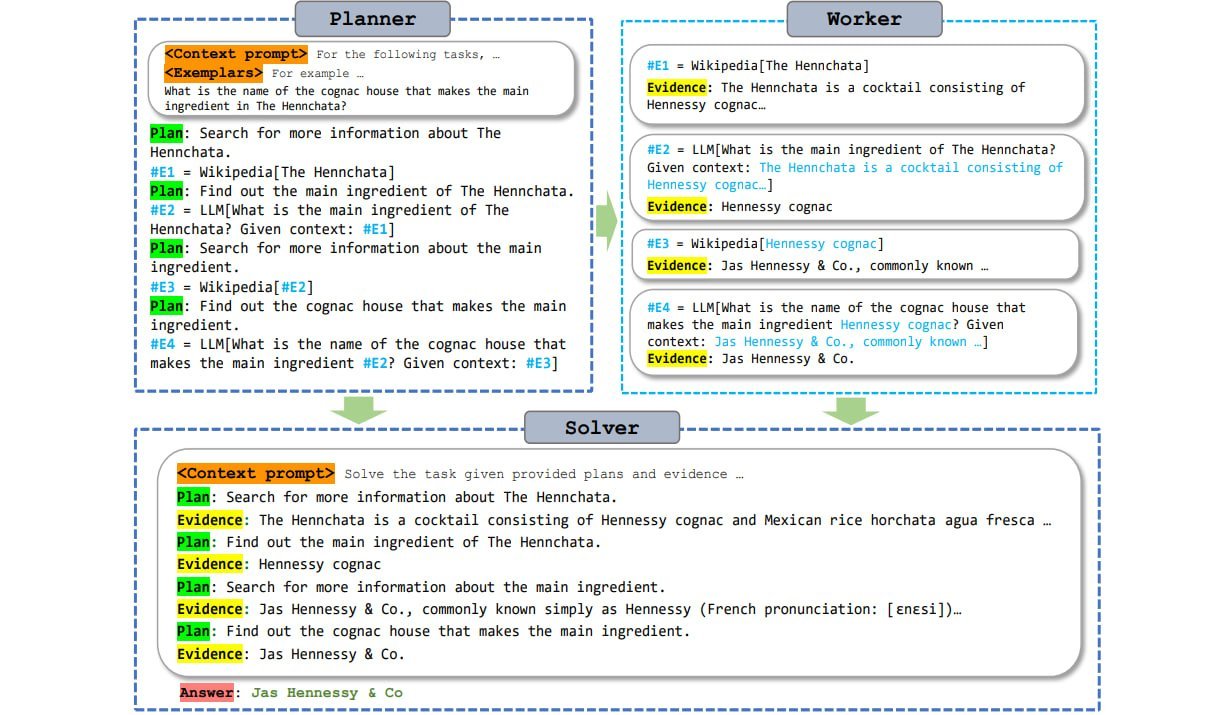

ReWOO entkoppelt dazu die Argumentation des Sprachmodells vom Zugriff auf die Werkzeuge. So müssen die Token aus dem Prompt nur einmal statt mehrfach an das Werkzeug übergeben werden.

Werkzeugzugriff, aber auf Effizienz getrimmt

Derzeit greifen Sprachmodelle auf Werkzeuge zu, indem sie diese aufrufen, ihre Anfrage übergeben, auf die Antwort warten, diese übernehmen und dann entlang der Antwort weiter generieren. Das Modell läuft, stoppt, läuft, stoppt und so weiter. Das kostet Zeit und Rechenleistung und setzt voraus, dass die Prompt-Token mehrfach an das Tool gesendet werden müssen.

ReWOO macht diesen Prozess effizienter, indem das Sprachmodell über ein Planungsmodul die Argumentation vorwegnimmt und definiert, an welchen Stellen in der Antwort Werkzeuge benötigt werden. Das Modell generiert dann alle Teilaufgaben mit allen Fragen und dem vollständigen Text, auch wenn die Informationen der Werkzeuge noch nicht verfügbar sind.

Grob vergleichbar ist dies mit einem Lückentext, der dann in einem einzelnen Schritt mit den Informationen aus den Werkzeugen gefüllt wird. Nach Ansicht der Autoren verfügen große vortrainierte Sprachmodelle über genügend Wissen über die "Form" der Antworten der Werkzeuge, um diese Art des Vorausdenkens zu ermöglichen.

Da das Sprachmodell die Anfragen an das Werkzeug als Subtasks speichert und nur einmal und dann direkt mit allen Fragen stellt, muss der Generierungsprozess nicht ständig angehalten und neu gestartet werden.

Diese "Bulk"-Verarbeitung der Werkzeugaufgaben spart Rechenleistung und macht die augmentierten LLMs damit effizienter. Gerade kleine Modelle sollen durch diesen effizienten, planungsbasierten Werkzeugeinsatz qualitativ bessere Antworten liefern können. Das Fazit der Forscherinnen und Forscher: "Planung ist alles, was man braucht" - eine Anspielung an das legendäre Transformer-Paper mit dem Titel "Aufmerksamkeit ist alles, was man braucht".

Die Forschenden stellen auf Github ein auf Alpaca 7B basierendes ReWOO-Planungsmodell sowie die für das Training verwendeten Datensätze zur Verfügung.